2017

2017 Redaktion Wed, 20.03.2019 - 01:04Artikel über den dramatischen Rückgang der Insekten erzielt 2017 Top-Reichweite in Fachwelt und Öffentlichkeit

Artikel über den dramatischen Rückgang der Insekten erzielt 2017 Top-Reichweite in Fachwelt und ÖffentlichkeitDo, 28.12.2017 - 10:48 — Redaktion

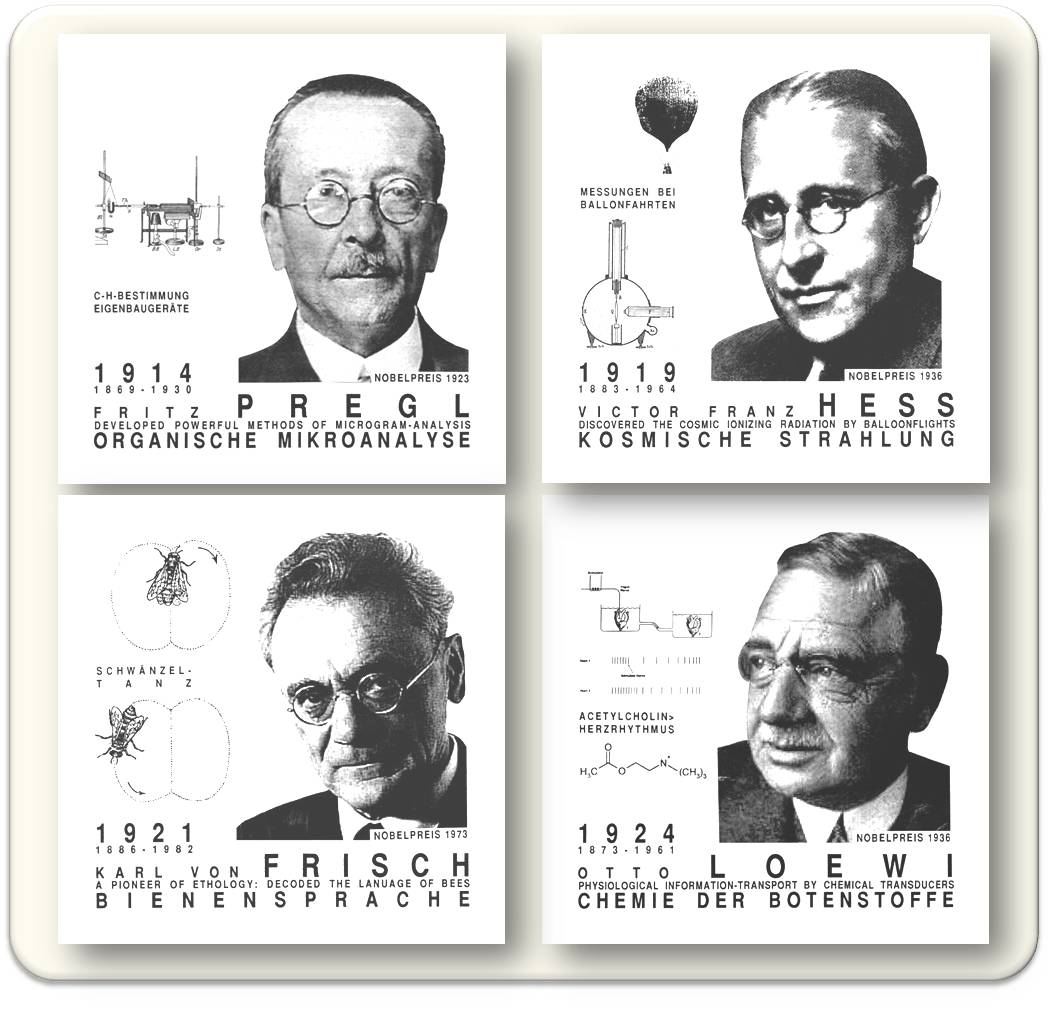

![]() Neue Verfahren zur Abschätzung der Resonanz wissenschaftlicher Veröffentlichungen - sogenannte Altmetrics, spiegeln die online- Kommunikatiosmöglichkeiten wieder und zeigen auf, wie sich wissenschaftliche Informationen in der Fachwelt und ebenso in der Öffentlichkeit verbreiten. das britische Unternehmen Altmetrics.com hat so für 2017 eine Liste der 100 Publikationen mit der größten Reichweite erstellt [1]. Einen der vordersten Plätze nimmt eine Studie ein, die über den dramatischen Rückgang der fliegenden Insekten in deutschen Naturschutzgebieten berichtet [2].

Neue Verfahren zur Abschätzung der Resonanz wissenschaftlicher Veröffentlichungen - sogenannte Altmetrics, spiegeln die online- Kommunikatiosmöglichkeiten wieder und zeigen auf, wie sich wissenschaftliche Informationen in der Fachwelt und ebenso in der Öffentlichkeit verbreiten. das britische Unternehmen Altmetrics.com hat so für 2017 eine Liste der 100 Publikationen mit der größten Reichweite erstellt [1]. Einen der vordersten Plätze nimmt eine Studie ein, die über den dramatischen Rückgang der fliegenden Insekten in deutschen Naturschutzgebieten berichtet [2].

Welche Resonanz haben Artikel mit wissenschaftlichem Inhalt?

In der Fachwelt wird üblicherweise die Häufigkeit angegeben, mit welcher ein Artikel in anderen Arbeiten zitiert wird. Dieser Wert lässt sich einfach feststellen (beispielsweise gibt es diese Information in Google Scholar und ISI-World of Science), wird vielfach mit der Qualität der Publikation gleichgesetzt und zur Beurteilung wissenschaftlicher Leistung herangezogen. Er sagt natürlich nur wenig darüber aus , wie viele Personen das Ganze tatsächlich gelesen (oder auch nur teilweise angesehen) haben und daraus für ihre eigenen Zwecke Gewinn gezogen haben. Insbesondere gibt er auch keinen Hinweis, ob und wieweit ein Wissenstransfer in die Öffentlichkeit erfolgt ist.

Im Zeitalter des Internets, das uns Publikationen online lesen, kommentieren und mit Anderen - auch auf sozialen Plattformen - teilen lässt, ist eine Bewertung auf der Ebene der Zeitschriften zweifellos nicht mehr zeitgemäß - eine Reihe prominenter Wissenschafter hat sich 2012 (San Francisco Declaration of Research Assessment) für eine neue Form ausgesprochen, mit der sich der Einfluss von Publikationen besser bestimmen lässt.

Altmetriken

Die sogenannten Altmetriken bieten derartige Möglichkeiten. Über das Zitate Zählen hinaus erfassen sie weltweit Nennungen, "Liken" und Teilen auf sozialen Netzwerken, Diskutieren und Verlinken auf Webseiten, Nachrichtenportalen und Blogs und Berichte in den Medien (online Zeitungen, TV). Damit geben Altmetrics die Kommunikationsmöglichkeiten wieder, zeigen, wie sich wissenschaftliche Informationen in der Fachwelt und ebenso in der Öffentlichkeit verbreiten.

Einer der wichtigsten Anbieter solcher Daten, das britische Unternehmen Altmetrics.com, scannt täglich über 2000 Massenmedien, die online über Science berichten (darunter auch Standard, Kurier, Presse, NZZ, ORF), Studienpläne ("Open Syllabus Project"), Zitationsplattformen, Wikipedia, an die 11 000 Blogs, Soziale Medien (Facebook, Twitter, etc.), u.a.

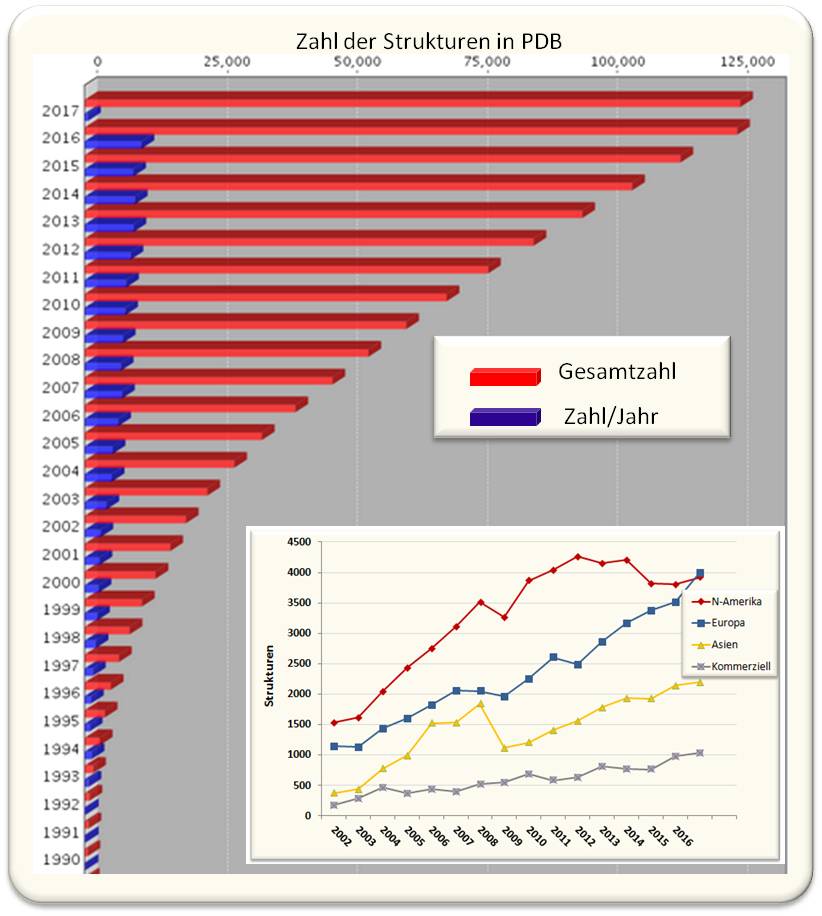

Auf dieser Datengrundlage rankt Altmetrics.com wissenschaftliche Arbeiten seit 2013 und erstellt eine Liste der Top 100 Artikel [1]. Die Liste 2017 basiert auf über 18,5 Millionen Nennungen von 2,2 Millionen unterschiedlichen Forschungsergebnissen aus allen Bereichen der Naturwissenschaften, aus Informations-/Computerwissenschaften, Medizin/Gesundheitswissenschaften, Geschichte/Archäologie und Sozialwissenschaften.

Die Top 10 Artikel im Jahr 2017

Auf der Basis der oben genannten Daten vergibt Altmetrics.com Punkte. Die 10 Artikel mit der höchsten Reichweite sind im folgenden mit Titel und Punktezahl aufgeführt:

- Associations of fats and carbohydrate intake with cardiovascular disease and mortality in 18 countries from five continents (PURE): a prospective cohort study (Lancet) Punkte: 5876 Forscher haben die Ernährung von mehr als 100 000 Menschen in 18 Ländern untersucht: niedriger Fettkonsum kann das Risiko eines vorzeitigen Todes erhöhen.

- Work organization and mental health problems in PhD students (Research Policy ). Punkte: 5060. Arbeitstress von Doktoranden kann deren geistige Gesundheit beeinträchtigen.

- Comparison of Hospital Mortality and Readmission Rates for Medicare Patients Treated by Male vs Female Physicians (JAMA Internal Medicine) Punkte: 4715. Patienten, die von Ärztinnen behandelt wurden haben niedrigere Sterblichkeit und Rückfallsraten

- Correction of a pathogenic gene mutation in human embryos (Nature). Punkte : 4510. Mit CRISPR wurde eine Genmutation im menschlichen Embryo repariert.

- Gender stereotypes about intellectual ability emerge early and influence childrens interests (Science). Punkte: 4410. Stereotypen in der Kindheit bedingen, dass Frauen sich nur widerwillig mit Glanzvollem beschäftigen.

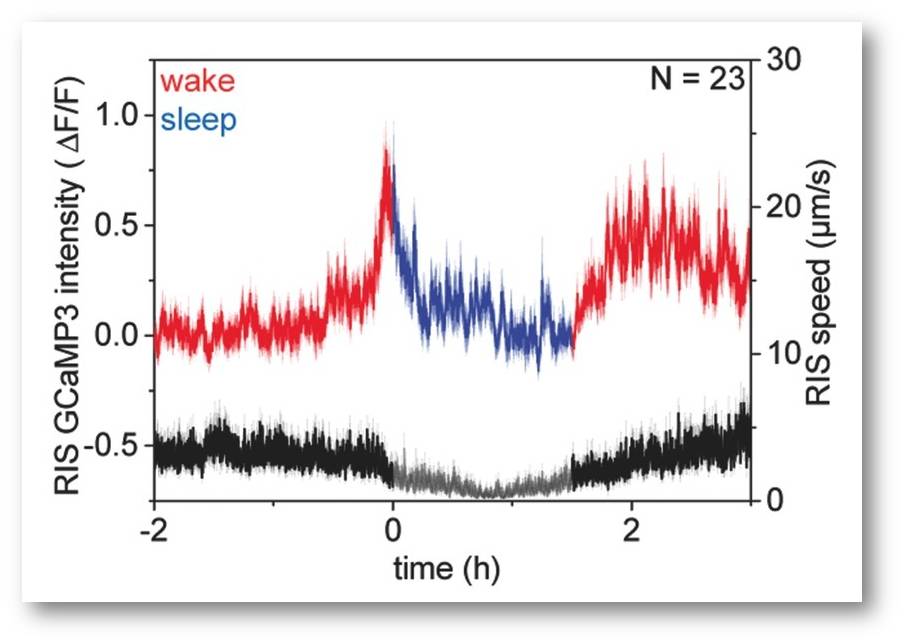

- More than 75 percent decline over 27 years in total flying insect biomass in protected areas. (PLoS One). Punkte: 4281. Der Rückgang fliegender Insekten war viel stärker und schneller als angenommen.

- Worldwide trends in body-mass index, underweight, overweight, and obesity from 1975 to 2016: a pooled analysis of 2416 population-based measurement studies in 128á9 million children, adolescents, and adults. (The Lancet). Punkte: 4016 . Übergewicht bei Kindern und Erwachsenen ist global in den letzten 40 Jahren auf das Zehnfache gestiegen.

- A Feathered Dinosaur Tail with Primitive Plumage Trapped in Mid-Cretaceous Amber. (Current Biology). Punkte: 3985. Eine Dinosaurier-Spezies hatte Zähne, die es im Alter verlor.

- Efficacy and effectiveness of an rVSV-vectored vaccine in preventing Ebola virus disease: final results from the Guinea ring vaccination, open-label, cluster-randomised trial (Ebola ‚a Suffit!) (The Lancet). Punkte: 3920. Eine Ebola-Vakzine zeigte während des Ausbruchs in West-Afrika volle Wirksamkeit.

- An extra-uterine system to physiologically support the extreme premature lamb (Nature Commun.) Punkte: 3837. Eine künstliche Gebärmutter eröffnet neue Möglichkeiten für eine Anwendung am Menschen.

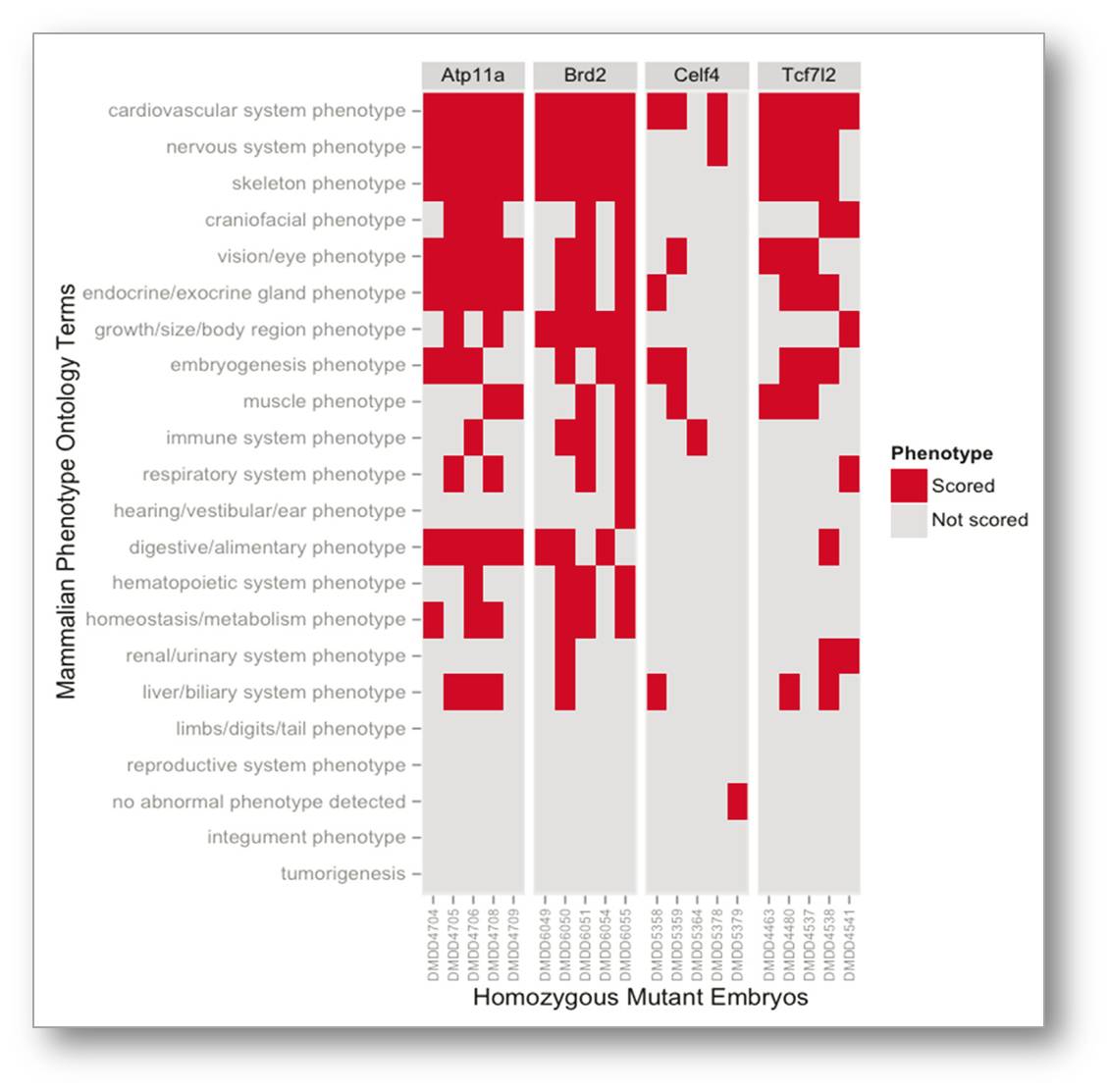

Die Top 10 Artikel sprechen vor allem Gesundheits- und soziale Themen an. Daneben hat auch ein Artikel über eine bestimmte Dinosaurierspezies großes Interesse erweckt. Besonders hervorzuheben ist aber die Untersuchung zum dramatischen Verschwinden der Insekten in Deutschland (Rang 6), die im Folgenden ausführlicher behandelt werden soll. (Eigentlich ist eine noch wesentlich höhere Reichweite anzunehmen: im Vergleich zu den Artikeln auf Platz 1 - 5, die bis zu einem Jahr vor dem Ranking im Internet zugänglich waren, wurde die Insektenstudie erst knapp 1 Monat davor veröffentlicht.) Abbildung 1.

Abbildung 1. Der Rückgang der fliegenden Insekten ist stärker als man angenommen hat. Der farbige „Altmetric Donut“ zeigt durch die unterschiedlichen Farben an und wo der Artikel erwähnt wird : 206 Mal in Nachrichten, 34 mal in Blog-postings, 3 Nennungen in Wikipedia, 123 Mal in Facebook, etc. (Bild: https://www.altmetric.com/top100/2017/#list&article=27610705; open access)

Das Verschwinden der fliegenden Insekten in Deutschland

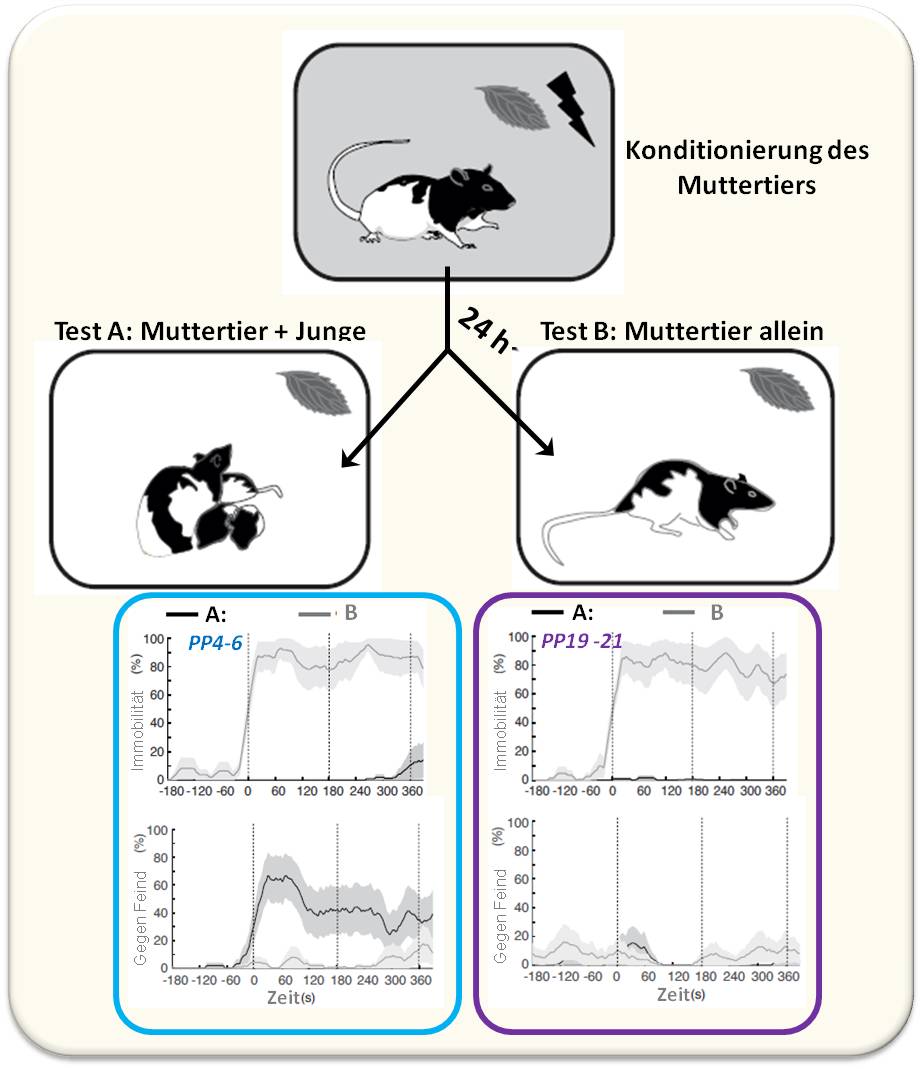

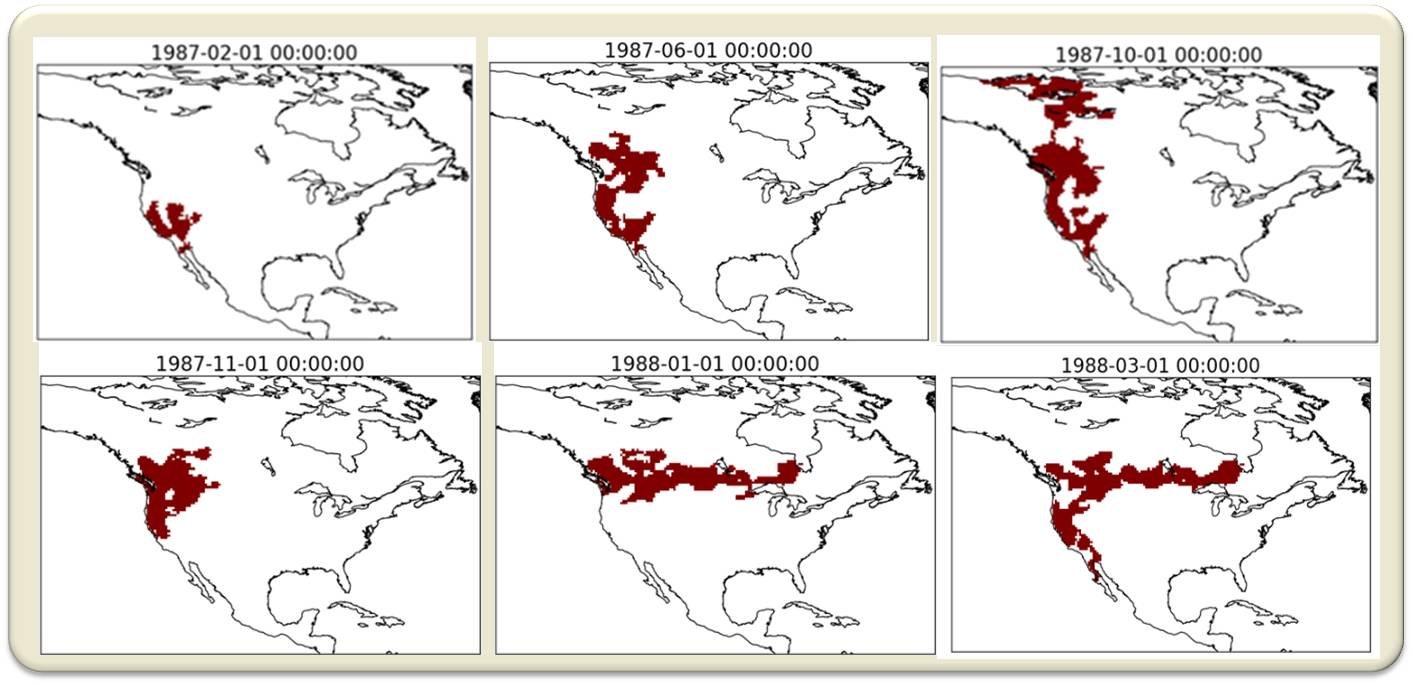

Eine Gruppe von Naturwissenschaftern, darunter zahlreiche Entomologen, hat über 27 Jahre - von 1989 bis 2016 - an 63 Standorten Proben gesammelt. Die Standorte lagen in Naturschutzgebieten und wiesen unterschiedliche Habitatgruppen auf - mageres Grünland, nährstoffarmes Heideland und Dünen -, wie sie für das deutsche Tiefland charakteristisch sind. (Abbildung 2).  Abbildung 2. Malaise-Falle (links) und die Standorte (rechts, gelb) in Naturschutzgebieten in Nordrhein-Westfalen (n = 57), Rheinland-Pfalz (n = 1) and Brandenburg (n = 5). 160 Wetterstationen sind als schwarze Kreuze eingezeichnet (https://doi.org/10.1371/journal.pone.0185809.s006)

Abbildung 2. Malaise-Falle (links) und die Standorte (rechts, gelb) in Naturschutzgebieten in Nordrhein-Westfalen (n = 57), Rheinland-Pfalz (n = 1) and Brandenburg (n = 5). 160 Wetterstationen sind als schwarze Kreuze eingezeichnet (https://doi.org/10.1371/journal.pone.0185809.s006)

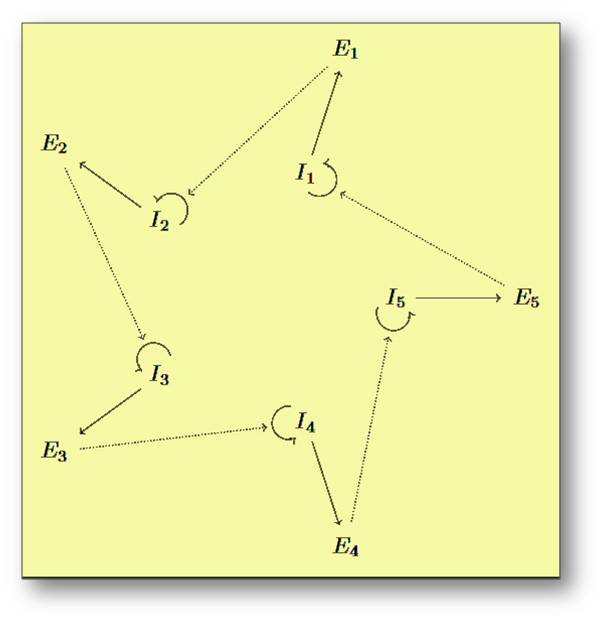

Die fliegenden Insekten wurden dort über die gesamte Vegetationsperiode (März bis Oktober) in sogenannten Malaise-Fallen gefangen und ihre täglich anfallende, gesamte Biomasse an allen Standorten nach einem speziell entwickelten, standardisierten Verfahren bestimmt (Abbildung 2). Es wurde dabei untersucht, wie rasch der Rückgang der Insekten Biomasse erfolgte und welchen Einfluss darauf Faktoren wie

- Wetter,

- Habitate (Pflanzenzahl und Diversität; Stickstoff, pH, Feuchtigkeit, Licht) und

- Landnutzung (Wald, Ackerland, Grasfläche, Oberflächenwasser) hatten, die im Umkreis von 200 m um die Fallen herum durch Flugaufnahmen dokumentiert wurden.

Die resultierende komplexe Datensammlung wurde mittels solider statistischer Methoden analysiert und Modelle für den Zeitverlauf entwickelt, in welche die einzelnen Faktoren und auch Wechselwirkungen zwischen diesen miteinbezogen wurden.

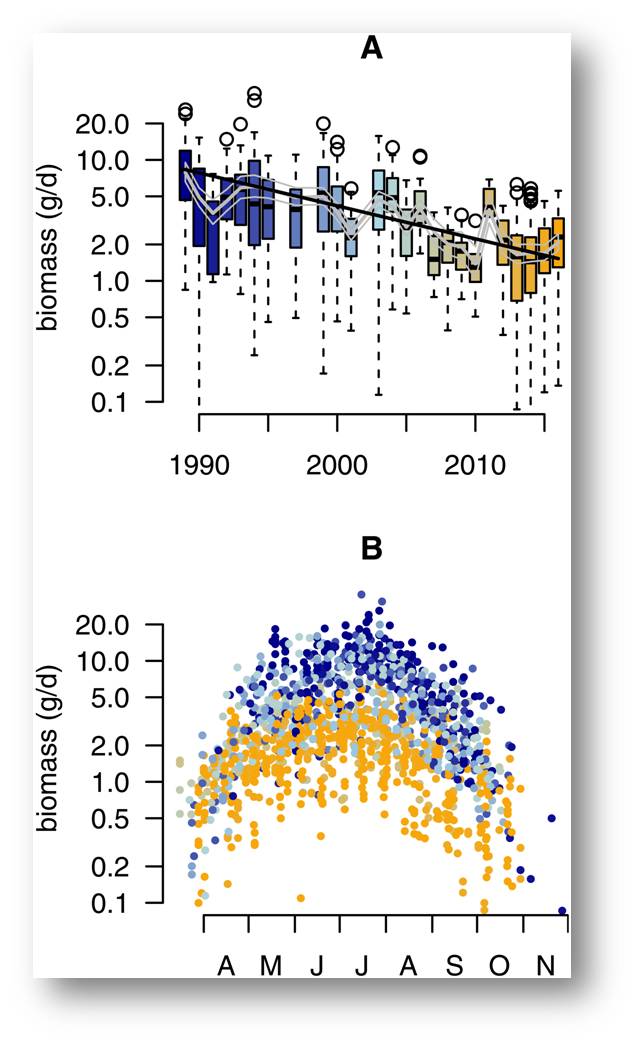

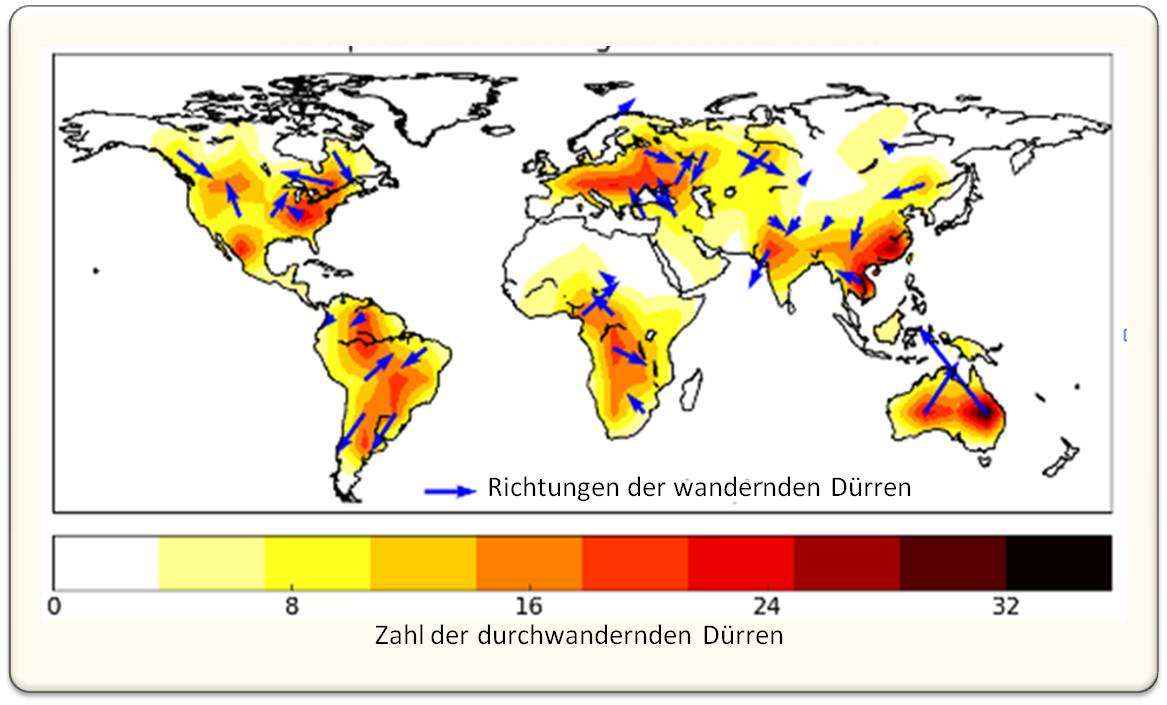

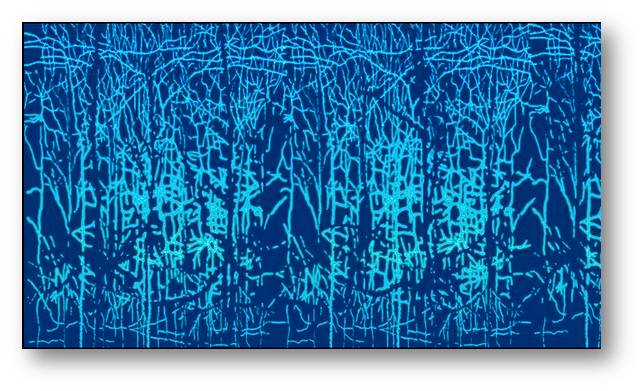

Das Ergebnis zeigte, dass in dem untersuchten Zeitraum von 27 Jahren die Menge an fliegenden Insekten über die gesamte Saison hin um rund 76 % zurückgegangen ist. Nur auf die Sommermonate bezogen, in denen jeweils das größte Insektenaufkommen verzeichnet wurde, fiel der Rückgang noch höher (82 %) aus. (Abbildung 3).

Unabhängig vom jeweiligen Habitat erfolgte der Rückgang an allen Standorten nach einem sehr ähnlichen Muster. Es kann also nicht von einem lokalen Phänomen gesprochen werden - wahrscheinlich dürfte ein vergleichbares Verschwinden von Insekten auch auf andere Gebiete in Europa zutreffen. Wenn es sich dabei um nicht-geschützte Flächen handelt, könnte es zu noch höheren Verlusten von Insekten kommen.

Abbildung 3. Rückgang der Biomasse fliegender Insekten von 1989 bis 2015 (A) und die Variation der Biomasse innerhalb der Saison von März bis Oktober (B). Die Boxen in A stellen die Biomassen der jährlich in allen Fallen, an allen Standorten (n = 1503) gefangenen Insekten (in g pro Tag) dar. Modelle, die den Verlauf des Rückgangs simulieren, sind als Linien eingezeichnet. In B ist ersichtlich, dass die höchste Menge im Sommer gefangen wurde und der Rückgang in dieser Jahreszeit besonders stark war. Die Farben verändern sich von blau (1989) nach gelb (2016).

Abbildung 3. Rückgang der Biomasse fliegender Insekten von 1989 bis 2015 (A) und die Variation der Biomasse innerhalb der Saison von März bis Oktober (B). Die Boxen in A stellen die Biomassen der jährlich in allen Fallen, an allen Standorten (n = 1503) gefangenen Insekten (in g pro Tag) dar. Modelle, die den Verlauf des Rückgangs simulieren, sind als Linien eingezeichnet. In B ist ersichtlich, dass die höchste Menge im Sommer gefangen wurde und der Rückgang in dieser Jahreszeit besonders stark war. Die Farben verändern sich von blau (1989) nach gelb (2016).

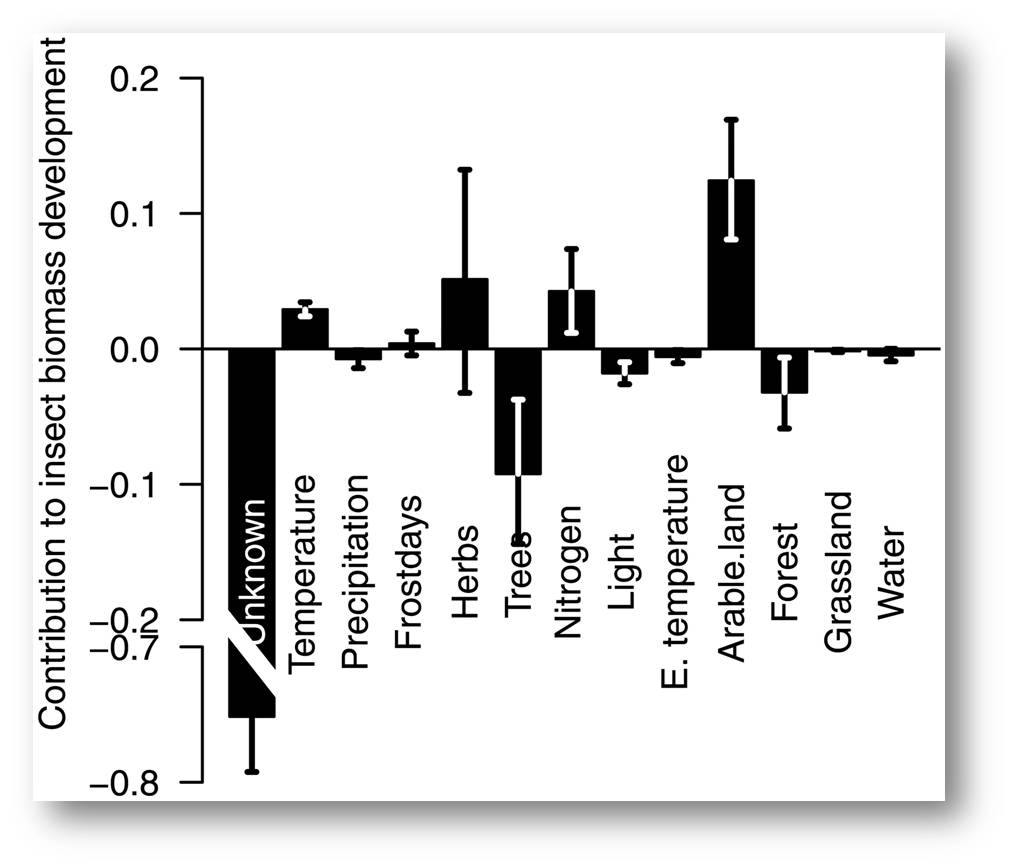

Wodurch der Rückgang begründet ist, konnte aus den Untersuchungen nicht geklärt werden. Ein Einbeziehen der Klimadaten - aus den über die 160 Wetterstationen aufgenommenen täglichen Daten - und auch der - aus den Luftbildern hervorgehenden - Landnutzung und Vegetation im Umfeld der Standorte zeigte jedenfalls, dass Änderungen dieser Parameter praktisch keinen Einfluss auf das Verschwinden der Insekten hatten. Abbildung 4.

Ob möglicherweise eine Nutzung von Pestiziden in den an die Naturschutzgebiete angrenzenden, landwirtschaftlich genutzten Flächen für den Rückgang verantwortlich sein könnte, wurde in dieser Studie nicht erfasst.

Abbildung 4. Die untersuchten Klimafaktoren (Temperatur, Niederschlag, Frost), Vegetationsfaktoren (Gräser, Bäume) und auch Feuchtigkeit, Licht und Stickstoff wirken sich nur geringfügig auf den Insektenrückgang aus. Die Ursache ist zum größten Teil noch nicht geklärt. (https://doi.org/10.1371/journal.pone.0185809.g005. (Lizenz: cc-by)

Abbildung 4. Die untersuchten Klimafaktoren (Temperatur, Niederschlag, Frost), Vegetationsfaktoren (Gräser, Bäume) und auch Feuchtigkeit, Licht und Stickstoff wirken sich nur geringfügig auf den Insektenrückgang aus. Die Ursache ist zum größten Teil noch nicht geklärt. (https://doi.org/10.1371/journal.pone.0185809.g005. (Lizenz: cc-by)

Fazit

Insekten spielen eine zentrale Rolle im Gleichgewicht der Natur; sie sind essentiell für die Bestäubung von Pflanzen, fressen Pflanzen und Abfall und dienen als Nahrung für Vögel, Amphibien und Säuger. Der "flächendeckende" starke Rückgang nicht nur einiger Spezies sondern der gesamten Biomasse lässt die Alarmglocken schrillen - insbesondere, da die Untersuchungen ja in Naturschutzgebieten erfolgten, wo man erwartete, dass man die Funktionen des Ökosystems und die Artenvielfalt erhalten könne. Es ist dringend notwendig die Ursachen des Rückgangs der Insekten herauszufinden, um diesen weiterhin ihre Funktion für den Erhalt der Ökosysteme zu sichern.

[1] https://www.altmetric.com/top100/2017/

[2] CA Hallmann et al., (2017) More than 75 percent decline over 27 years in total flying insect biomass in protected areas. http://journals.plos.org/plosone/article?id=10.1371/journal.pone.0185809 (Der Artikel ist unter cc-by lizensiert)

Weiterführende Links

Artikel zum Insektenrückgang

Der Standard: "Nach Kontroverse: Studie bestätigt dramatischen Insektenschwund"

SPIEGEL ONLINE, Hamburg, Germany: "Insektensterben: Zahl der Insekten in Deutschland sinkt deutlich"

Süddeutsche.de GmbH, Munich, Germany: "Insektensterben: Rückgang um 76 Prozent in Deutschland"

Spektrum der Wissenschaft: "Insektenzahl in Deutschland nimmt um 75 Prozent ab "

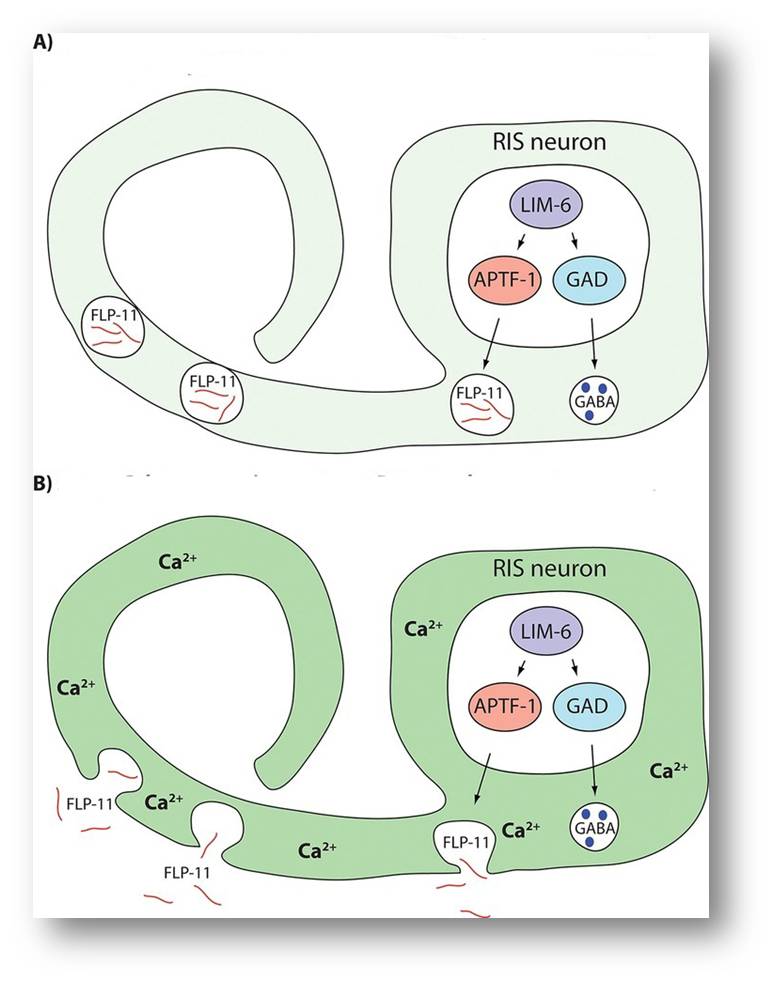

Personalisierte Medizin: Design klinischer Studien an Einzelpersonen (N=1 Studien)

Personalisierte Medizin: Design klinischer Studien an Einzelpersonen (N=1 Studien)Do, 21.12.2017 - 06:21 — Francis Collins

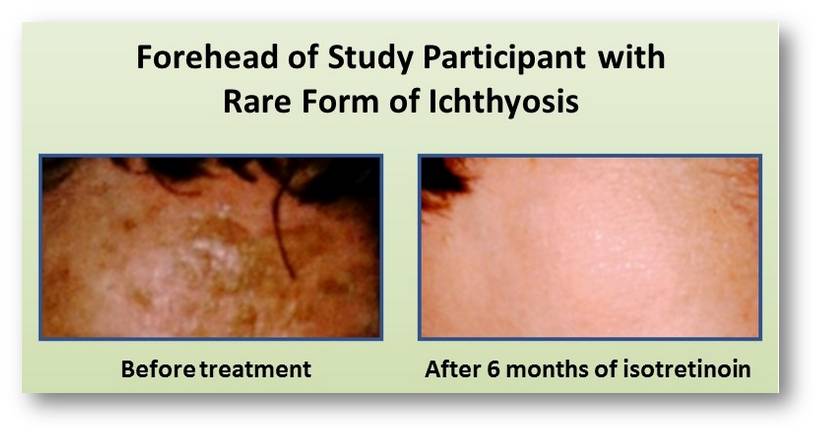

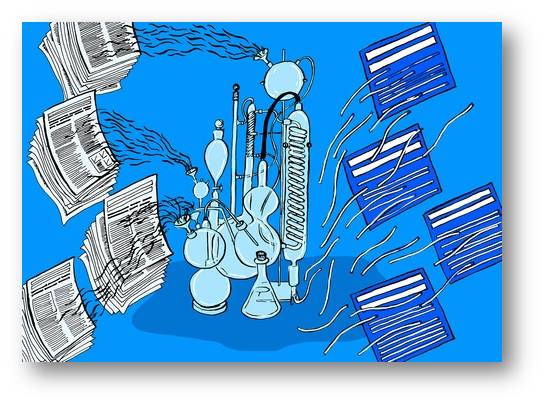

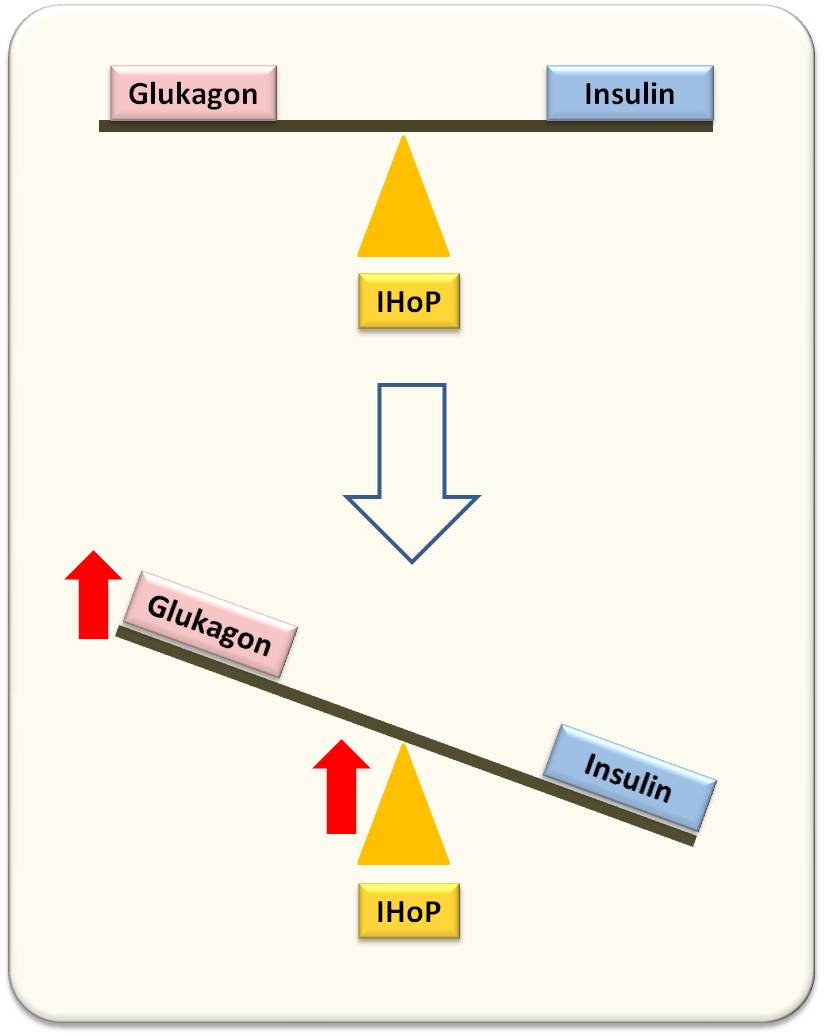

![]() Arzneimittel, deren Wirksamkeit in klassischen randomisierten Placebo-kontrollierten klinischen Studien festgestellt wird, funktionieren nicht bei allen Patienten . Auf Grund unterschiedlicher genetischer Makeups und versc hiedener Lebensumstände profitiert nur ein Teil der Kranken (Abbildung), zudem können Patienten infolge von Nebenwirkungen Schaden erleiden. Ein neues Konzept - die Personalisierte Medizin - strebt an "den richtigen Patienten mit der richtigen Medizin in der richtigen Dosis" zu behandeln. Technologische Fortschritte in der Generierung und Verwertung enorm großer Mengen an Patientendaten lassen personalisierte Studien an Einzelpersonen - sogenannte "N =1"-Studien möglich erscheinen. Francis Collins, NIH-Direktor und ehem. Leiter des "Human Genome Project", berichtet über die Entwicklung digitaler Plattformen, die es Ärzten ermöglichen sollen derartige Untersuchungen an Einzelpersonen in ihren Ordinationen durchzuführen.*

Arzneimittel, deren Wirksamkeit in klassischen randomisierten Placebo-kontrollierten klinischen Studien festgestellt wird, funktionieren nicht bei allen Patienten . Auf Grund unterschiedlicher genetischer Makeups und versc hiedener Lebensumstände profitiert nur ein Teil der Kranken (Abbildung), zudem können Patienten infolge von Nebenwirkungen Schaden erleiden. Ein neues Konzept - die Personalisierte Medizin - strebt an "den richtigen Patienten mit der richtigen Medizin in der richtigen Dosis" zu behandeln. Technologische Fortschritte in der Generierung und Verwertung enorm großer Mengen an Patientendaten lassen personalisierte Studien an Einzelpersonen - sogenannte "N =1"-Studien möglich erscheinen. Francis Collins, NIH-Direktor und ehem. Leiter des "Human Genome Project", berichtet über die Entwicklung digitaler Plattformen, die es Ärzten ermöglichen sollen derartige Untersuchungen an Einzelpersonen in ihren Ordinationen durchzuführen.*

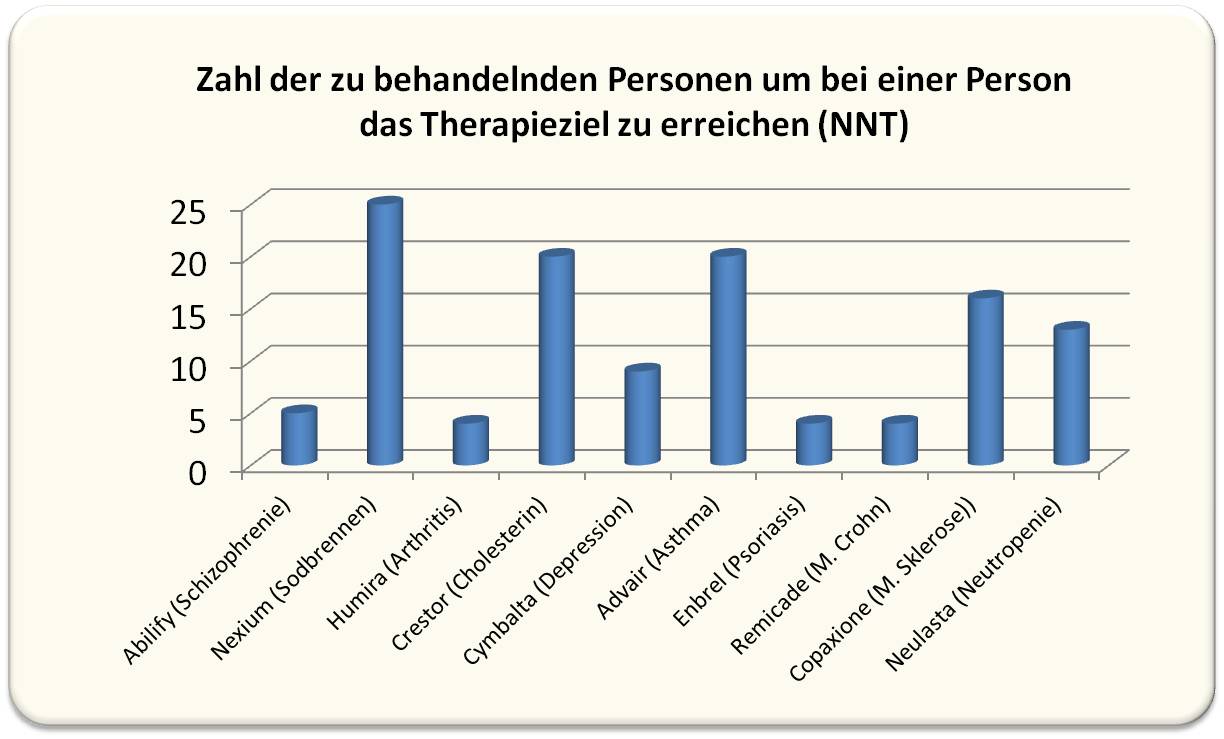

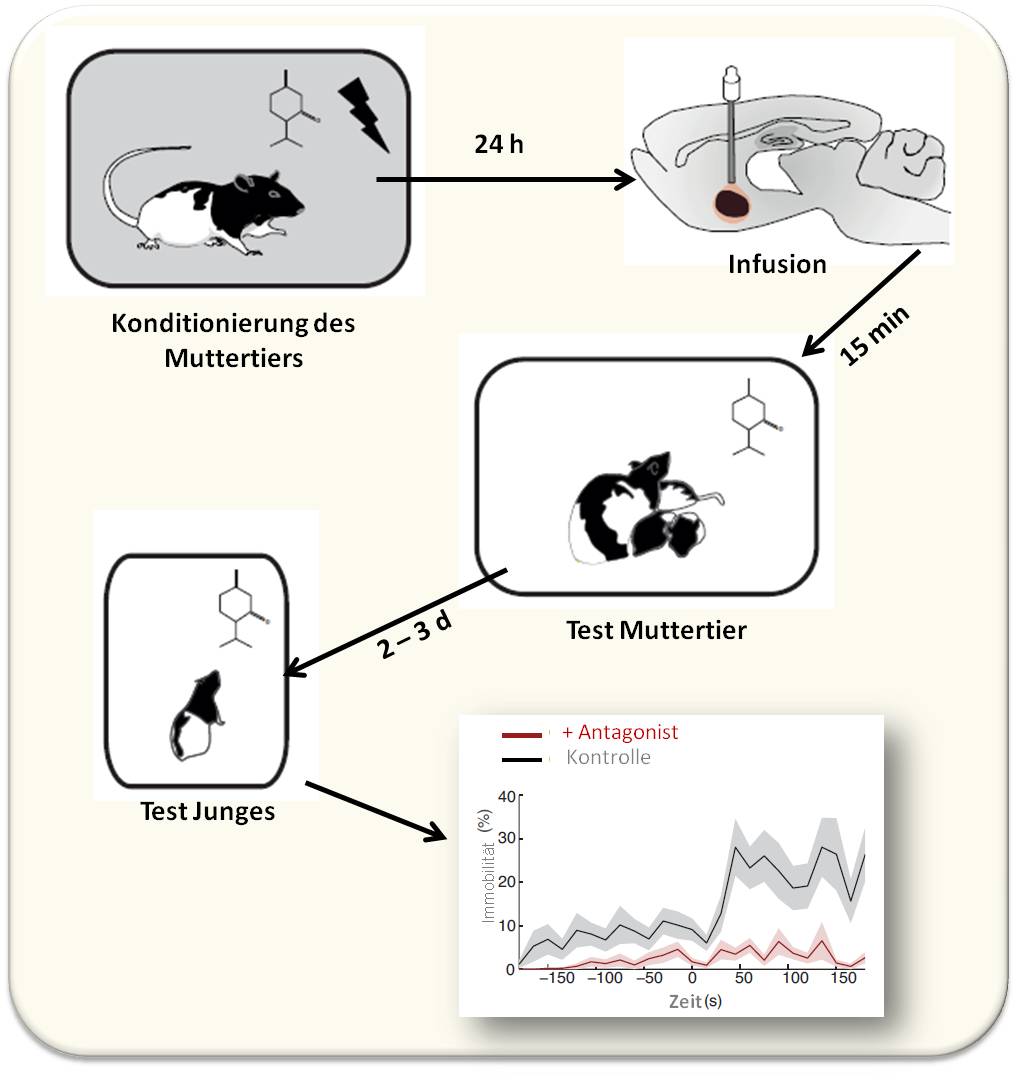

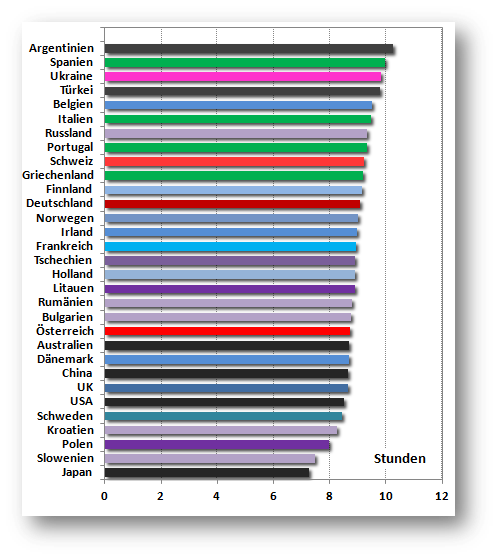

Abbildung 1. Zur Wirksamkeit der 10 im Jahr 2013 umsatzstärksten Arzneimittelin in den USA (Gesamtvolumen rund 50 Mrd $). Um einen gewünschten Therapieeffekt bei einem Patienten zu erzielen (NNT: numbers necessary to treat), müssen bis zu 25 Patienten (bei Nexium) behandelt werden. Im Fall des Cholesterinsynthesehemmers Crestor (5,2 Mrd Umsatz) sind es 20 Patienten. (Abb. von Redaktion eingefügt. Die Daten stammen aus: N.J.Schork: Time for one-person trials.Nature 520 (2015): 609-11 und aus https://www.drugs.com/stats/top100/2013/sales ).

Abbildung 1. Zur Wirksamkeit der 10 im Jahr 2013 umsatzstärksten Arzneimittelin in den USA (Gesamtvolumen rund 50 Mrd $). Um einen gewünschten Therapieeffekt bei einem Patienten zu erzielen (NNT: numbers necessary to treat), müssen bis zu 25 Patienten (bei Nexium) behandelt werden. Im Fall des Cholesterinsynthesehemmers Crestor (5,2 Mrd Umsatz) sind es 20 Patienten. (Abb. von Redaktion eingefügt. Die Daten stammen aus: N.J.Schork: Time for one-person trials.Nature 520 (2015): 609-11 und aus https://www.drugs.com/stats/top100/2013/sales ).

Es mögen bereits 25 Jahre her sein, doch Karina Davidson erinnert sich an den Tag, als ob es gestern gewesen wäre. Sie absolvierte damals das praktische Jahr in klinischer Psychologie, als ein besorgtes Elternpaar mit ihrem siebenjährigen Problemkind das Krankenhaus betrat. Der Bub war schwer untergewichtig - er wog nicht ganz 17 kg - und hatte aggressives Verhalten gegen sich selbst und andere an den Tag gelegt. Es schien möglich, dass Ritalin - ein üblicherweise gegen das Aufmerksamkeitsdefizit-Syndrom (ADHS) verschriebenes Arzneimittel, hier nützen könnte. Würde dies aber tatsächlich der Fall sein?

Design einer personalisierten Einzelperson-Studie

Um das herauszufinden, hat das Klinikerteam etwas völlig Unkonventionelles getan: sie haben eine klinische Prüfung für den Buben als Einzelperson entworfen, welche den Nutzen einer Behandlung mit Ritalin versus Placebo testen sollte . Nach dem Zufallsprinzip sollte der Bub so täglich vier Wochen lang mit dem Arzneimittel oder mit einem Placebo behandelt werden. Dem Charakter einer kontrollierten Doppelblindstudie entsprechend wussten weder das Team in der Klinik noch die Eltern zuhause, ob der Bub nun zu einer bestimmten Zeit Ritalin erhielt oder Placebo. In kurzer Zeit stand das Ergebnis fest: Ritalin führte nicht zum Erfolg. Dem Buben blieben so die Nebenwirkungen erspart, welche die Langzeitanwendung des für ihn wirkungslosen Medikaments mit sich gebracht hätten, und seine Ärzte konnten sich anderen, möglicherweise wirkungsvolleren Behandlungen zuwenden.

Das Projekt: Re-engineering Precision Therapeutics through N-of-1 Trials

Karina Davidson ist nun etablierte klinische Psychologin am Irving Medical Center der Columbia University; sie möchte die unkonventionelle, für den Buben damals hilfreiche Strategie aufgreifen und sie zu einer gebräuchlicheren Behandlungsform machen. Für ein Projekt, das sie zusammen mit Kollegen durchführen will, hat Davidson 2017 den NIH Director’s Transformative Research Award erhalten (es ist dies eine Unterstützung für ein außergewöhnlich innovatives, unkonventionelles Forschungsprojekt, das mit hohem Risiko behaftet ist und zu einem Paradigmenwechsel führen kann. Anm. Red.) Mit dieser Unterstützung will das Forscherteam drei digitale Plattformen entwickeln, die es Ärzten ermöglichen sollen in ihren Ordinationen Ein-Person Untersuchungen durchzuführen.

Große klinische Studien sind hervorragend geeignet, um herauszufinden, welche Behandlungen für den Durchschnittspatienten am besten wirken werden. Allerdings entsprechen nicht alle Patienten dem Durchschnitt. Das ist der Punkt, wo personalisierte Studien an Einzelpersonen - sogenannte "N = 1 (N-of-1)- Studien" - ins Spiel kommen können. Ärzte können sie anwenden, um zu vergleichen, wie ein Patient auf zwei oder auch mehrere Behandlungen anspricht, bevor sie die Entscheidung treffen, was sie verschreiben.

Derartige N=1 Untersuchungen sind derzeit zwar noch relativ ungebräuchlich, technologische Entwicklungen machen ihre Umsetzung aber zunehmend einfacher. Beispielsweise können tragbare "Gesundheits-Monitore" und Smartphones es erleichtern große Datenmengen einzelner Patienten zu digitalisieren und sammeln.

Test-Plattformen

Was gebraucht wird, ist eine richtige elektronische Plattform , die es Ärzten ermöglicht ihre N=1 Studien zusammen mit den einströmenden Daten zu gliedern und zu verwalten. Davidson und ihre Kollegen wollen ihre Plattformen einem Test unter realen Bedingungen unterziehen.

Dieser beginnt damit, dass 60 Patienten mit eben festgestelltem Bluthochdruck rekrutiert werden. die entweder einer N=1 Studie oder einer Standardtherapie zugeordnet werden. In der N=1-Gruppe wird jeder Teilnehmer zwei Wochen lang eine Primärtherapie mit einem Blutdruckmedikament erhalten, dann folgt ein anderes, über den gleichen Zeitraum verabreichtes Blutdruckmedikament. Die Daten zur Reaktion der Patienten auf die Medikamente wird Davidson mit ihrem Team sammeln. Dabei wird das Team versuchen die jeweils wirksamste Medikation mit den geringsten Nebenwirkungen festzustellen. Insbesondere möchte das Team herausfinden, ob Patienten in der N=1 Gruppe schlussendlich bessere Behandlungserfolge erzielen als solche unter dem randomisierten Standardverfahren.

Einen ähnlichen N=1 Studienplan wird das Team auch anwenden, um zu klären, welche an Depression leidenden Personen von einer Lichttherapie profitieren können - d.i. von einer Behandlung, die zur Stimmungsaufhellung natürliches Licht im Freien simuliert.

Eine weitere Studie soll prüfen, bei welchen an Schlaflosigkeit leidenden Patienten niedrigdosiertes natürliches Melatonin zu einer Besserung führt.

Zusätzlich werden Davidson und ihr Team untersuchen, wie gut Ärzte N=1 Studien in ihren regulären klinischen Arbeitsablauf einplanen können. Wenn sich herausstellt, dass die N=1 Strategie für Arzt und Patient von Nutzen ist, so wird man die Plattform künftig den Ärzten auch für eine Reihe anderer Indikationen anbieten können. Derartige Möglichkeiten würden u.a. in der Behandlung von Diabetes bestehen, in der Kontrolle von Schmerz , im Erstellen von Trainingsprogrammen und in der Entwicklung von personalisierten Strategien zum Gewichtsverlust.

Das Ziel

von Karina Davidson ist es schlussendlich, das Wesen der klinischen Konsultation zu ändern - es wird Wissenschaft herangezogen, um Entscheidungen zur Behandlung jeder einzelnen Person zu treffen. Da mit dem NIH-Forschungsprogramm All of Us nun mehr und mehr über individuelle Unterschiede in Gesundheitsrisiken und Ansprechen auf Behandlungen in Erfahrung gebracht wird, erscheint das Wachstumspotential einer N=1 Strategie in der Medizin zweifellos hoch. (Anm. Red.: Auf dem Weg zu einer personalisierten Medizin strebt das Programm All of Us an von 1 Million (oder mehr) US-Amerikanern Gesundheitsinformationen zu sammeln unter Berücksichtigung der individuellen genetischen/biologische n Gegebenheiten, des Lebensstils und der Umwelt einflüsse.)

* Dieser Artikel von NIH Director Francis Collins, M.D., Ph.D. erschien unter dem Titel:" Creative Minds: Designing Personalized Clinical Trials" zuerst (am 14. Dezember 2017) im NIH Director’s Blog: https://directorsblog.nih.gov/2017/12/14/creative-minds-designing-person... . Der Artikel wurde von der Redaktion aus dem Englischen übersetzt und geringfügig (mit Untertiteln und zwei Kommentaren) für den Blog adaptiert. Eien Abbildung wurde von der Redaktion eingefügt. Reprinted (and translated by ScienceBlog) with permission from the National Institutes of Health (NIH).

Weiterführende Links

Karina W. Davidson, homepage: http://www.columbiacardiology.org/profile/kwdavidson

Karina W. Davidson (2017), Project: RE-ENGINEERING PRECISION THERAPEUTICS THROUGH N-OF-1 TRIALS: https://projectreporter.nih.gov/project_info_description.cfm?icde=0&aid=...

All of Us (NIH). https://allofus.nih.gov/ The All of Us Research Program is a historic effort to gather data from one million or more people living in the United States to accelerate research and improve health. By taking into account individual differences in lifestyle, environment, and biology, researchers will uncover paths toward delivering precision medicine.

Why All of Us. Why Now. (6.6.2017) Francis Collins et al. Video (englisch) 1:53 min. "The time is ripe for medical breakthroughs and advancements in health research. See how the All of Us Research Program is leading the way towards better health care for all of us." Standard YouTube Lizenz. https://www.youtube.com/watch?time_continue=2&v=B7m5rNkDjHE

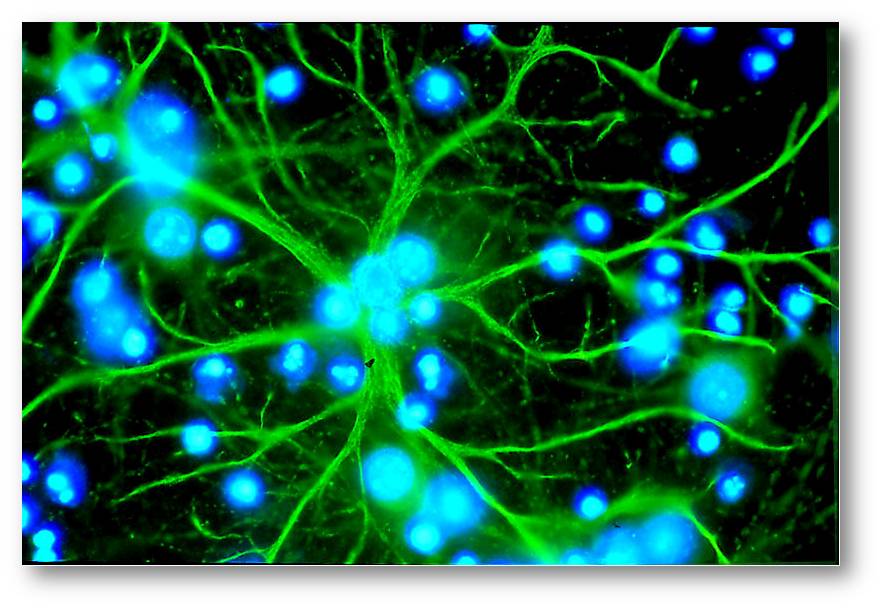

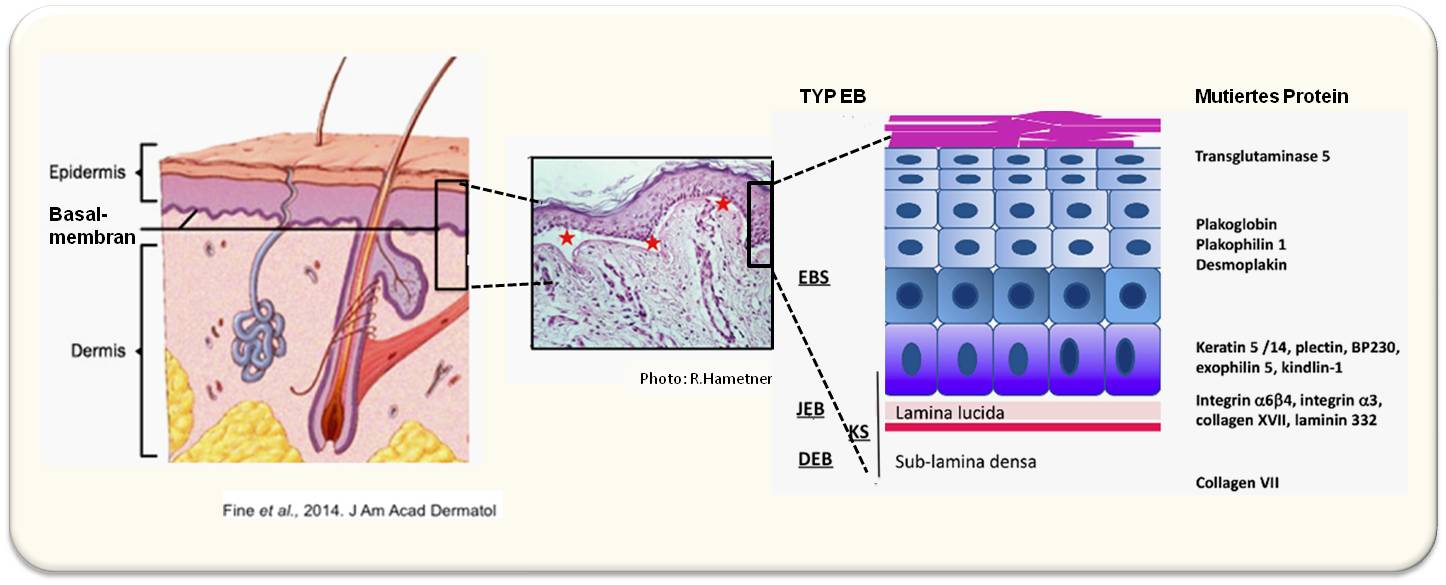

Multiple Sklerose - Krankheit der tausend Gesichter

Multiple Sklerose - Krankheit der tausend GesichterFr, 15.12.2017 - 07:43 — Nora Schultz

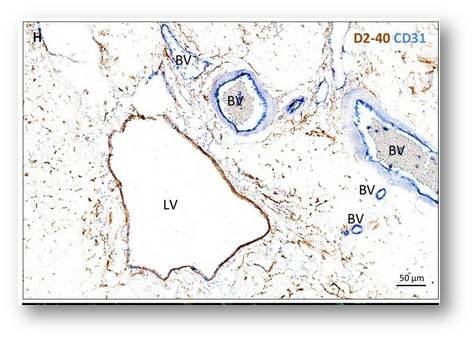

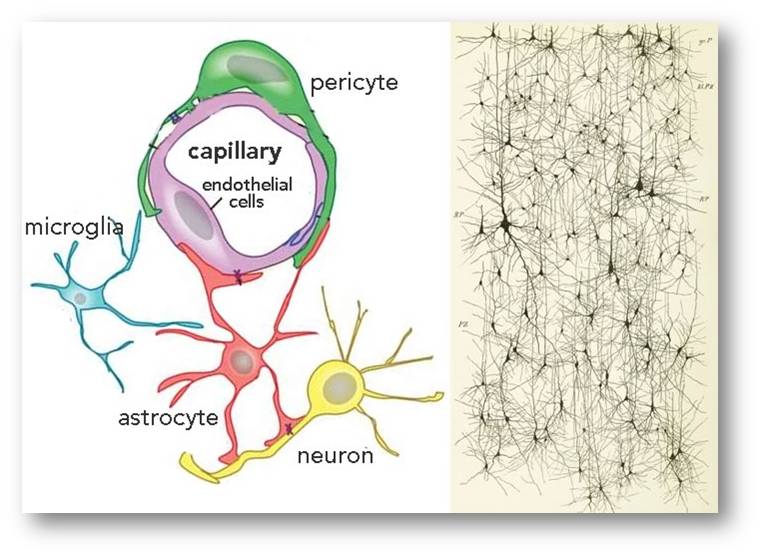

Multiple Sklerose (MS) ist eine entzündliche Erkrankung des zentralen Nervensystems. Aus bisher unbekannten Gründen greifen fehlprogrammierte Teile des Immunsystems Nervenzellen an. Es kommt es zu einem Verlust der schützenden Myelinschicht, die unsere Nervenfasern umgibt. Dadurch können Signale zwischen Nervenzellen nicht mehr korrekt weitergeleitet werden. Die Entwicklungsbiologin Nora Schultz gibt einen Überblick über Symptome, Krankheitsverlauf und Therapiemöglichkeiten .*

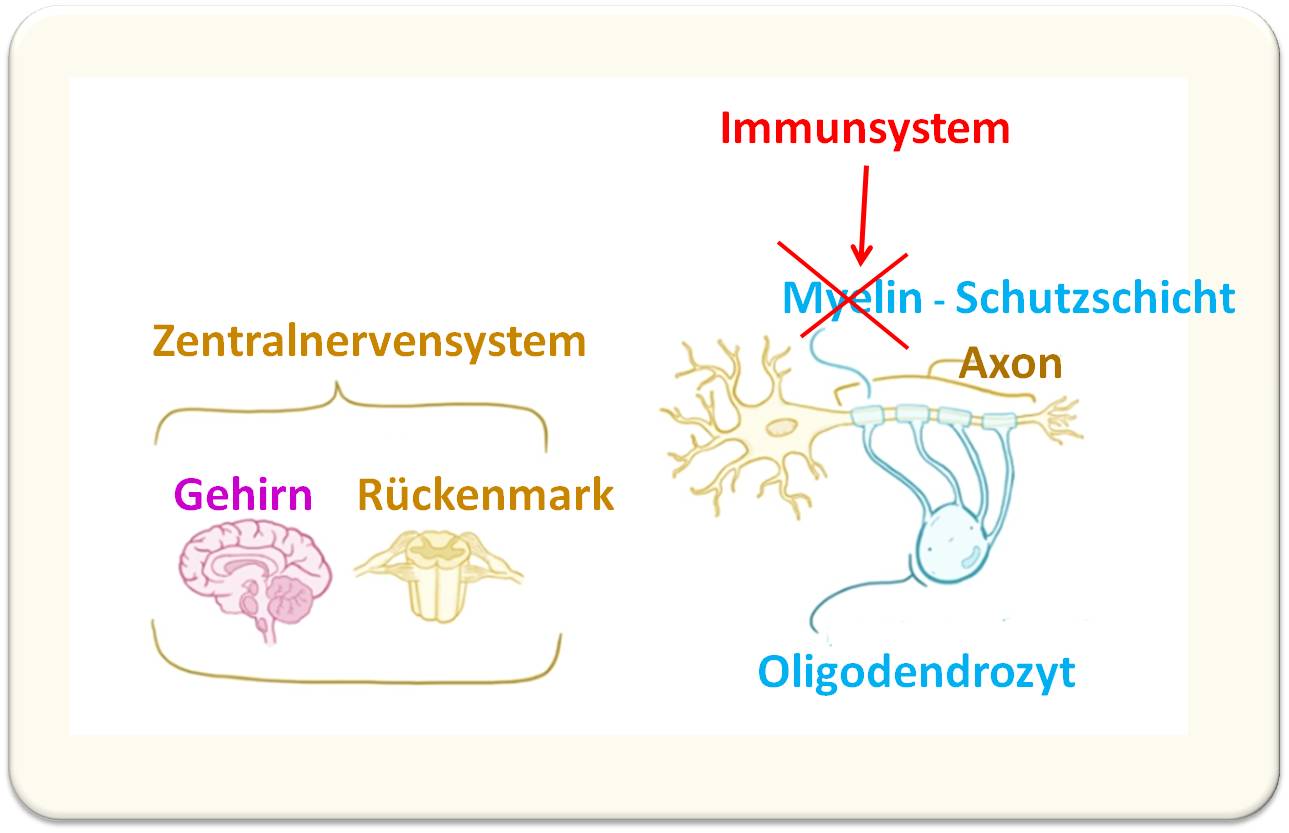

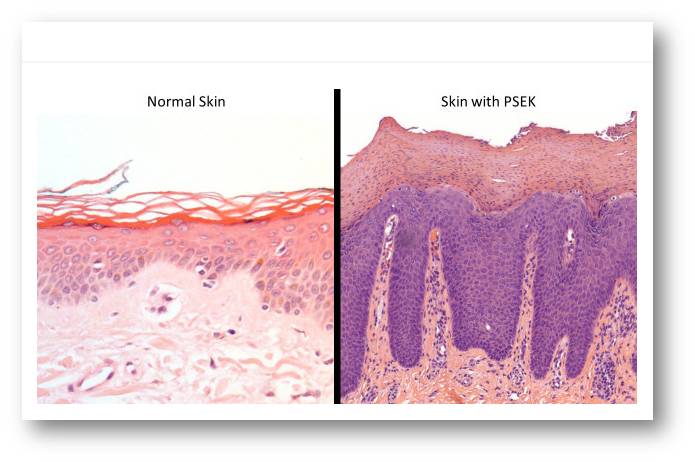

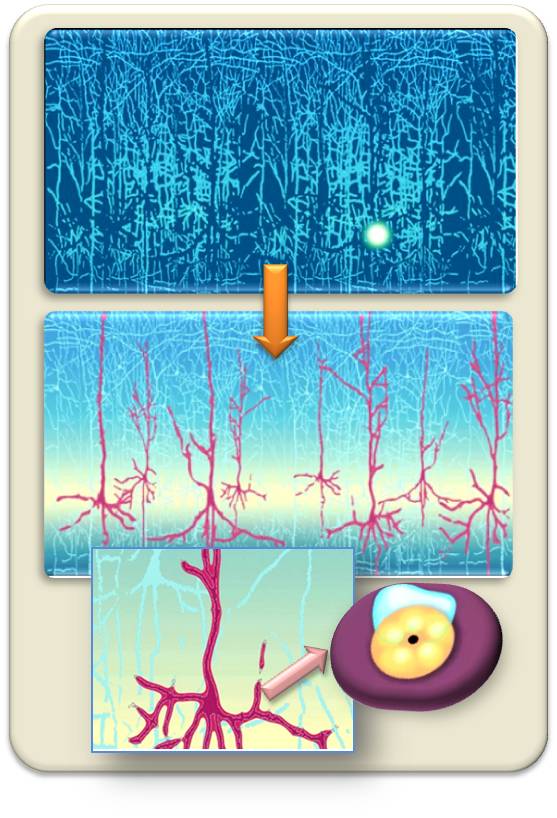

Über 200.000 Menschen leben in Deutschland mit der Nervenkrankheit Multiple Sklerose. (In Österreich sind es laut Österreichischer Multiple Sklerose Gesellschaft - ÖSMSG - rund 12 500 MS-Patienten; Anm. Red.) Fehlgeleitete Zellen des Immunsystems greifen das zentrale Nervensystem an und lösen so in Gehirn und Rückenmark Entzündungen aus, die zu einer Vielfalt von Symptomen und sehr unterschiedlichen Krankheitsverläufen führen können. Abbildung 1.Deshalb wird die Multiple Sklerose auch die “ Krankheit der 1000 Gesichter ” genannt.

Abbildung 1. Multiple Sklerose - eine entmyeliniserende Erkrankung. Zellen des Immunsystems greifet die Myelinscheiden an, welche- von Oligodendrozyten, gebildet - als Isolierschichte die Axone der Nervenzellen umgeben.(Bild von Red. eingefügt; adaptiert nach dem Video: osmosis.org 2017; CC-BY-SA 4.0; in Wikipedia)

Abbildung 1. Multiple Sklerose - eine entmyeliniserende Erkrankung. Zellen des Immunsystems greifet die Myelinscheiden an, welche- von Oligodendrozyten, gebildet - als Isolierschichte die Axone der Nervenzellen umgeben.(Bild von Red. eingefügt; adaptiert nach dem Video: osmosis.org 2017; CC-BY-SA 4.0; in Wikipedia)

Symptome

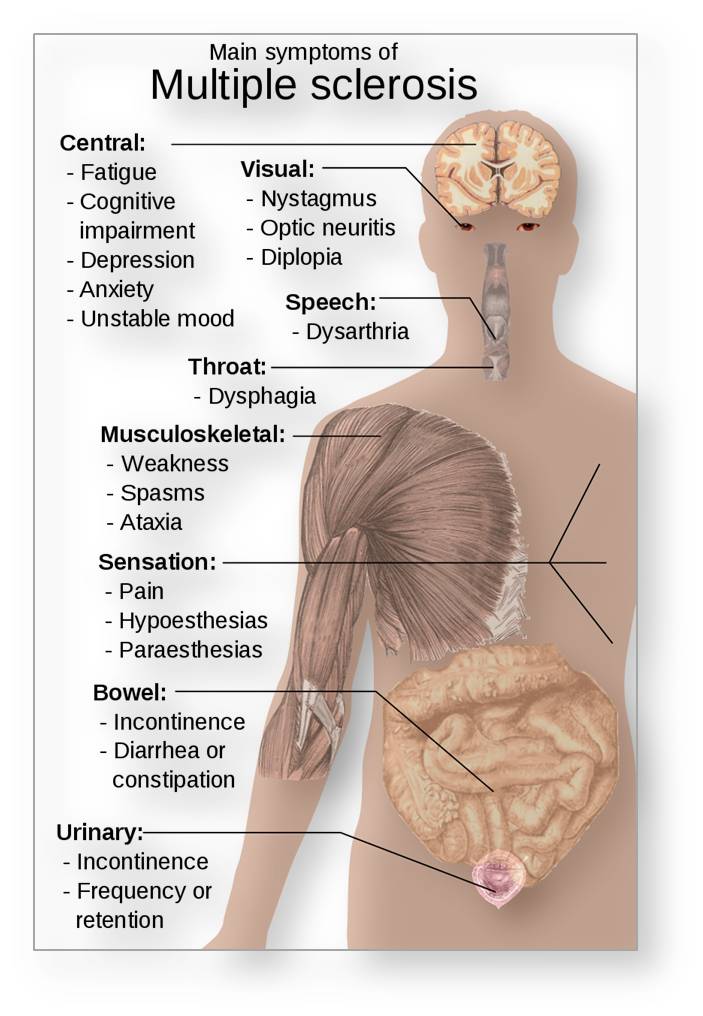

“Die typischen Erstsymptome sind Missempfindungen, Kribbeln und Taubheitsgefühle aber auch eine der Krankheit manchmal lange vorangehende Erschöpfbarkeit, die Betroffene sich nicht anders erklären können”, sagt Judith Haas, die Vorsitzende des Bundesverbandes der Deutschen Multiple Sklerose Gesellschaft (DMSG). Sehstörungen treten in 20 bis 30 Prozent der Fälle früh auf. Weitere schwerwiegendere Symptome, die im Zusammenhang mit einer Multiplen Sklerose auftreten können, sind Koordinationsprobleme und Lähmungen. Auch Blasen-, Potenz- und Konzentrationsstörungen können auftreten. Abbildung 2.

Abbildung 2. Hauptsächliche Symptome der Multiplen Sklerose, der - “ Krankheit der 1000 Gesichter ”. (Gemeinfreies Bild aus Wikipedia, von Red. eingefügt)

Abbildung 2. Hauptsächliche Symptome der Multiplen Sklerose, der - “ Krankheit der 1000 Gesichter ”. (Gemeinfreies Bild aus Wikipedia, von Red. eingefügt)

Die Symptome haben eine gemeinsame Ursache. Entzündungen im zentralen Nervensystem schädigen die Nervenzellen und die sie umgebende schützende Myelinschicht . Sie wird von den Fortsätzen anderer Zellen, den Oligodendrozyten, gebildet und sorgt dafür, dass elektrische Signale effizient übertragen werden. Je größer die Schäden sind, desto stärker wird die Weiterleitung von Signalen entlang von Nervenfasern beeinträchtigt.

Welche Störungen auftreten, hängt vom Ort der Entzündungsherde im Nervensystem ab

Längst nicht jeder Patient hat im Verlauf der Erkrankung mit allen Symptomen zu kämpfen. Viele Beschwerden treten zudem gerade anfangs nur vorübergehend oder unter körperlicher Belastung auf, und häufig erstmals im Alter zwischen 20 und 40 Jahren, wenn die meisten Patienten ansonsten noch körperlich fit sind. Bis zur Diagnose verstreichen daher im Schnitt derzeit drei Jahre, weil Ärzte und Patienten gerade bei wenig eindeutigen Frühsymptomen oft nicht an Multiple Sklerose denken.

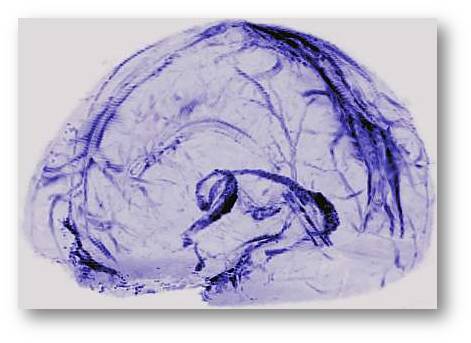

Erhärtet sich der Verdacht dann doch, kann eine Kombination aus Untersuchungsverfahren gemeinsam mit der ausführlichen Erfassung der bisherigen Krankheitsgeschichte schnell Klarheit bringen. Dazu gehören neben neurologischen Tests unter anderem von Augen, Reflexen und Koordination sowie einer elektrophysiologischen Untersuchung der Leitfähigkeit von Nervenfasern vor allem eine Magnetresonanztomografie (MRT) des Gehirns und des Rückenmarks sowie die Entnahme von Nervenwasser (Lumbalpunktion). Das MRT macht die für eine Multiple Sklerose typischen Entzündungsherde und vernarbten Gewebebereiche sichtbar. In der bei der Lumbalpunktion entnommenen Gehirn-Rückenmarks-Flüssigkeit (Liquor) finden sich bei fast allen Betroffenen bestimmte Entzündungsmarker.

Drei Jahre bis zur Gewissheit sind eindeutig zu lang. Viele Patienten schöpfen nach Internetrecherchen selbst Verdacht und drängen auf eine frühe Diagnostik: “Es ist ganz wichtig, unmittelbar nach dem ersten Schub eine Therapie zu beginnen. Alle Studien zeigen, dass man einen verpassten frühen Therapiestart später nicht mehr einholt.” Multiple Sklerose gilt zwar bislang als nicht heilbar, doch mit der richtigen Therapiekombination lassen sich Krankheitsverlauf und Lebensqualität entscheidend beeinflussen.

Die Therapie

umfasst drei Säulen:

- die Milderung akuter Entzündungsschübe (Schubtherapie),

- Eingriffe in das Immunsystem um neuen Schüben vorzubeugen (verlaufsmodifizierende Therapie)

- und die direkte Behandlung der jeweiligen Symptome (symptomatische Therapie).

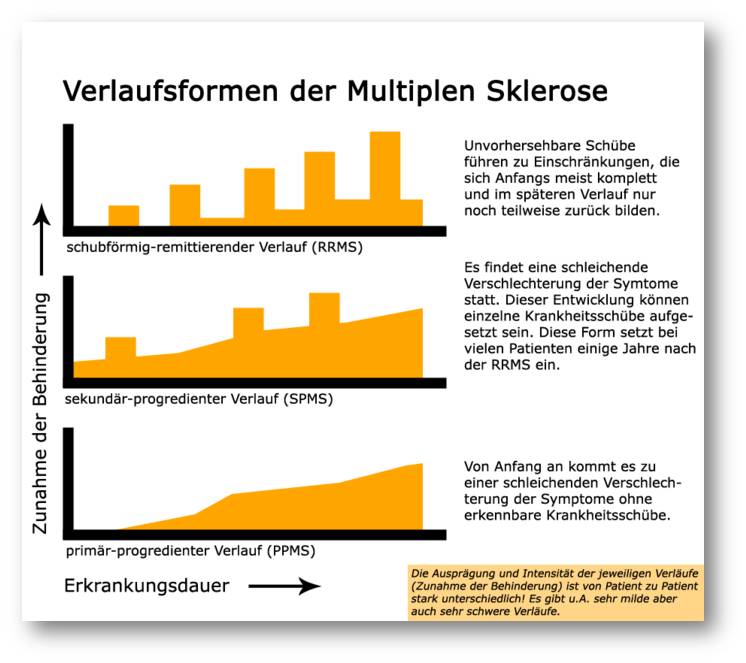

Gerade in den ersten Jahren verläuft die Erkrankung bei den meisten Patienten schubförmig, bevor sie später in eine stetig fortschreitende Form übergeht. In einigen Fällen (10 bis 15 Prozent) verläuft die Erkrankung ohne Schübe chronisch fortschreitend. Abbildung 3.

Abbildung 3. Verschiedene Verlaufsformen der multiplen Sklerose (Gemeinfreies Bild aus Wikipedia, von Red. eingefügt.)

Abbildung 3. Verschiedene Verlaufsformen der multiplen Sklerose (Gemeinfreies Bild aus Wikipedia, von Red. eingefügt.)

Bei einem Schub treten Symptome über wenige Tage oder Wochen hinweg auf und bilden sich dann für längere Zeit wieder ganz oder teilweise zurück. In so einer akuten Phase können entzündungshemmende Medikamente wie Kortikoide oder in schweren Fällen auch eine Plasmapherese, eine Art der „Blutwäsche“ , den Angriff der eigenen Immunzellen auf das Nervensystem bremsen.

Die langfristige Behandlung mit verlaufsmodifizierenden Wirkstoffen zielt hingegen darauf ab, die Häufigkeit und Schwere künftiger Schübe zu mindern oder bei der stetig fortschreitenden Krankheitsform die Verschlimmerung zu verlangsamen. Dazu wird die aus dem Gleichgewicht geratene Immunantwort der Patienten je nach Krankheitsbild und Medikament entweder umprogrammiert (Immunmodulation) oder unterdrückt (Immunsuppression).

Beeinflussung durch den Lebensstil

Auch der Lebensstil kann vermutlich den Krankheitsverlauf beeinflussen – und womöglich auch, ob die Krankheit überhaupt ausbricht.

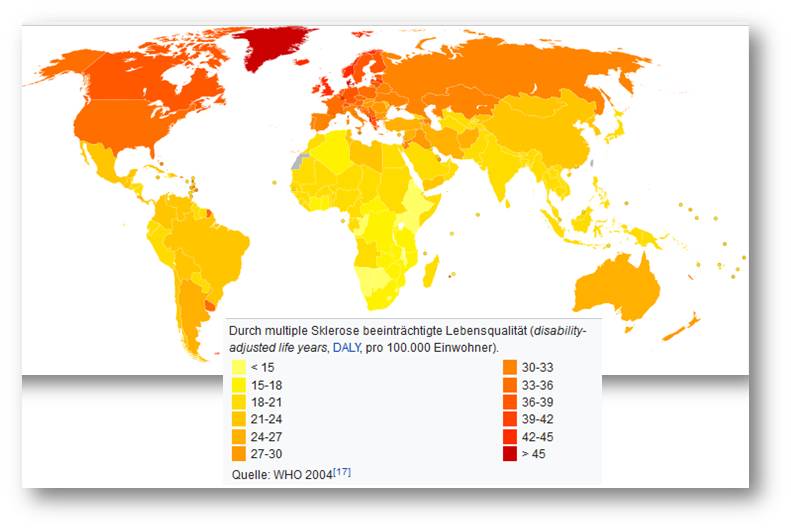

Rauchen, Alkoholkonsum, viel Kochsalz in der Nahrung, übertriebene Keimfreiheit in der Kindheit und Vitamin-D-Mangel beispielsweise erhöhen manchen Studien zufolge das Erkrankungsrisiko. Letzteres könnte auch erklär en , warum Multiple Sklerose in Äquatornähe seltener auftritt . Abbildung 4.

Abbildung 4. Erhöht Vitamin D-Mangel in nördlicheren Breiten das Risiko an MS zu erkranken? (Bild aus Wikipedia,cc-by-sa; von Red. eingefügt)

Abbildung 4. Erhöht Vitamin D-Mangel in nördlicheren Breiten das Risiko an MS zu erkranken? (Bild aus Wikipedia,cc-by-sa; von Red. eingefügt)

Dort wird nämlich die körpereigene Vitamin-D-Produktion dank reichlich Sonnenschein erhöht . „Da das Erkrankungsrisiko außerdem genetisch beeinflusst wird, empfehlen wir den Kindern von Multiple-Sklerose-Patienten unbedingt eine Nahrungsergänzung mit Vitamin D“, sagt Haas. Wer bereits erkrankt ist, kann mit gesunder Ernährung, geeigneten Sport- und Rehamaßnahmen sowie Entspannungstechniken zumindest bestimmte Symptome lindern und die Lebensqualität verbessern.

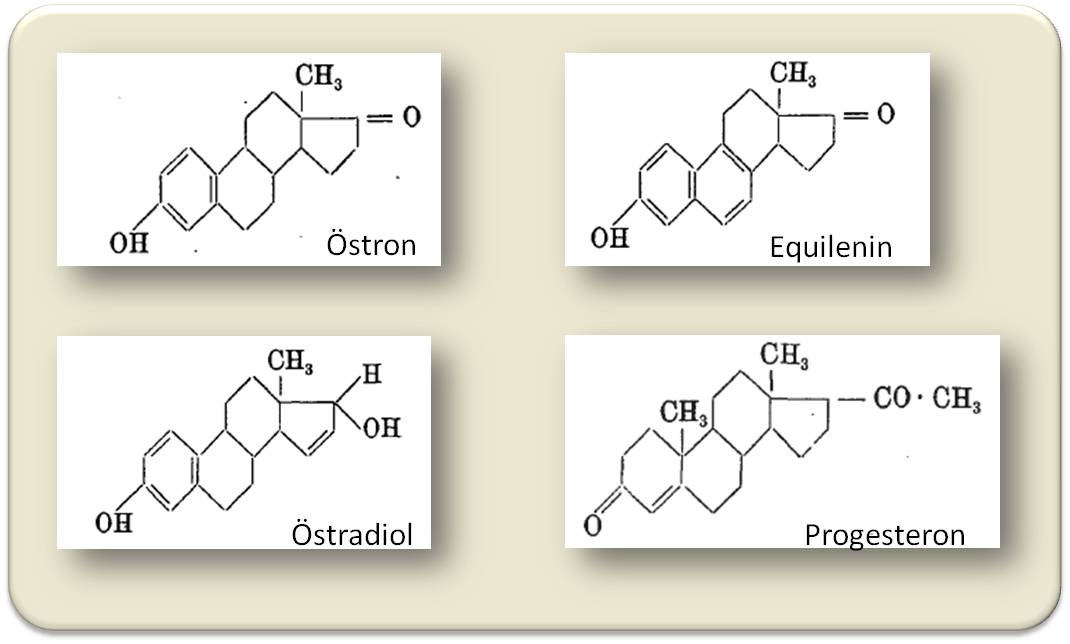

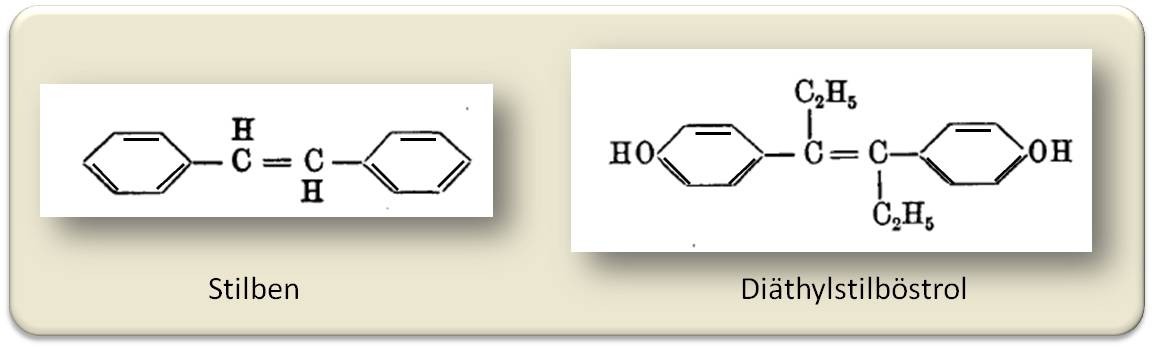

Hormonelle Einflüsse

Hormone spielen ebenfalls eine wichtige Rolle. Weibliche Geschlechtshormone, insbesondere Östrogen, stärken das Immunsystem und erhöhen so einerseits das Risiko, eine Autoimmunerkrankung überhaupt zu entwickeln. Sie sorgen jedoch andererseits auch für bessere Reparaturprozesse im Körper. Das erklärt einerseits, warum etwa doppelt so viele Frauen wie Männer an Multipler Sklerose erkranken, andererseits aber auch, warum sie sich in der Regel auch besser von Schüben erholen. Dies gilt zumindest bis zur Menopause, wenn die Hormonproduktion abnimmt. In dieser Lebensphase geht die Krankheit daher auch häufig in eine stetig fortschreitende Form über.

Jungen Patientinnen empfiehlt Haas, die Pille zu nehmen, da diese für einen stabilen Östrogenspiegel sorgt – oder sich gleich einen eventuell vorhandenen Kinderwunsch zu erfüllen: „Schwangerschaft ist einer der besten Therapien gegen Multiple Sklerose überhaupt. Gerade im letzten Schwangerschaftsdrittel bleiben Schübe meist völlig aus.“, sagt sie. Allerdings muss in den ersten drei Monaten nach der Geburt wieder mit einem deutlichen Anstieg der Schubrate gerechnet werden.

Der Einfluss von Hormonen auf die Entstehung und den Verlauf von Multipler Sklerose ist auch ein aktueller Forschungsschwerpunkt, mit dem Ziel, begleitende Hormontherapien zu entwickeln. Andere Fragen, mit denen Wissenschaftler sich derzeit befassen, drehen sich um ein besseres Verständnis der Immunmechanismen und Entzündungsprozesse. Untersucht wird beispielsweise die Rolle der Darmflora oder wie aggressive Immunzellen sich im zentralen Nervensystem „verstecken“ können. Langfristig versprechen Wissenschaftler sich auch von Stammzelltherapieansätzen weitere Fortschritte – bis hin zu einer möglichen Heilung.

Bei aller Hoffnung auf künftige Durchbrüche gilt es zunächst , das aktuelle Therapiearsenal besser zu nutzen, findet Haas. „Wir haben in Deutschland das Problem, dass hochwirksame Therapien nicht in dem Maß eingesetzt werden, wie wir es aus anderen Ländern kennen.“ Verbesserungen erhofft sie sich von der jüngsten Änderung des Paragraphen 116b des Sozialgesetzbuches . Dies würde es ermöglichen, die in Kliniken verfügbare hochspezialisierte Versorgung , den Patienten auch außerhalb von Krankenhäusern zukommen zu lassen.

Mit dem Zugang zu einer Reihe verschiedener Therapieansätze haben Patienten heute zahlreiche Möglichkeiten, den vielfältigen Gesichtern ihrer Erkrankung zu begegnen und trotz Einschränkungen ein ausgefülltes Leben zu führen. Viele sind in ihrer Freiheit kaum eingeschränkt, die Krankheitsaktivität oft nicht messbar. Das betonte auch Ministerpräsidentin Malu Dreyer kürzlich in einem Interview mit der Rhein-Zeitung: „Ich habe gedacht, dass das Leben, das ich bis dahin geführt hatte, zu Ende geht. Doch irgendwann habe ich es geschafft, den Schalter umzulegen: Ich habe beschlossen, mich nicht durch die Krankheit behindern zu lassen, sondern meine Träume und Pläne beizubehalten.“

*Der Artikel erschien am 10.5.2017 unter dem Titel "Krankheit der tausend Gesichter" auf der Website von www.dasgehirn.info und steht unter einer cc-by-nc Lizenz.: https://www.dasgehirn.info/krankheiten/multiple-sklerose/krankheit-der-t...

www.dasGehirn.info ist ein Projekt der Gemeinnützigen Hertie-Stiftung und der Neurowissenschaftlichen Gesellschaft e.V. in Zusammenarbeit mit dem ZKM | Zentrum für Kunst und Medientechnologie Karlsruhe Der Artikel wurde von der Redaktion geringfügig für den Blog adaptiert (Überschriften und Absätze eingefügt) und es wurden einige Abbildungen eingefügt.

Weiterführende Links

Internetpräsenz der Deutschen Multiple Sklerose Gesellschaft DMSG: https://www.dmsg.de/ [Stand 20.02.2017]

Weißbuch Multiple Sklerose. Versorgungssituation in Deutschland, hg . von Miriam Kip , Tonio Schönfelder und Hans-Holger Bleß . Springer Verlag. Zum Buch (open access)

Artikelserie (12 Artikel) in https://www.dasgehirn.info/krankheiten/multiple-sklerose :

- SusanneDonner (28.4.2017): Viele Ursachen der multiplen Sklerose. https://www.dasgehirn.info/krankheiten/multiple-sklerose/viele-ursachen-der-multiplen-sklerose

- Andrea Wille (30.5.2017): Multiple Sklerose - eine medizinische Herausforderung. https://www.dasgehirn.info/krankheiten/multiple-sklerose/multiple-sklerose-eine-medizinische-herausforderung

- Ute Eppinger (1.12.2017) : MS unter der Lupe. https://www.dasgehirn.info/krankheiten/multiple-sklerose/ms-unter-der-lupe

- Nicole Paschek (13.6.2017): Leben mit MS. https://www.dasgehirn.info/krankheiten/multiple-sklerose/leben-mit-ms

Videos

Wolfgang Brück: Inflammatorische Prozesse im Gehirn: Multiple Sklerose Video 7,2 min. https://www.dasgehirn.info/krankheiten/multiple-sklerose/neuroinflammati... (cc-by-nc)

Bernhard Hemmer: Multiple Sklerose Video 7,27 min. https://www.dasgehirn.info/krankheiten/multiple-sklerose/video-multiple-... (cc-by-nc)

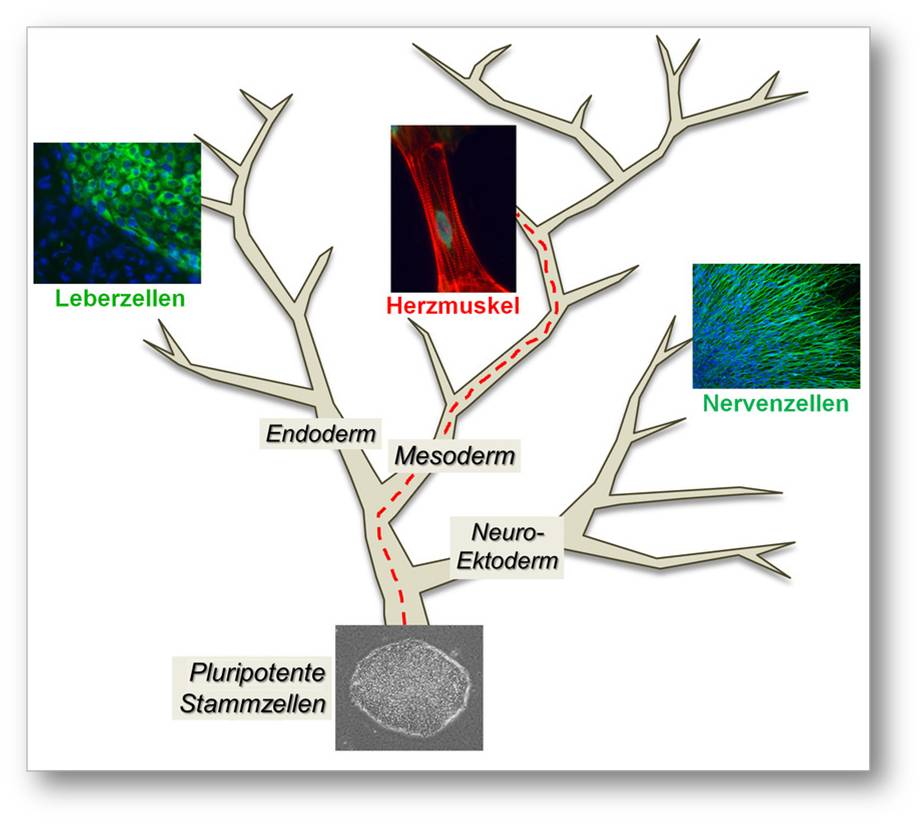

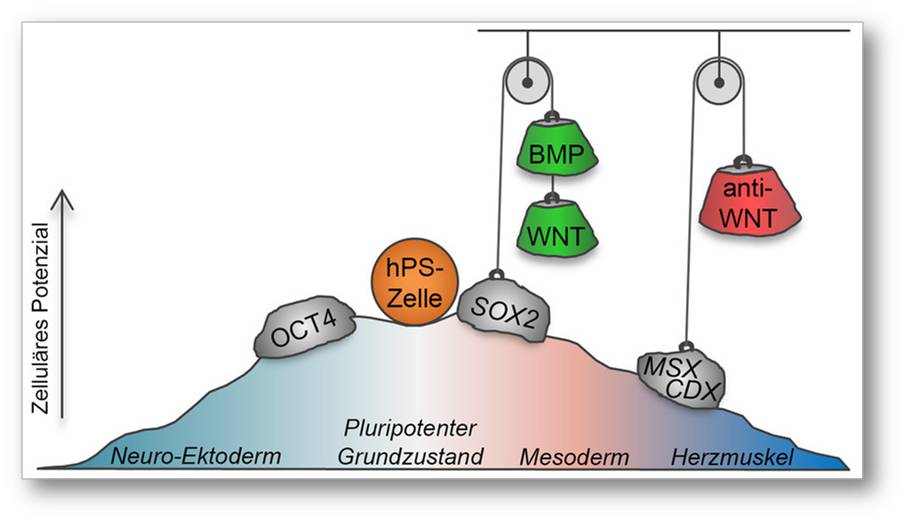

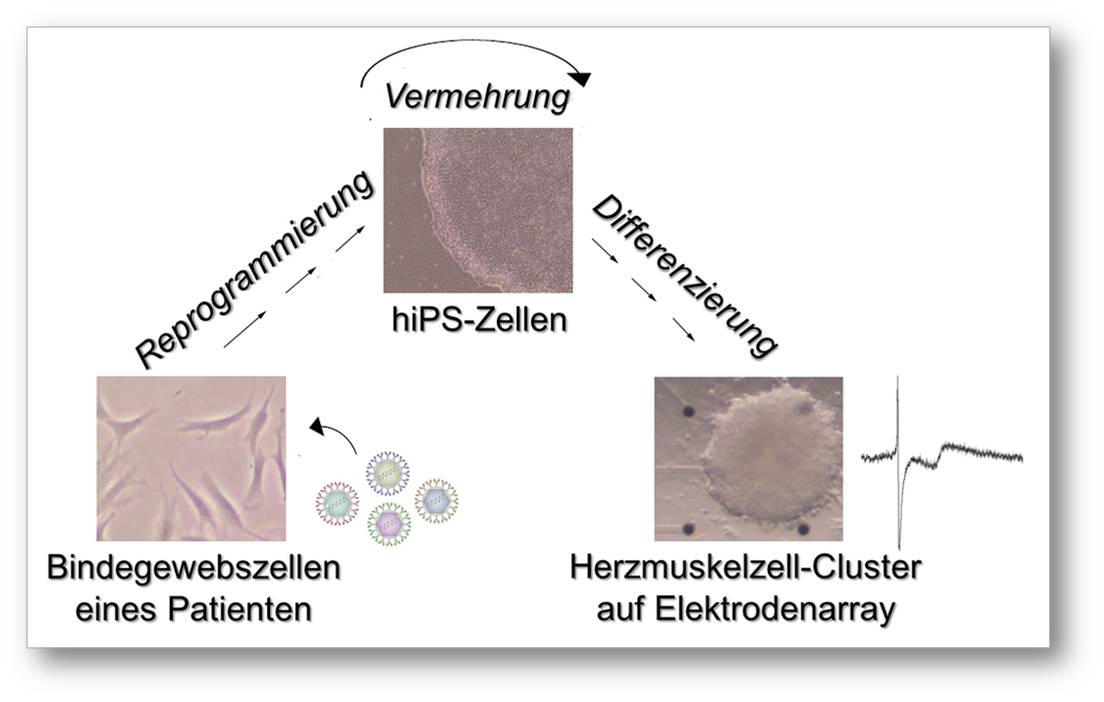

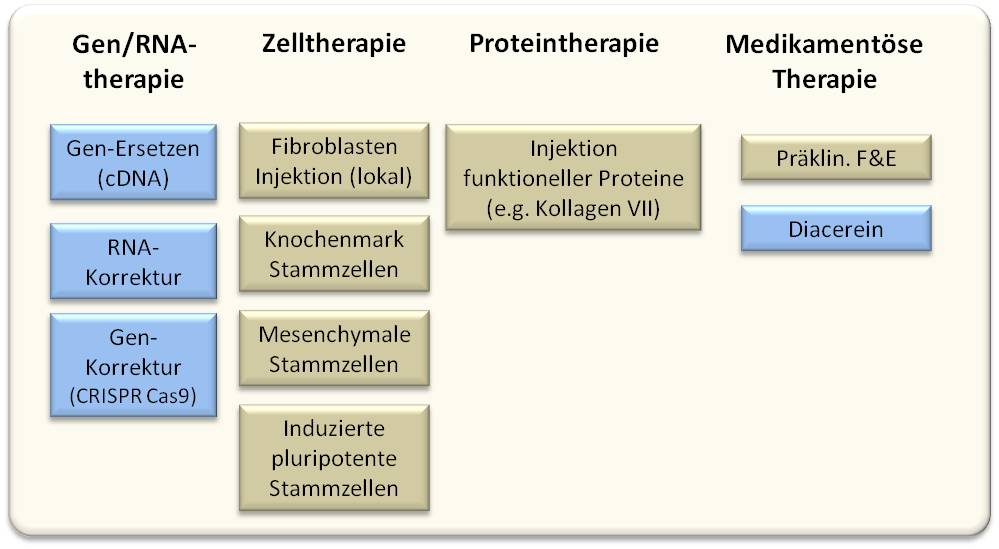

Bioengineering – zukünftige Trends aus der Sicht eines transatlantischen Expertenteams

Bioengineering – zukünftige Trends aus der Sicht eines transatlantischen ExpertenteamsDo, 07.12.2017 - 14:53 — Redaktion

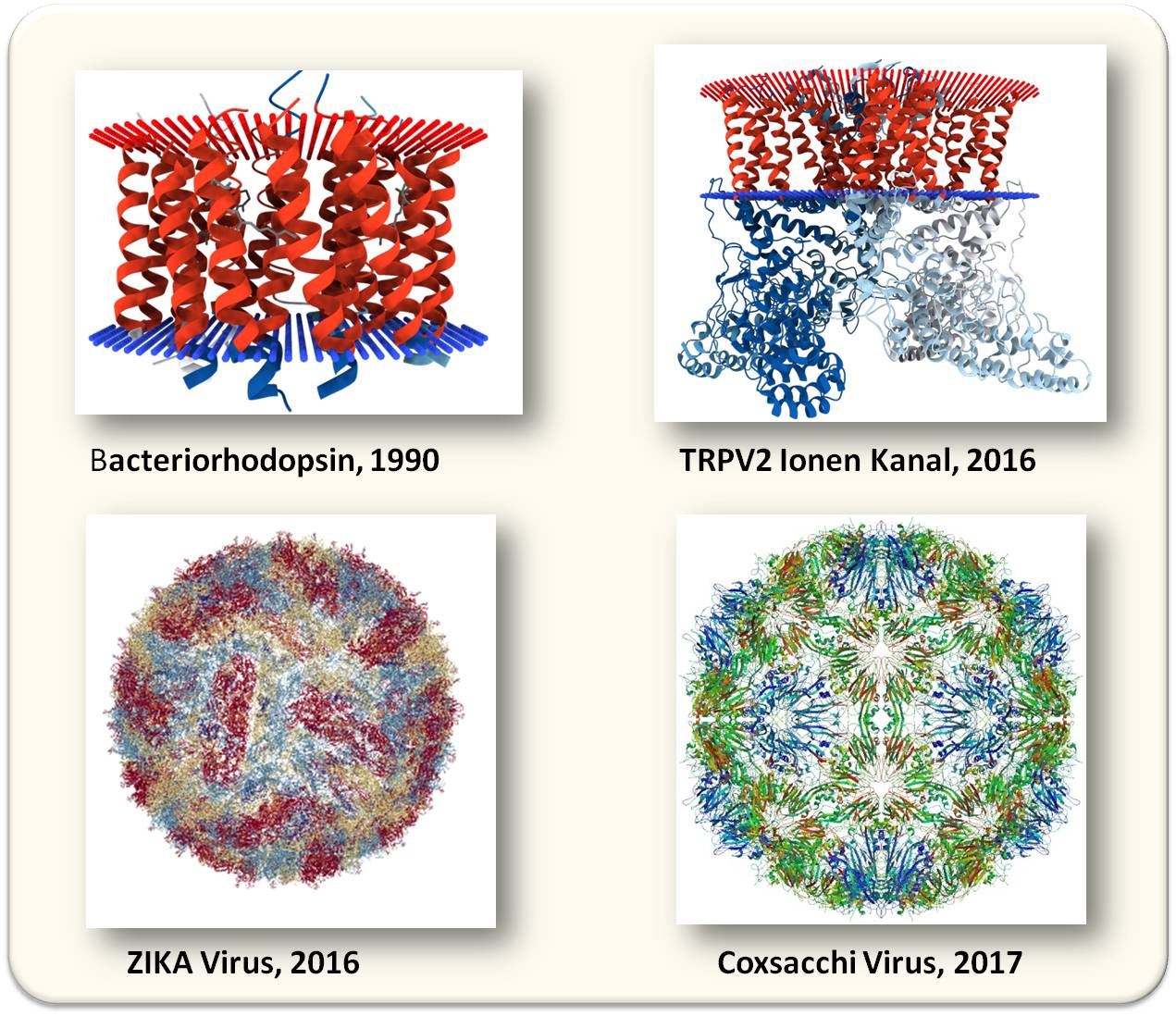

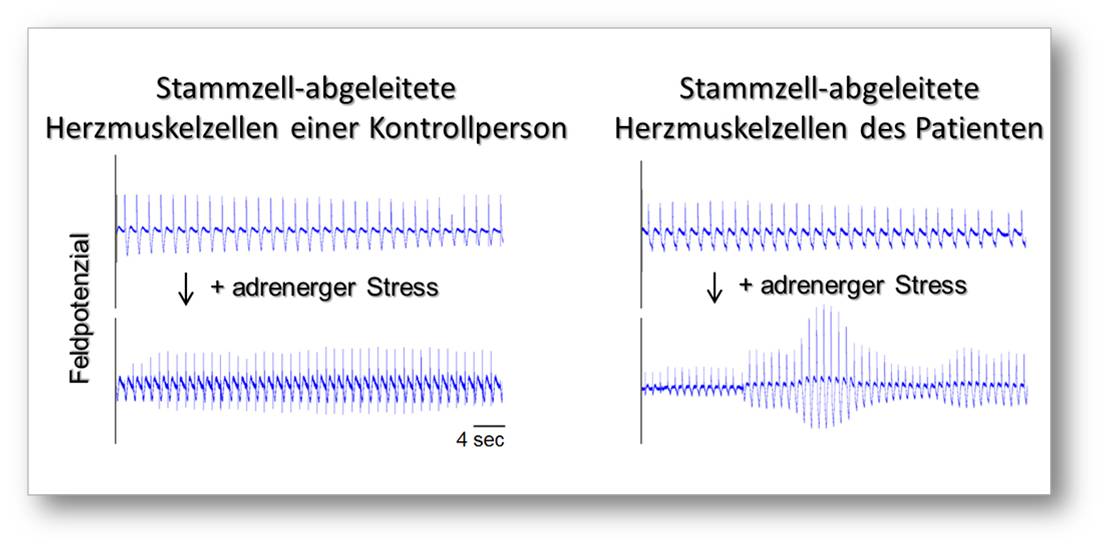

![]() Bioengineering bietet vielversprechende Ansätze, um die großen Herausforderungen in Angriff zu nehmen, denen unsere Gesellschaften ausgesetzt sind. Welche Entwicklungen hier kurzfristig und auch längerfristig besonders wichtig werden und welche Möglichkeiten und Risiken damit verbunden sind, hat ein internationales Team aus vorwiegend englischen und amerikanischen Experten aus ihrer Sicht als Wissenschafter, Innovatoren, Industrieangehörige und Sicherheitsgemeinschaft untersucht und zwanzig Themen in den Sektoren Gesundheit, Energie, Landwirtschaft und Umwelt identifiziert.*

Bioengineering bietet vielversprechende Ansätze, um die großen Herausforderungen in Angriff zu nehmen, denen unsere Gesellschaften ausgesetzt sind. Welche Entwicklungen hier kurzfristig und auch längerfristig besonders wichtig werden und welche Möglichkeiten und Risiken damit verbunden sind, hat ein internationales Team aus vorwiegend englischen und amerikanischen Experten aus ihrer Sicht als Wissenschafter, Innovatoren, Industrieangehörige und Sicherheitsgemeinschaft untersucht und zwanzig Themen in den Sektoren Gesundheit, Energie, Landwirtschaft und Umwelt identifiziert.*

Was versteht man unter Bioengineering?

In der allgemeinsten Definition bedeutet Bioengineering die Anwendung natur- und ingenieurwissenschaftlicher Konzepte und Methoden auf biologische Systeme. Sehr häufig wird synonym der Begriff Synthetische Biologie verwendet - beispielsweise definiert der wissenschaftliche Rat der Europäischen Akademien EASAC Synthetische Biologie als "Anwendung von Prinzipien der Ingenieurwissenschaften auf die Biologie". Dies ist auch in dem folgenden Text der Fall.

Identifizierung neuer, relevanter Entwicklungen im Bioengineering

Die raschen Fortschritte in synthetisch biologischen Praktiken ermöglichen es Probleme der realen Welt anzugehen: die gezielte Änderung des Erbguts ("Genome editing"), die neuen Möglichkeiten zur Geweberegeneration und zum Ersatz von Organen (u.a. mittels 3D-Printer) versprechen bislang ungeahnte Chancen für neue effiziente Therapien. Ebenso wird Bioengineering in den Sektoren Energie und Transport, in Landwirtschaft und Nahrungsmittelproduktion , Wasser- und Abfallmanagement eine wesentliche Rolle spielen.

Dass solche Anwendungen massive Auswirkungen auf die menschliche Gesellschaft haben werden, ist nur zu wahrscheinlich. Welche Entwicklungen des Bioengineering werden in näherer aber auch weiterer Zukunft relevant, welche Vorteile, welche Risiken werden sie bringen?

Dies behandelt eine eben, im frei zugänglichen Journal e-Life erschienene Untersuchung eines internationalen Expertenteams unter Leitung von Bonnie Wintle und Christian Böhm (University Cambridge, Centre for the Study of Existential Risk) [1]. Teilnehmer waren insgesamt 28 Wissenschafter aus Großbritannien und den Vereinigten Staaten mit unterschiedlichem Background in den Naturwissenschaften, Ingenieurwissenschaften, Sozial- und Geisteswissenschaften. In einem mehrstufigen Prozess - einem sogenannten Horizon Scan Verfahren - identifizierte und beschrieb jeder Teilnehmer auf Basis seiner Expertise - seiner Tätigkeit in der Industrie, als akademischer Forscher, Innovator oder als Sicherheitsexperte - 2 bis 5 Themen, die er für die wesentlichsten neuen Anwendungsgebiete im Bioengineering hielt. So resultierte anfänglich eine lange Liste von 70 neuen Gebieten, die von den Teilnehmern einzeln nach Neuheit, Plausibilität und Auswirkungen beurteilt wurden. Aus den Top-rankenden Themen entstand eine neue, kürzere Liste, jedes Thema wurde dann separat in Gruppen diskutiert und auf dieser Basis eine Endbewertung von jedem Einzelnen vorgenommen.

Schlussendlich liegt nun eine Liste von 20 relevanten Entwicklungen im Bioengineering vor. Im Folgenden sind einige davon angeführt, grob eingeteilt nach dem Zeitpunkt, an dem sie relevant werden können (d.i. Auswirkungen auf die Gesellschaft haben): in früher Zukunft (d.i. in weniger als 5 Jahren), zu einem späteren Zeitpunkt (5 - 10 Jahren) oder erst nach mehr als 10 Jahren.

Die wichtigsten Themen innerhalb der nächsten fünf Jahre

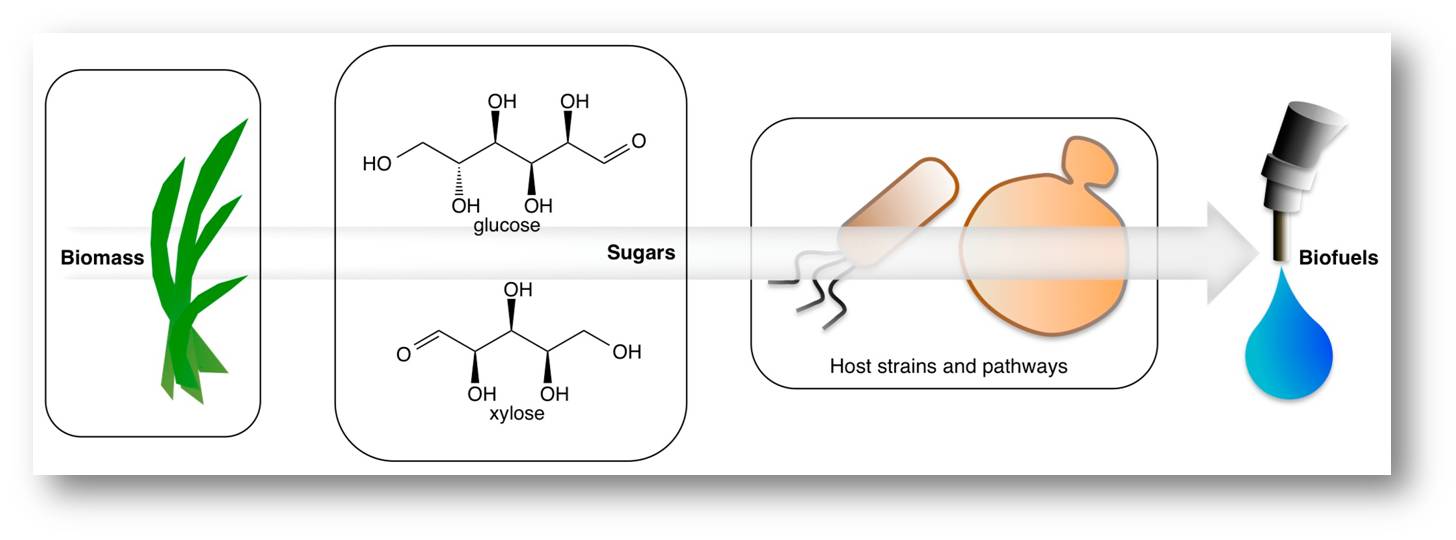

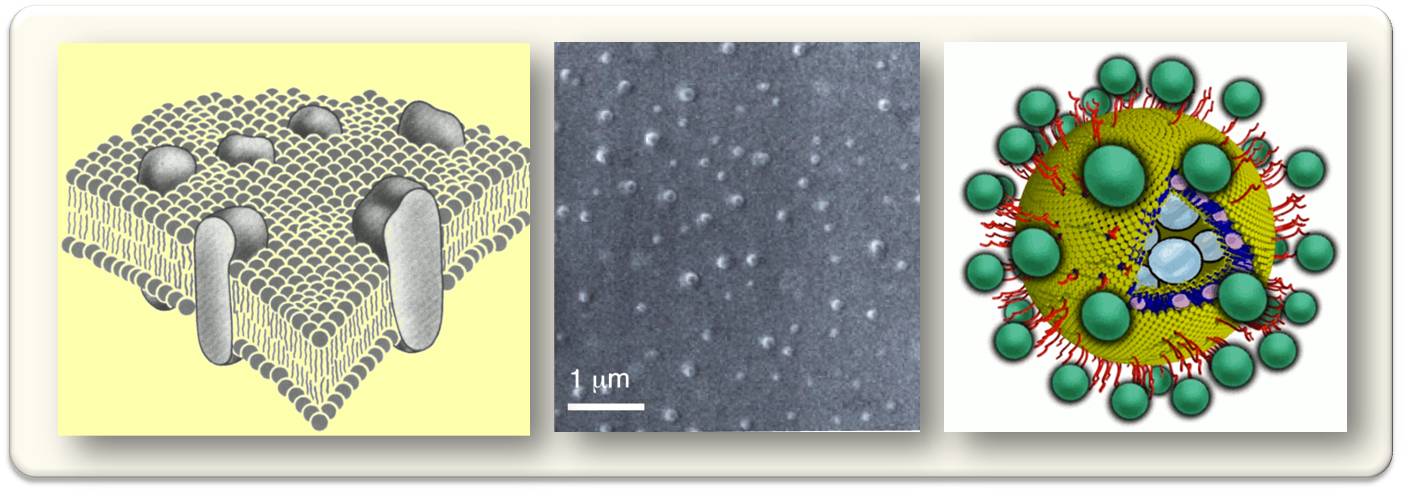

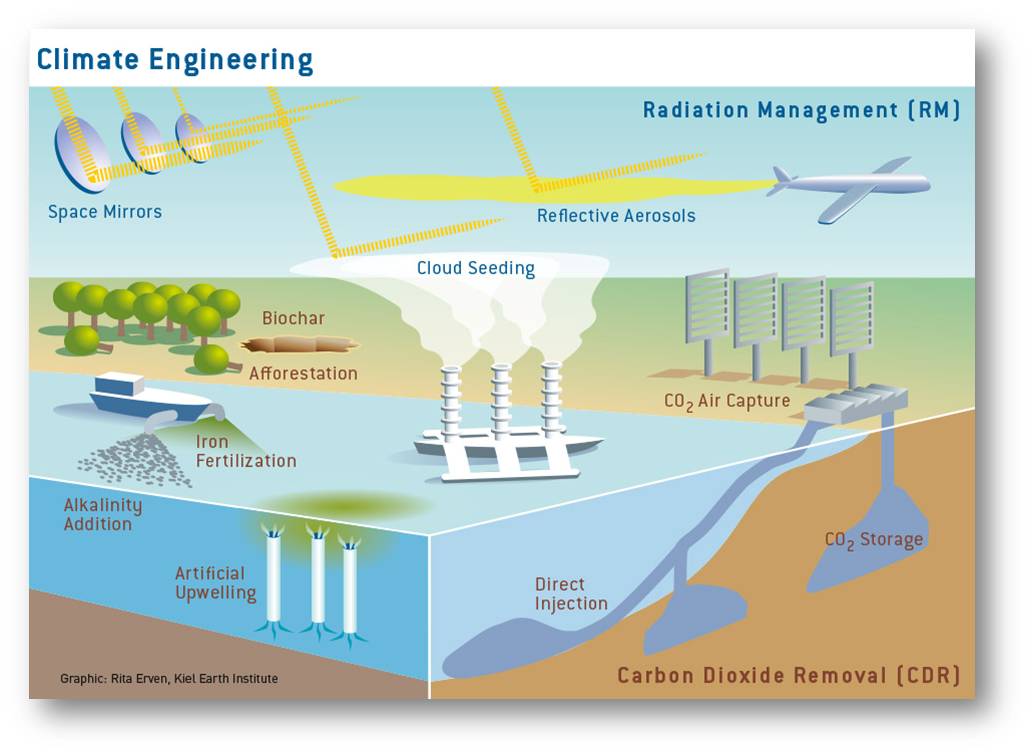

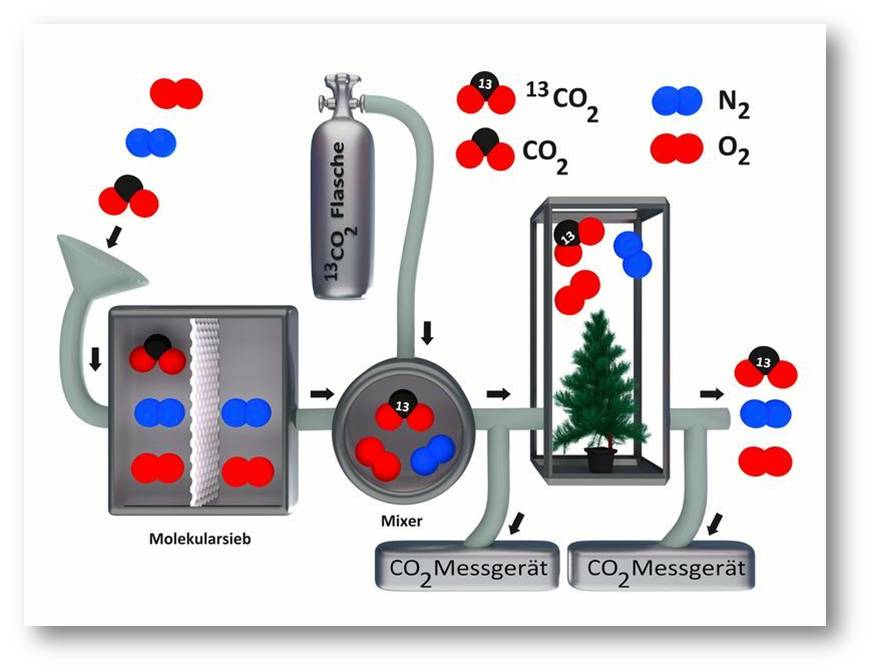

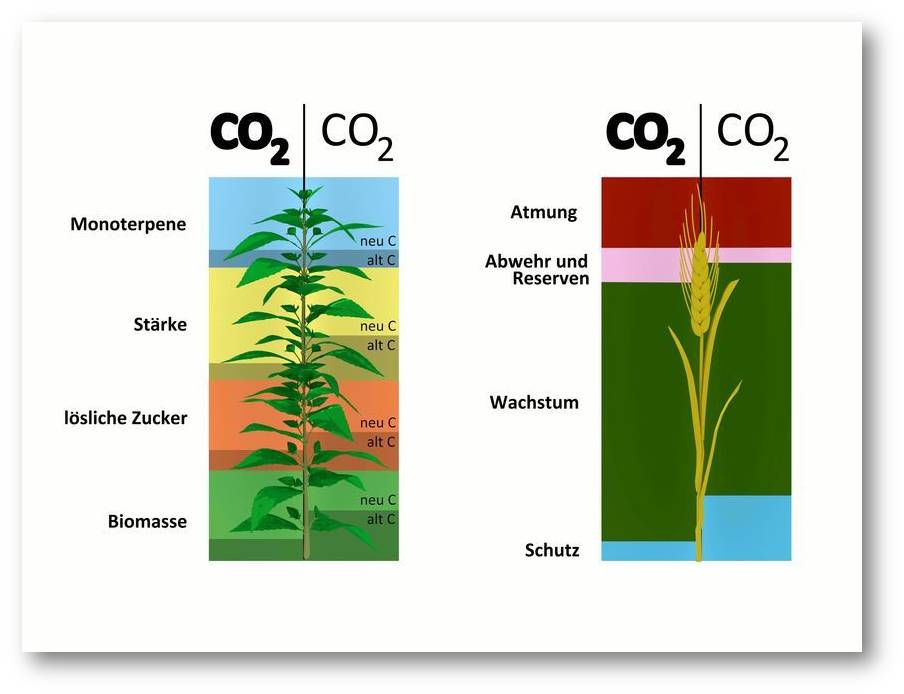

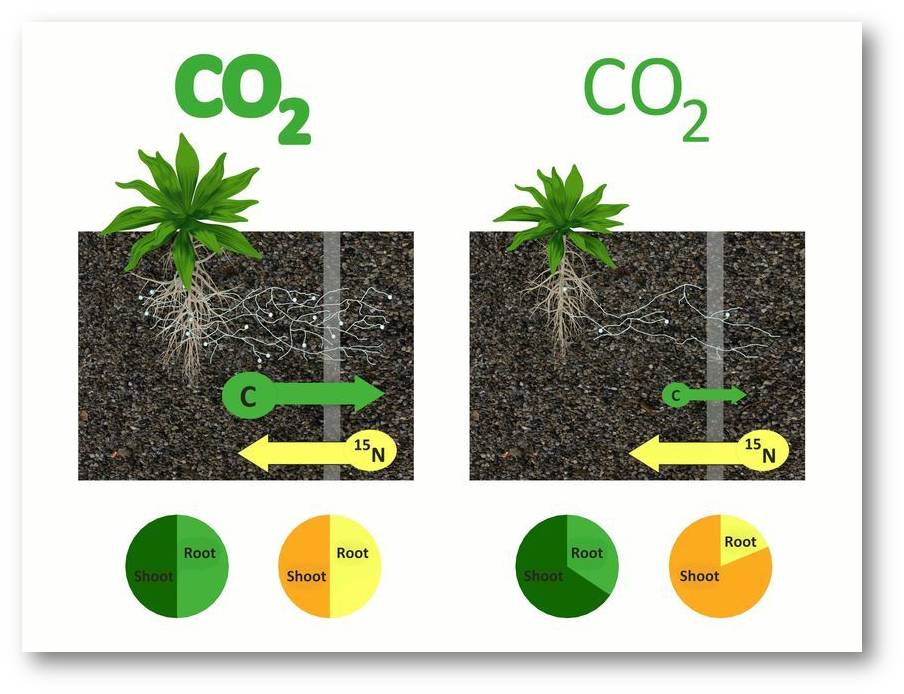

Künstliche Photosynthese und Kohlenstoffdioxydabscheidung zur Produktion von Biotreibstoffen

Wenn man die technischen Schwierigkeiten in den Griff bekommt, können solche Entwicklungen die künftige Einführung von Systemen zur Kohlenstoffabscheidung ermöglichen und dabei nachhaltige Quellen für Rohchemikalien und Treibstoffe liefern. Abbildung 1.

Abbildung 1. Aus Biomasse wird über geeignete Mikroorganismenstämme Treibstoff erzeugt. (Bild von der Redaktion eingefügt; Quelle: Kang, A.; Lee, T.S. Converting Sugars to Biofuels: Ethanol and Beyond. Bioengineering 2015, 2, 184-203 Artikel steht unter cc-by 4.0 Lizenz).

Abbildung 1. Aus Biomasse wird über geeignete Mikroorganismenstämme Treibstoff erzeugt. (Bild von der Redaktion eingefügt; Quelle: Kang, A.; Lee, T.S. Converting Sugars to Biofuels: Ethanol and Beyond. Bioengineering 2015, 2, 184-203 Artikel steht unter cc-by 4.0 Lizenz).

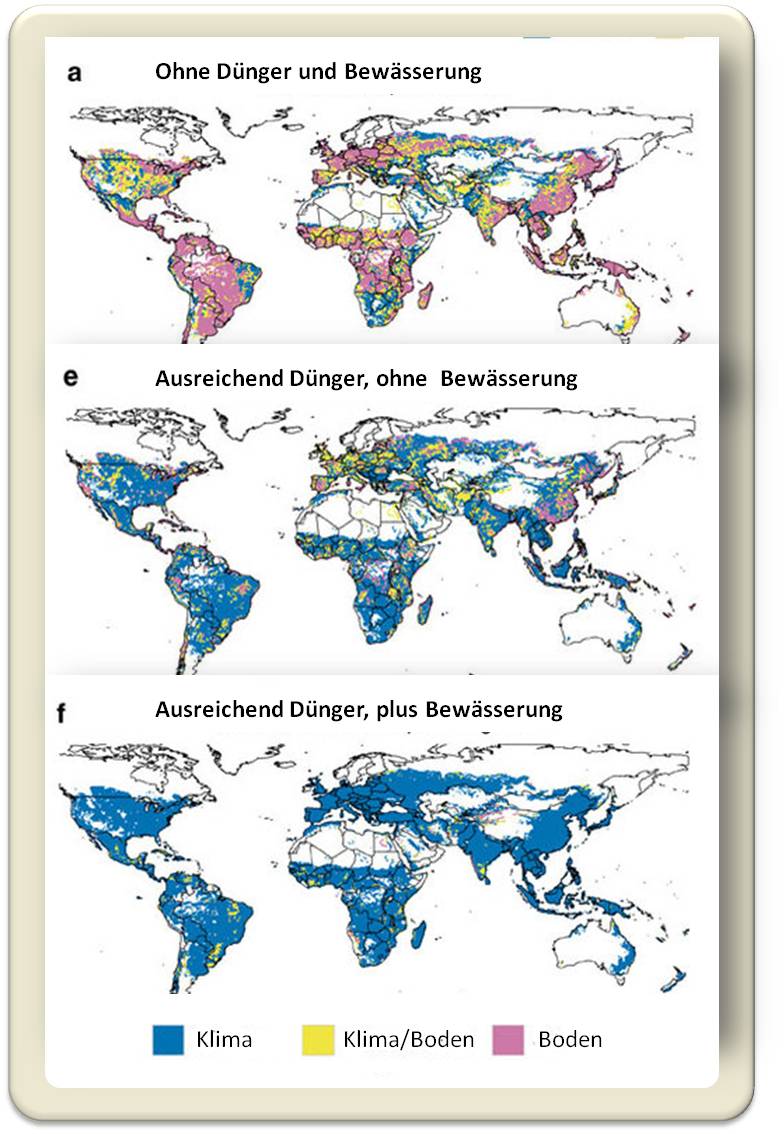

Ankurbeln der Photosynthese zur Steigerung der Produktivität in der Landwirtschaft

Um die Ernteerträge auf derzeit bewirtschaftetem Land zu steigern und die Sicherheit der Nahrungsversorgung zu gewährleisten, kommt der synthetischen Biologie eine Schlüsselrolle zu: durch Steigerung der Photosynthese, Reduzieren der Verluste in der Vor-Erntezeit und ebenso der Abfälle nach der Ernte und durch den Verbraucher.

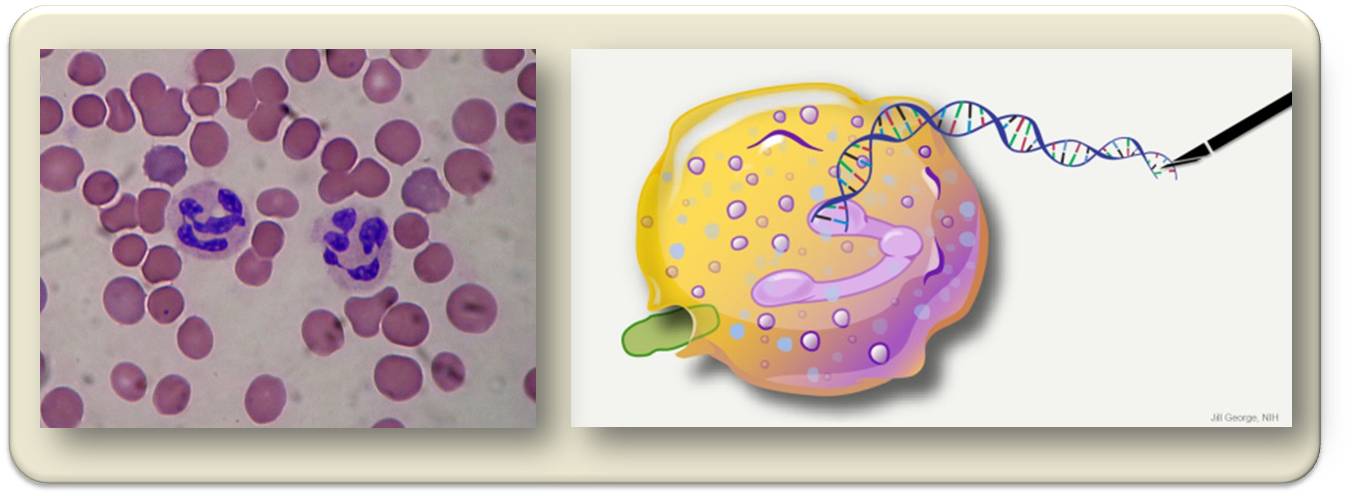

Neue Ansätze zur beschleunigten Ausbreitung von Genen (Gene drives)

Diese sollen die Vererbung wünschenswerter genetischer Merkmale in einer Spezies fördern, beispielsweise Malaria-übertragende Mücken davon abzuhalten sich zu vermehren. Bei dieser Technologie erhebt sich allerdings die Frage, ob damit nicht Ökosysteme verändert werden, möglicherweise Nischen geschaffen werden, in denen ein neuer Krankheitsüberträger oder sogar ein neuer Krankheitskeim Unterschlupf findet.

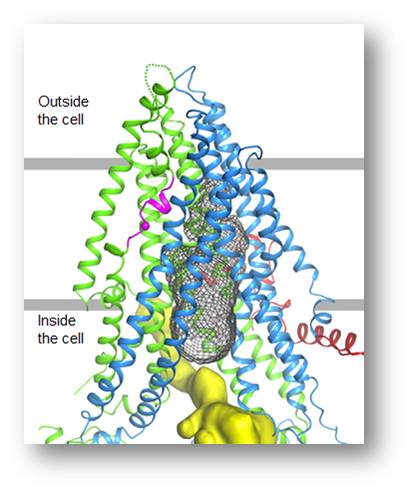

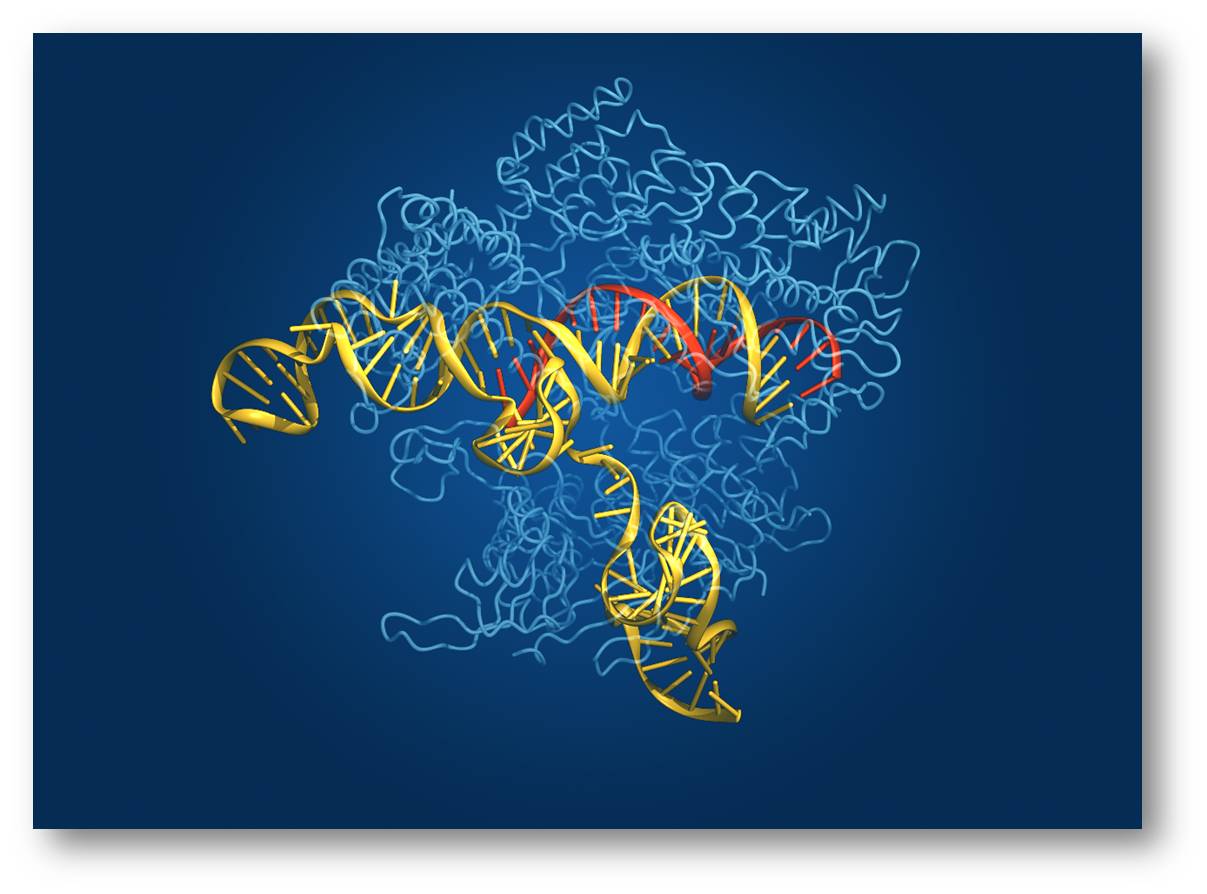

Gezielte Änderung des menschlichen Erbguts (Genome editing)

Technologien, wie beispielsweise das CRISPR/Cas9 System, bieten Möglichkeiten die Gesundheit des Menschen zu verbessern und seine Lebensdauer zu steigern. Allerdings schafft die Etablierung solcher Methoden größere ethische Probleme. Es ist ja machbar, dass dann Einzelpersonen aber auch Staaten mit den entsprechenden finanziellen und technologischen Mitteln strategische Vorteile an zukünftige Generationen weitergeben können.

Abwehrforschung

Behörden in den USA (US Defense Advanced Research Projects Agency DARPA ) und auch im UK (Defence Science and Technology Laboratory) investieren massiv in Forschungsgebiete der synthetischen Biologie, um bestimmte Bedrohungen abwehren oder darauf reagieren zu können. Investitionen im Bereich Landwirtschaft, "Gene drives" u.a. erhöhen das Risiko einer "doppelten Nutzung". Beispielsweise gibt es ein DARPA Programm (Insect Allies Program), das plant Insekten zu verwenden, um auf deren Futterpflanzen Merkmal verändernde Pflanzenviren zu verbreiten mit dem Ziel die Ernten vor möglichen Pflanzenpathogenen zu schützen. Allerdings können Andere derartige Technologien auch anwenden, um zielgerichtet Pflanzen zu schädigen.

Wichtigste Themen innerhalb der nächsten fünf bis zehn Jahre

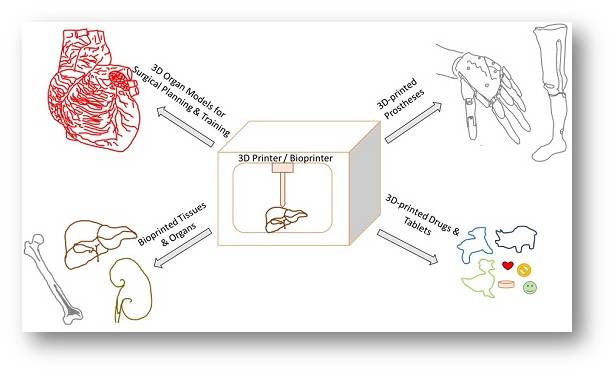

Regenerative Medizin - 3D Drucken von Körperteilen und Gewebetechnik

Diese Technologien werden zweifellos Beschwerden als Folge schwerer Verletzungen und unzähliger Krankheiten erleichtern. Abbildung 2.

Abbildung 2. 3D Drucken von Geweben, Organen und Prothesen. (Bild von Redaktion eingefügt; Quelle:S Vijayavenkataraman et al., Bioengineering 2017, 4(3), 63; doi:10.3390/bioengineering4030063. Der Artikel steht unter einer cc-by 4.0 Lizenz)

Dagegen ist ein Umkehren des altersbedingten Verfalls mit ethischen, sozialen und ökonomischen Bedenken belastet. Gesundheitssysteme würden sehr schnell an ihre Belastungsgrenze stoßen, wenn sie allen alternden Bürgern Körperteile ersetzen wollten. Es würde auch zu neuen sozioökonomischen Klassen führen, da nur diejenigen, ihre Jahre in Gesundheit ausdehnen könnten, die es sich leisten könnten.

Mikrobiom-basierte Therapien

Das Mikrobiom des Menschen ist in zahlreiche Krankheiten involviert - von Parkinson bis hin zum Darmkrebs und ebenso in Stoffwechselerkrankungen wie Fettsucht und Diabetes Typ 2. Ansätze der synthetischen Biologie können hier die Entwicklung wirksamerer Mikrobiota-basierter Therapien beschleunigen. Es gibt hier allerdings das Risiko, dass sich DNA von genetisch modifizierten Mikroorganismen auf andere Keime im menschlichen Mikrobiom oder in der weiteren Umgebung ausbreiten kann.

Schnittstelle von Informationssicherheit und Bioautomation

Fortschritte in der Automatisierungstechnik verbunden mit schnelleren und verlässlicheren Verfahrenstechniken haben zur Entstehung von "Robotic Cloud Labs" geführt: in diesen wird digitale Information in DNA umgesetzt und diese dann in einigen Zielorganismen exprimiert. Dies erfolgt mit sehr hohem Durchsatz und sinkender Überwachung durch den Menschen. Das hohe Vertrauen in Bioautomatisierung und der Einsatz von digitaler Information aus vielen Quellen öffnen die Möglichkeit zu neuen Bedrohungen für die Informationssicherheit: ein Herumpfuschen an digitalen DNA-Sequenzen könnte die Produktion schädlicher Organismen nach sich ziehen, Angriffe auf kritische DNA Sequenz-Datenbanken und auf die Ausrüstung könnte die Herstellung von Vakzinen und Arzneimitteln sabotieren.

Wichtigste langfristigeThemen

Neue Hersteller stören die Pharma-Märkte

Gemeinschaftliche Bio-Laboratorien und unternehmerische Startups adaptieren und teilen Methoden und Geräte für biologische Experimente und Techniken. Verbunden mit Open-Business Modellen und Open Source Technologien kann dies Gelegenheiten bieten, um maßgeschneiderte Therapien für regionale Krankheiten zu produzieren, welche große multinationale Konzerne als nicht genug profitabel ansehen. Dies lässt aber wieder Bedenken aufkommen betreffend einer (Zer)störung existierender Herstellermärkte und der Versorgungsketten mit Rohmaterialien und ebenso Befürchtungen hinsichtlich unzulänglicher Regulierung, weniger strenger Kontrolle der Produkte und falscher Anwendung.

Plattform-Technologien um Ausbrüche von Pandemien anzugehen

Ausbrüche von Infektionskrankheiten - wie jüngst die Ausbrüche von Ebola und Zika Virusinfektionen - und mögliche Angriffe mit biologischen Waffen benötigen skalierbare, flexible Diagnostik und Behandlung. Neue Technologien können die rasche Identifizierung des Verursachers, die Entwicklung von Vakzinen(Kandidaten) und Pflanzen-basierte Produktionssysteme für Antikörper ermöglichen.

Veränderte Eigentümer-Modelle in der Biotechnologie

Der Anstieg von patentfreien, generischen Hilfsmitteln und das Absinken der technischen Barrieren in der Ingenieurbiologie kann Menschen in ressourcenarmen Gebieten helfen eine nachhaltige Bioökonomie zu entwickeln, die auf lokalen Bedürfnissen und Prioritäten basiert.

Fazit

Das Wachstum der bio-basierten Ökonomie verspricht Nachhaltigkeit und neue Methoden, um auf globale Herausforderungen durch Umweltprobleme und Gesellschaft zu reagieren. Wie die vorliegende Untersuchung zeigt, können aber daraus auch neue Herausforderungen und Risiken entstehen. Es muss also umsichtig vorgegangen werden, um die Vorteile sicher zu erhalten.

[1] Bonnie C Wintle, Christian R Boehm, Catherine Rhodes, Jennifer C Molloy, Piers Millett, Laura Adam, Rainer Breitling, Rob Carlson, Rocco Casagrande, Malcolm Dando, Robert Doubleday, Eric Drexler, Brett Edwards, Tom Ellis, Nicholas G Evans, Richard Hammond, Jim Haseloff, Linda Kahl, Todd Kuiken, Benjamin R Lichman, Colette A Matthewman, Johnathan A Napier, Seán S ÓhÉigeartaigh, Nicola J Patron, Edward Perello, Philip Shapira, Joyce Tait, Eriko Takano, William J Sutherland. A transatlantic perspective on 20 emerging issues in biological engineering. eLife, 2017; 6 DOI: 10.7554/eLife.30247

*Dem vorliegenden Artikel wurden im Wesentlichen der am 21. November 2017 in den News der University Cambridge erschienene Bericht: "Report highlights opportunities and risks associated with synthetic biology and bioengineering" und kurze Sequenzen aus dem Originalartikel [1] zugrunde gelegt . Beide Quellen sind unter cc-by 4.0 lizensiert. Die möglichst wortgetreue Übersetzung stammt von der Redaktion.

Weiterführende Links

- The Future of Medicine Cambridge University. Video 11:41 min. Nanobots that patrol our bodies, killer immune cells hunting and destroying cancer cells, biological scissors that cut out defective genes: these are just some of the technologies that Cambridge University researchers are developing and which are set to revolutionise medicine in the future. To tie-in with the recent launch of the Cambridge Academy of Therapeutic Sciences, researchers discuss some of the most exciting developments in medical research and set out their vision for the next 50 years.

Artikel im ScienceBlog

- Helge Torgenson; 26.07.2013: Sag, wie ist die Synthetische Biologie? Die Macht von Vergleichen für das Image einer Technologie

- Peter Schuster; 19.07.2013: Können wir Natur und Evolution übertreffen? Teil 2: Zum Design neuer Strukturen

- Peter Schuster; 12.07.2013: Können wir Natur und Evolution übertreffen? Teil 1: Gedanken zur Synthetischen Biologie

- Gerhard Wegner; 28.06.2013: Anmerkungen eines Laien zur Synthetischen Biologie – Teil 2

- Gerhard Wegner ; 21.06.2013: Anmerkungen eines Laien zur Synthetischen Biologie – Teil 1

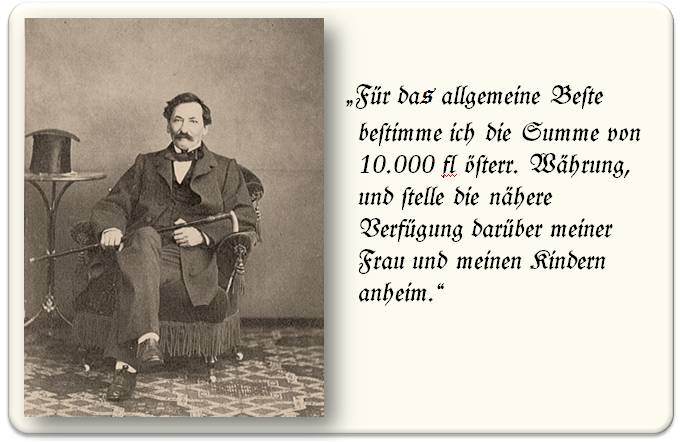

Die Evolution der Darwinschen Evolution

Die Evolution der Darwinschen EvolutionDo, 30.11.2017 - 07:12 — Herbert Matis

![]() „Im neunzehnten Jahrhundert hat kein wissenschaftliches Werk ein so gewaltiges Aufsehen erregt, eine so nachhaltige Wirkung ausgeübt, und eine so gründliche Umwälzung althergebrachter Anschauungen bei Fachleuten wie bei Laien hervorgerufen (WT Preyer; 1841-1897)". Der Wirtschafts- und Sozialhistoriker Herbert Matis (emer. Prof. Wirtschaftsuniversität Wien) gibt einen Überblick zur Rezeption der Darwinschen Theorien, die weit über die naturwissenschaftliche Fachwelt hinausgingen und weitreichende Implikationen nicht nur für Philosophie und Theologie, sondern auch für den Bereich des Politischen und Sozialen verursachten und selbst am Beginn des 21. Jahrhunderts prominente Gegnerschaft finden..*

„Im neunzehnten Jahrhundert hat kein wissenschaftliches Werk ein so gewaltiges Aufsehen erregt, eine so nachhaltige Wirkung ausgeübt, und eine so gründliche Umwälzung althergebrachter Anschauungen bei Fachleuten wie bei Laien hervorgerufen (WT Preyer; 1841-1897)". Der Wirtschafts- und Sozialhistoriker Herbert Matis (emer. Prof. Wirtschaftsuniversität Wien) gibt einen Überblick zur Rezeption der Darwinschen Theorien, die weit über die naturwissenschaftliche Fachwelt hinausgingen und weitreichende Implikationen nicht nur für Philosophie und Theologie, sondern auch für den Bereich des Politischen und Sozialen verursachten und selbst am Beginn des 21. Jahrhunderts prominente Gegnerschaft finden..*

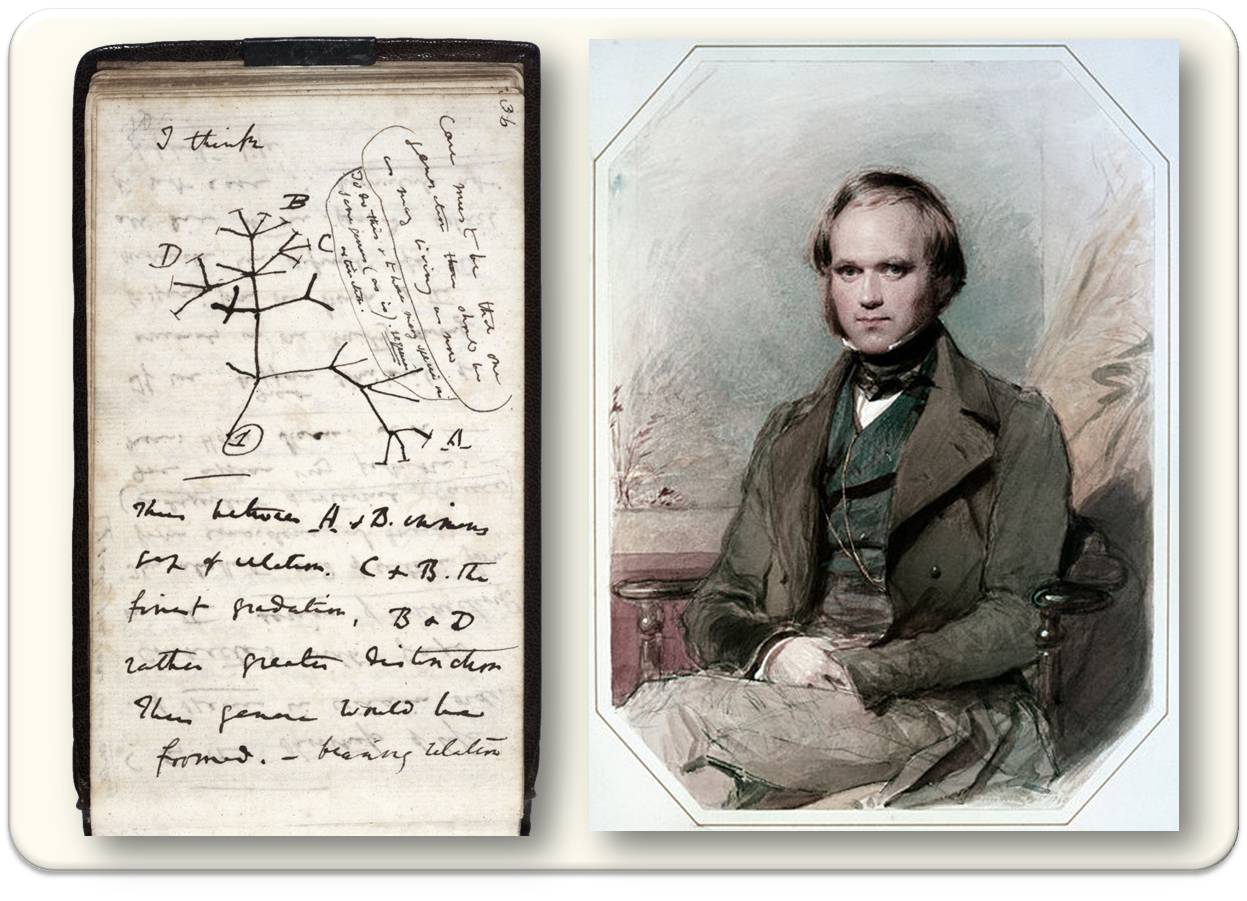

In der Geschichte der Naturwissenschaften und darüber hinaus nimmt Charles Robert Darwin (1809-1882) einen besonderen Platz ein, gilt er doch gemeinsam mit seinem Landsmann Alfred Russel Wallace (1823-1913) als Begründer der evolutionären Biologie. Den Grundstein seiner späteren naturwissenschaftlichen Karriere hat Darwin im Zuge seiner von Ende 1831 bis 1836 dauernden Expeditionsreise gelegt. Diese führte ihn auf der von der Royal Navy mit Vermessungsarbeiten, chronometrischen Bestimmungen und kartographischen Aufnahmen betrauten 242 Tonnen-Brigg HMS Beagle rund um die Welt. Die Publikation seines umfangreichen Reiseberichts (1839), die auf Auswertungen seiner Notizbücher und einer in zwölf Katalogen festgehaltenen systematischen Sammeltätigkeit von Fossilien, Gesteinen, Pflanzen und Tieren beruhte, sowie weitere wissenschaftliche Veröffentlichungen als Ergebnis dieser Reise sicherten ihm in Fachkreisen bereits ab den 1840er Jahren erste Anerkennung als Geologe, Zoologe und Botaniker.

"Stammbaums des Lebens"…

In einem seiner Notizbücher entwarf Darwin eine erste Skizze eines "Stammbaums des Lebens": unter der Überschrift "I think" stellte er die Entstehung der Arten durch eine differenzierte Aufspaltung in einzelne Äste und Zweige in Form von Bifurkationen dar. Abbildung 1.

Damit postulierte Darwin ‑ gestützt auf zahlreiche Fossilienfunde ‑ seine Theorie einer gemeinsamen Abstammung, wonach über Jahrmillionen zurückreichende Generationenketten letztlich alle Lebewesen miteinander verwandt sind. Auf Basis seiner auf induktivem Wege gewonnenen Erkenntnisse stellte Darwin erste theoretische Überlegungen im Hinblick auf die Wechselbeziehung zwischen Organismen und Umwelt an und erkannte, dass sich Organismen mittels Variation und natürlicher Selektion an ihr jeweiliges Habitat anpassen.

Abbildung 1. Der Stammbaum des Lebens (links). Erste Skizze, die Darwin auf der Beagle in seinem Notizbuch B, p. 36 erstellte (1836) und Darwin nach seiner Rückkehr (rechts) von der Reise auf der Beagle (Aquarell von George Richmond).

…und struggle for life

Die Frage, warum die Arten variieren, konnte Darwin aufgrund des genauen Studiums von Haustieren auf den umbildenden Einfluss der künstlichen Zuchtwahl durch den Menschen zurückführen; für die Veränderung der Arten durch natürliche Zuchtwahl fand er hingegen eine Entsprechung im Prinzip des struggle for life, wonach sich in der freien Natur jene Varietäten durchsetzen, die am besten an ihre Umwelt angepasst sind und damit die günstigsten Überlebenschancen vorfinden.

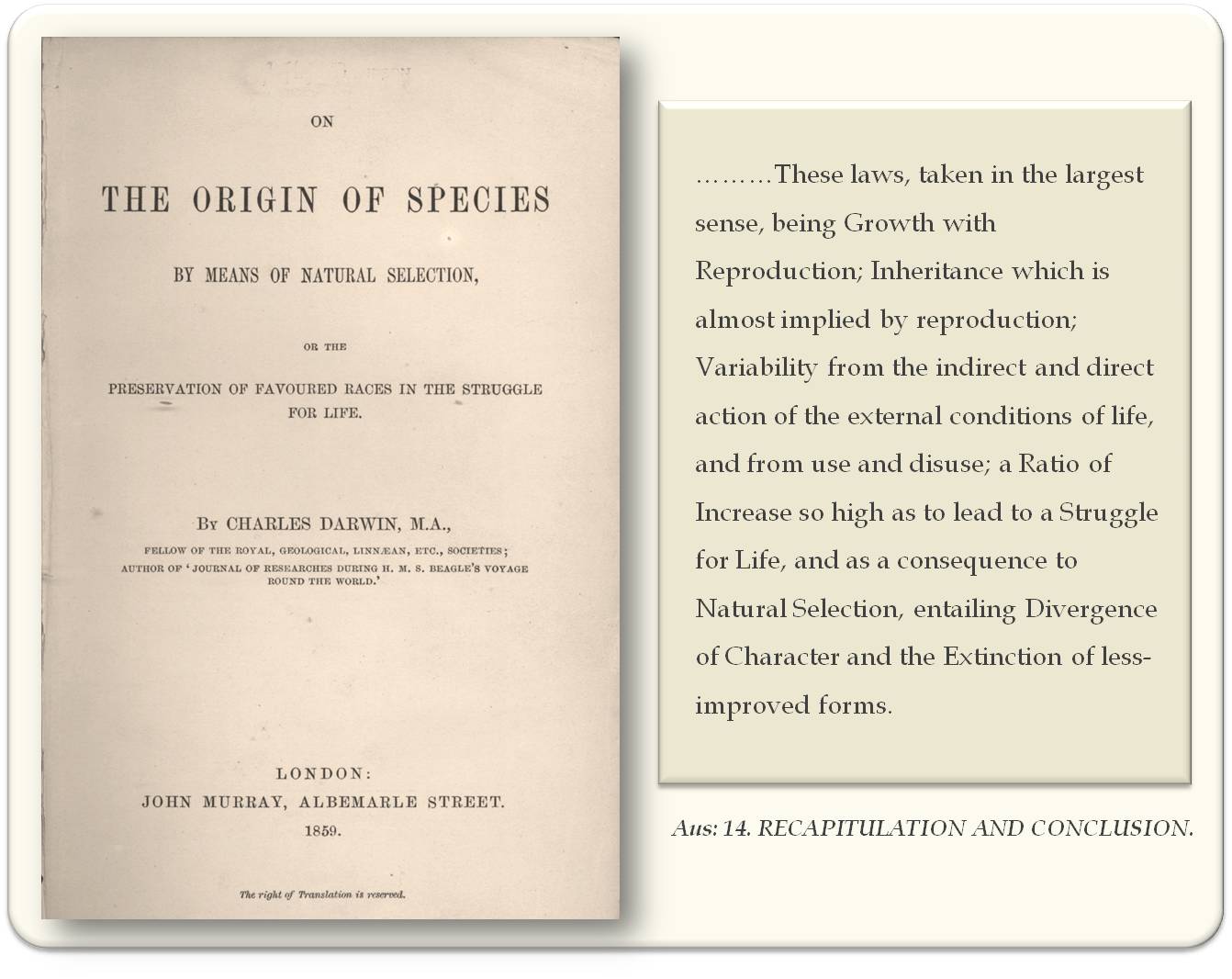

Im Jahr 1859 publizierte Darwin dann sein revolutionäres Werk, das ihn mit einem Schlag berühmt machte: On the origin of species by means of natural selection, or the preservation of favoured races in the struggle for life. Abbildung 2.

Abbildung 2. On the origin of species by means of natural selection, or the preservation of favoured races in the struggle for life [1859; Über die Entstehung der Arten im Thier- und Pflanzen-Reich durch natürliche Züchtung, oder Erhaltung der vervollkommneten Rassen im Kampfe ums Dasein]. (Abbildungen: links Wikipedia; rechts: http://www.gutenberg.org/cache/epub/1228/pg1228.txt)

Der große internationale Erfolg führte dazu, dass er nahezu ein Jahrzehnt später eine zweite Veröffentlichung folgen ließ: The Variation of Animals and Plants under Domestication [dt.: Die Variation von Tieren und Pflanzen unter Domestikation].

Evolution wird zum Leitmotiv der Wissenschaft

Entwicklung - Evolution (abgeleitet vom lateinischen Verbum evolvere, das ursprünglich vor allem das Ausrollen einer Schriftrolle bedeutete) wird im 19. Jahrhundert zum Paradigma in der Wissenschaft. Die Vorstellung der biologischen Evolution liefert eine naturwissenschaftlich fundierte Erklärung für die Entstehung und Veränderung der Arten im Verlauf der Erdgeschichte, wobei sich alle derartigen Prozesse in der Natur durch eine Irreversibilität auszeichnen. In der Folge findet der Begriff auch in den Sozialwissenschaften Eingang.

Wettbewerb um Ressourcen

Als wichtige Antriebsmomente der Evolution formulierte Darwin die Prinzipien der notwendigen Anpassung an Umweltbedingungen durch natürliche Selektion. Im Wettbewerb um Ressourcen setzen sich unter limitierenden Umweltbedingungen die vorteilhafteren Variationen durch, während hingegen unvorteilhafte Variationen aus der Population verschwinden werden. Angeregt zu diesen Überlegungen wurde Darwin durch die vieldiskutierte Bevölkerungstheorie des Ökonomen Thomas Robert Malthus (1766 - 1834). Dieser hatte festgestellt, dass ein unkontrolliertes exponentielles Bevölkerungswachstum zwangsläufig in einer Konkurrenz um immer knappere Ressourcen münden müsse, weil sich diese lediglich in einer arithmetischen Folge vermehren.

Im Sozialdarwinismus kommt es dann zur Übertragung der Darwinschen Prinzipien auf menschliche Gesellschaften, um etwa soziale Ungleichheit oder rassische Diskriminierung als Folge einer ‚natürlichen Auslese‘ zu rechtfertigen. Bereits Vertreter der Klassischen Nationalökonomie verwendeten zentrale Begriffe der Evolutionsbiologie wie ‚Evolution‘‚ Selektion‘ und ‚Kampf ums Überleben‘ in einem gesellschaftswissenschaftlichen Kontext.

In der zweiten Hälfte des 19. Jahrhunderts

messen viele Disziplinen der zeitlichen Dimension und damit auch dem Entwicklungsgedanken einen besonderen Stellenwert bei, und sehr bald wird Evolution auch ganz allgemein als maßgebliches Grundmuster für die Erklärung von Prozessen aller Art verstanden. Spätestens ab Ende der 1870er Jahre wird Darwins Lehre zum Gegenstand des öffentlichen Diskurses und dann in Form des ‚Darwinismus‘ auch als Weltanschauung vereinnahmt.

Für die Verbreitung der Darwinschen Lehre

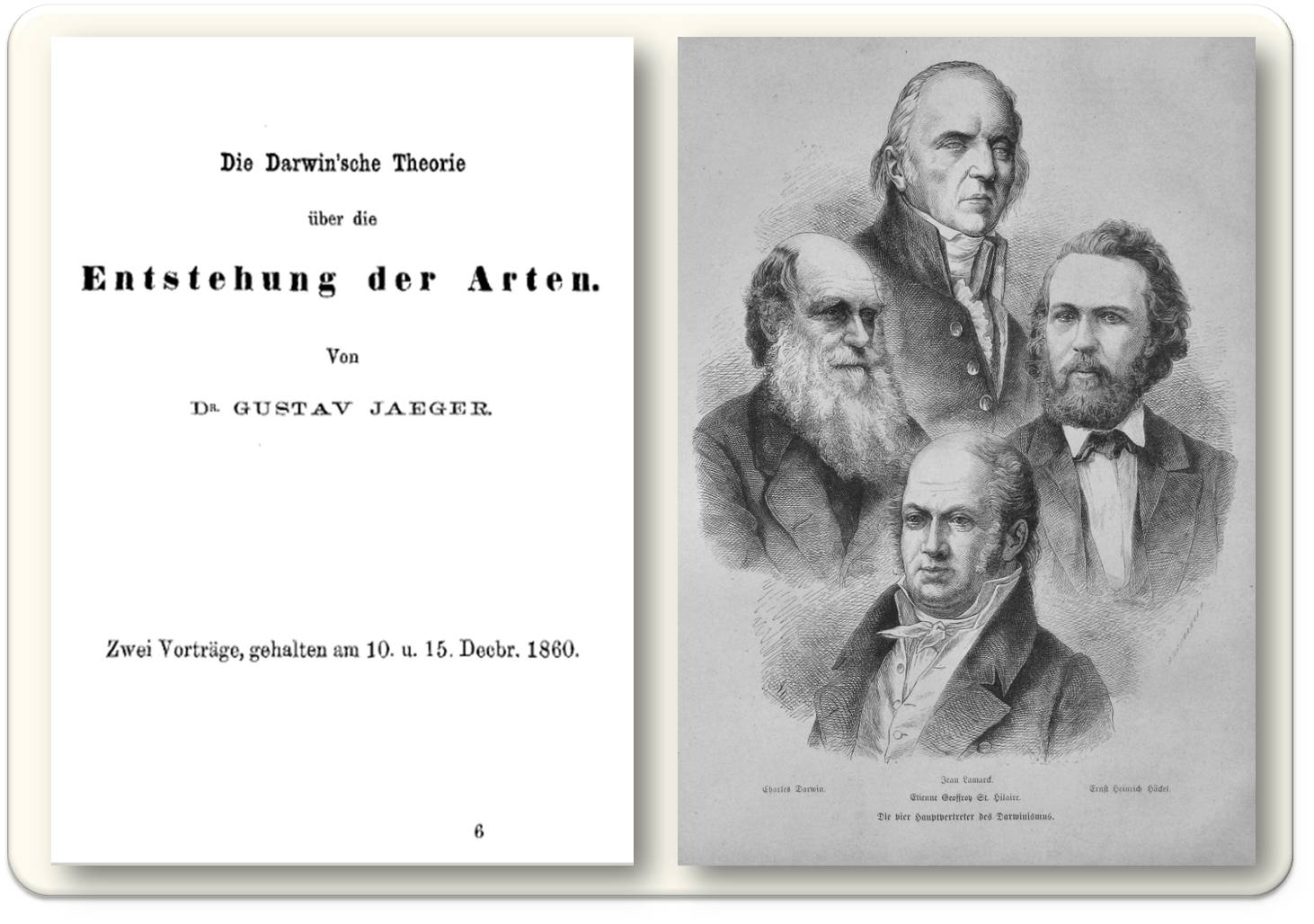

im deutschen Sprachraum spielten die ersten Übersetzungen, vor allem von On the Origin of Species, eine wichtige Rolle, die bereits 1860 erfolgten. Die Universitäten Jena - vor allem mit dem Biologen und Mediziner Ernst Haeckel - und Leipzig wurden immer mehr zum Zentrum des Darwinismus in Deutschland. Haeckel und seine Schüler erblickten in Darwins Evolutionslehre eine Möglichkeit, alle ‚Welträtsel‘ ausschließlich mit wissenschaftlichen Methoden zu erklären und Haeckel veröffentlichte in diesem Sinn eine ganz Reihe von Büchern.

Darwin fand nicht nur in der Fachwelt große Resonanz, sondern auch in der breiteren naturwissenschaftlich interessierten Öffentlichkeit, wozu eine Vielzahl zeitgleich entstandener gelehrter Gesellschaften, aber auch die Gründung von einschlägigen Museen und Sammlungen sowie populärwissenschaftlichen Journalen und u.a. das in mehrere Sprachen übersetzte und in weiten Kreisen des Bildungsbürgertums gelesene Werk von Alfred Edmund Brehm Illustrirtes Thierleben beitrugen. (Zu Letzterem hatte u. a. auch der österreichische Kronprinz Rudolf einige ornithologische Studien beigesteuert.) Darwins Theorien lieferten daher auch in literarischen Zirkeln Diskussionsstoff. Abbildung 3.

Die Ausgangsbedingungen für eine Akzeptanz der Lehre Darwins in dem vom Katholizismus geprägten Milieu der einstigen Habsburgermonarchie waren ungleich schwieriger. Für die Verbreitung der Darwinschen Lehre über den engeren Kreis der Fachwissenschaft hinaus, sorgte allerdings bereits 1860 der aus Deutschland stammende Zoologe Gustav Jäger, der in Wien vor einem wissenschaftlich interessierten Laienpublikum für die Auffassungen Darwins eintrat. Abbildung 3.

Abbildung 3. Popularisierung der Evolutionstheorie. Links: Vortrag von Gustav Jäger 1860 in Wien (Text: http://www.zobodat.at/pdf/SVVNWK_1_0081-0110.pdf ), Rechts: aus dem Illustrirten Familienblatt "Die Gartenlaube" (1873) „Die vier Hauptvertreter des Darwinismus“: Darwin, Lamarck, Haeckel, St. Hilaire (Wikipedia, gemeinfrei)

Abbildung 3. Popularisierung der Evolutionstheorie. Links: Vortrag von Gustav Jäger 1860 in Wien (Text: http://www.zobodat.at/pdf/SVVNWK_1_0081-0110.pdf ), Rechts: aus dem Illustrirten Familienblatt "Die Gartenlaube" (1873) „Die vier Hauptvertreter des Darwinismus“: Darwin, Lamarck, Haeckel, St. Hilaire (Wikipedia, gemeinfrei)

Darwin fand in der deutschen Gelehrtenwelt nicht nur Anhänger, sondern auch einflussreiche Gegner. Dies betraf vor allem das von mancher Seite dem Darwinismus zugeschriebene pseudoreligiöse Deutungsmonopol. Einer der Hauptgegner der Evolutionstheorie und des Darwinismus im Besonderen war der Botaniker Albert Wigand (1821-1886), Direktor des Botanischen Gartens und Pharmazeutischen Instituts in Marburg an der Lahn, der die Lehre Darwins sogar als eine „naturwissenschaftliche und philosophische Verirrung“ abtat.

"Verweltanschaulichung" der Lehre Darwins…

Lange Zeit hatte es Darwin vermieden, wahrscheinlich unter dem Einfluss seiner sehr religiös geprägten Frau Emma, seine Erkenntnisse auch im Hinblick auf die menschliche Spezies anzuwenden und konsequent auch den Menschen in den von seiner Richtung her offenen Prozess der Evolution einzubinden. Erst 1871 erschien sein zweibändiges Werk The Descent of Man, and Selection in Relation to Sex [dt.: Die Abstammung des Menschen und die geschlechtliche Zuchtwahl], in dem er festhielt, was mittlerweile auch durch DNA-Vergleiche bestätigt wird, dass der Mensch und andere Primaten recht eng verwandt sind und offenbar einen gemeinsamen Vorfahren haben, der vor etwa fünf bis sieben Millionen Jahren lebte.

Mit The Descent of Man erfolgte eine wichtige Erweiterung seiner Konzeption, indem er nicht nur eine Sonderstellung des Menschen in der Natur verneinte und die Abstammung des Menschen in einen allgemeinen Zusammenhang mit der biologischen Evolution stellte: Der Mensch ist wie alle anderen Lebewesen ein Produkt der Evolution. Überdies definierte er mit der sexuellen Selektion einen zweiten Selektionsmechanismus, der sich etwa bei dem Mitbegründer der modernen Evolutionstheorie Wallace nicht findet.

Während Darwin ‚Evolution‘ als ein universelles Prinzip in der Natur verstand, versuchte schon Alfred Russel Wallace, seine wissenschaftlichen Erkenntnisse mit dem Glauben an ein höheres Wesen zu vereinen. Der Prozess der Evolution selbst, aber auch höhere Fähigkeiten wie Bewusstseinsbildung, intellektueller Fortschritt, Intelligenz oder die Ausbildung von Moral konnten aus seiner Sicht mit dem Selektionsprinzip nicht hinreichend erklärt werden, sondern setzten das Wirken einer übernatürlichen Macht voraus. Alle derartigen Versuche, den Evolutionsgedanken mit einem Schöpfungsplan zu vereinen und an Stelle des Zufallsprinzips und eines mechanistisch aufgefassten Wirkgefüges von Variabilität und Selektion das Wirken eines höheren Wesens zu setzen, mussten aus der Sicht der konsequenten Anhänger Darwins hingegen als Einfallstor für metaphysische Spekulationen aufgefasst werden.

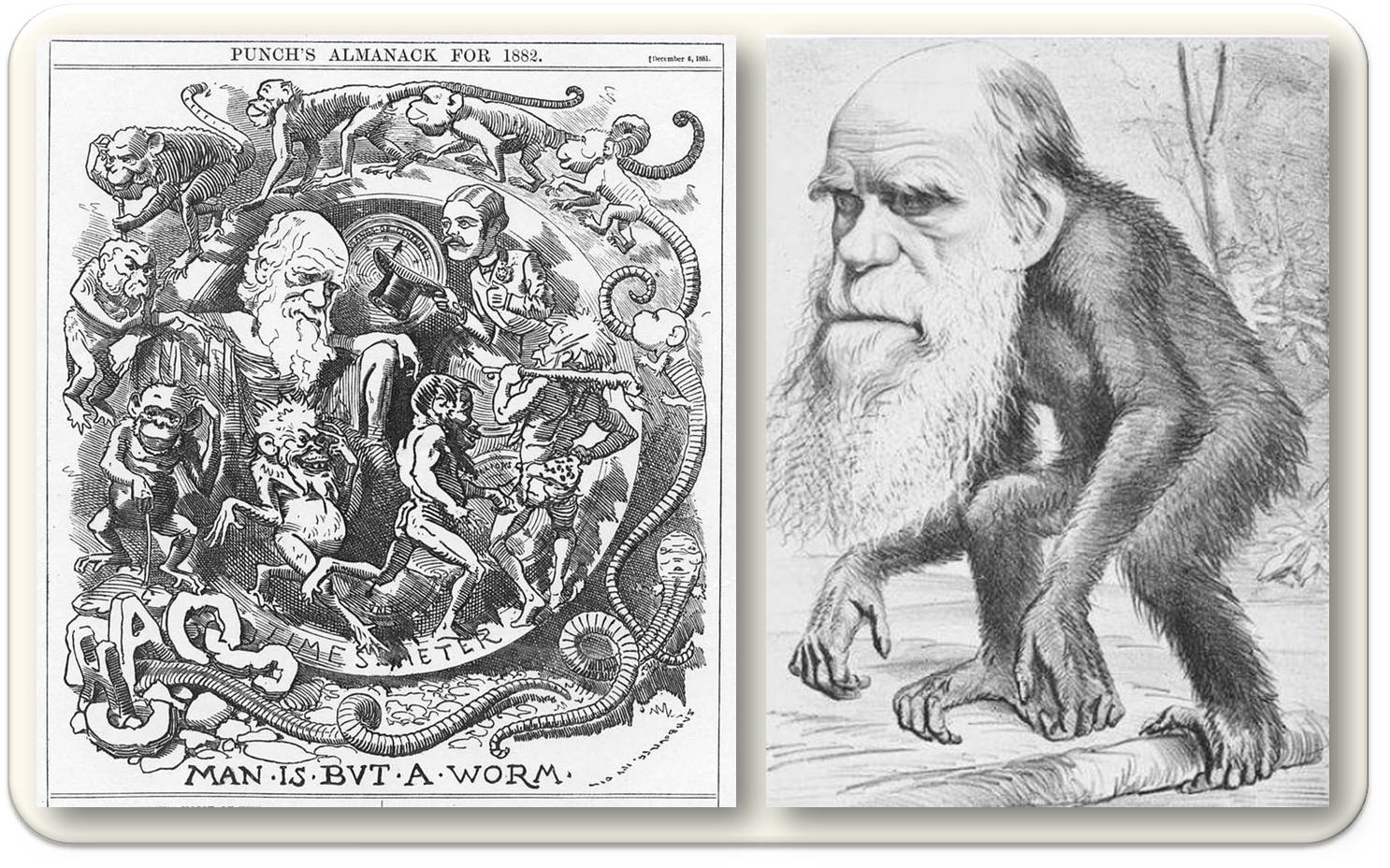

…und ein "Kampf der Kulturen",

der in der Öffentlichkeit mit zum Teil auch recht unsachlichen Argumenten ausgetragen wurde (Abbildung 4) und u. a. zu einer legendären Kontroverse mit Vertretern des anglikanischen Episkopat führte. Verschiedene Theologen taten den Darwinismus in der Folge als „Theorie der Affenabstammung“ ab, auf der anderen Seite begegneten die Anhänger von Darwins Evolutionstheorie den in der tradierten biblischen Schöpfungsgeschichte verhafteten Theologen mit Hohn und Spott, weil diese einen ,Kreationismus‘ sowie die Vorstellung einer Entwicklung nach einem allem zugrundeliegenden teleologischen göttlichen Plan vertraten. Bereits Darwins erster deutscher Übersetzer, Heinrich Georg Bronn, hatte darauf hingewiesen, dass „mit weiterer Hilfe der Darwinschen Theorie eine Natur-Kraft denkbar (ist), welche Organismen-Arten hervorgebracht haben kann […] Wir sind dann nicht mehr genöthigt, zu persönlichen außerhalb der Natur-Gesetze begründeten Schöpfungs-Akten unsere Zuflucht zu nehmen".

Abbildung 4. Der Mensch ist nur ein Wurm:-Entwicklung über den Affen zum viktorianischen Gentleman (Punsch Almanach, 1882) und Darwin Karikatur im Magazin "The Hornet" (1871) (Bilder: Wikipedia, gemeinfrei)

Abbildung 4. Der Mensch ist nur ein Wurm:-Entwicklung über den Affen zum viktorianischen Gentleman (Punsch Almanach, 1882) und Darwin Karikatur im Magazin "The Hornet" (1871) (Bilder: Wikipedia, gemeinfrei)

Im Verein mit dem philosophischen Positivismus wurde der Darwinismus damit ein Schlüsselelement bei der Entstehung der modernen ‚wissenschaftlichen Weltanschauung‘.

Vor allem formierte sich der Widerstand kirchlich-dogmatischer Kreise, die sehr bald die von der modernen Evolutionstheorie ausgehende Gefahr für die kirchliche Lehre erkannten: Papst Pius IX. wandte sich bereits 1864 in dem seiner Enzyklika Quanta Cura beigefügten Syllabus errorum explizit gegen die als Irrtümer klassifizierten verschiedenen ‚-Ismen‘: Liberalismus, Sozialismus, Kommunismus, Pantheismus, Naturalismus, und selbstverständlich auch Darwinismus. Auch sein Nachfolger Pius X. verdammte 1907 in seiner Enzyklika Pascendi dominici gregis die „Irrtümer des Modernismus“, insbesondere aber jene katholischen Theologen, die versuchten, moderne wissenschaftliche Erkenntnisse - vor allem die historisch-kritische Methode in der Geschichtswissenschaft und die Evolutionstheorie - in ihre Lehre zu integrieren. Die katholische Kirche bezog damit eine eindeutige Opposition gegenüber allen materialistischen Auffassungen. Erst mit dem Zweiten Vatikanischen Konzil erfolgte hier 1962/64 – nicht zuletzt aufgrund der viel diskutierten Schriften des Anthropologen und Jesuiten Pierre Teilhard de Chardin (1881-1955) – eine geistige Öffnung.

Sozialdarwinismus und Eugenik

Mit der zunehmenden Vereinnahmung der Lehre Darwins als Weltanschauung wird diese auch ein Ausgangspunkt für biologistisch begründete medizinische Interventionen im Sinne der Erbgesundheit, Rassenhygiene und Eugenik. Der ‚Sozialdarwinismus‘ fand in der Folge viele Anhänger. Der aus Österreich stammende und mit Ernst Haeckel befreundete Redakteur der Zeitschrift Das Ausland Friedrich Heller von Hellwald (1842-1892),sah im ‚Kampf ums Dasein‘ – in Verbindung mit dem im 19. Jahrhundert stark ausgeprägten Fortschrittsglauben – den Antrieb für eine positive Weiterentwicklung des Menschengeschlechts. Er übertrug in recht radikaler Weise das natürliche Selektionsprinzip auf das Handeln von Individuen und ganzen Völkern. Der englische Philosoph und Soziologe Herbert Spencer (1820-1903) brachte 1864 survival oft the fittest als ein am meisten zum sozialen Fortschritt und zur Verbesserung der Lebensbedingungen beitragendes Prinzip in die Diskussion ein.

Eine drastische Zuspitzung erfuhr der Sozialdarwinismus dann in der Eugenik, ein 1883 von Darwins Vetter, dem Anthropologen Francis Galton (1822–1911) geprägter Begriff, die im Deutschen (und zwar lange vor dem Nationalsozialismus) auch als ‚Erbgesundheitslehre‘ und ‚Rassenhygiene‘ bezeichnet wurde. Sie geht davon aus, dass ganz im Sinne der ‚Zuchtwahl‘ gutes Erbmaterial gefördert werden soll, hingegen schlechte Erbanlagen ausgemerzt werden sollten. Die Vorstellungen der Eugenik fanden vor allem in den Vereinigten Staaten, Deutschland, England, Kanada, Skandinavien, Schweiz, Japan und Russland eine große Anhängerschaft.

Auseinandersetzung zwischen Lamarckisten und Darwinisten

Der Darwinismus erlebte um die Wende vom 19. zum 20. Jahrhundert unter den Naturwissenschaftlern eine kritische Phase. Während die Vorstellung der Evolution an sich und die gemeinsame Abstammung aller Lebewesen weitgehende Akzeptanz fanden, blieb die des Selektionsmechanismus lange umstritten. Vor allem wurden Zweifel an der ausschließlichen Rolle des geschlechtlichen Selektionsmechanismus für den Fortschritt der Evolution laut und die auf den französischen Biologen Jean Baptiste de Lamarque (1744 - 1829) zurückgehende Auffassung einer Vererbung von während des Lebens erworbenen Eigenschaften gegenüber gestellt. (Darwin selbst hatte ja in späteren Jahren zugestanden, dass gewisse Anpassungen an die Umweltbedingungen womöglich auch vererbt würden.) Es entbrannte in der Folge eine Auseinandersetzung zwischen Neo-Lamarckisten und Neo-Darwinisten.

Die Synthetische Evolutionstheorie

verhalf schließlich der Darwinschen Selektion zum Durchbruch. Einer der Hauptvertreter dieser Theorie, der deutsch-amerikanische Biologe Ernst Walter Mayr, hat 1951 die grundlegenden Ideen Darwins als Summe von fünf Theoremen folgendermaßen zusammengefasst:

- Evolution als solche: Die Natur ist das Produkt langfristiger Veränderungen und ändert sich auch weiterhin; alle Organismen unterliegen einer Veränderung in der Zeit.

- Gemeinsame Abstammung: Jede Gruppe von Lebewesen stammt von einem gemeinsamen Vorfahren ab. Alle Organismen gehen auf einen gemeinsamen Ursprung des Lebens zurück.

- Vervielfachung der Arten: Die Arten vervielfachen sich, indem sie sich in Tochterspezies aufspalten oder indem sich durch räumliche Separation isolierte Gründerpopulationen zu neuen Arten entwickeln.

- Gradualismus: Evolutionärer Wandel findet in Form kleinster Schritte (graduell) statt und nicht durch das plötzliche Entstehen neuer Individuen, die dann eine neue Art darstellen. Natura non facit saltus!

- Natürliche Selektion: Evolutionärer Wandel vollzieht sich in jeder Generation durch eine überreiche Produktion an genetischen Variationen. Die relativ wenigen Individuen, die aufgrund ihrer besonders gut angepassten Kombination von vererbbaren Merkmalen überleben, bringen die nachfolgende Generation hervor.

Das Thema ‚Evolution‘ in der Gegenwart

Mittlerweile ist der Ansatz der ‚Synthetischen Evolutionstheorie‘ durch neue Erkenntnisse erweitert worden: Der molekularen Charakterisierung der Gesamtheit der vererbbaren Informationen einer Zelle im Genom wurde mit der Entdeckung der Funktionen, Strukturen und Wechselwirkungen von Chromosomen, Desoxyribonukleinsäuren (DNA) bzw. Ribonukleinsäuren (RNA) ein neuer Zugang eröffnet; neue Fachgebiete und Forschungszweige (wie Entwicklungs- und Systembiologie, Genomik und Epigenetik) sind seither entstanden, man beginnt nun erstmals Verhalten und Verhältnis aller Komponenten in ganzheitlich verstandenen lebendigen Systemen zu untersuchen.

Darwins Evolutionstheorie findet aber selbst am Beginn des 21. Jahrhunderts noch prominente Gegnerschaft. Nicht nur Islamisten, auch evangelikal-christliche Kreationisten berufen sich darauf, dass das ganze Universum, die Natur, das Leben und der Mensch nicht auf einen gemeinsamen Ursprung zurückgehen sondern durch den direkten Eingriff eines Schöpfergottes entstanden sein sollen. Als eine Alternative zu der auf dem Zufallsprinzip basierten Evolutionstheorie gilt für manche auch die Vorstellung eines intelligent design, wonach ein höheres Wesen das Leben erschaffen hat, das seitdem zwar einen langen Entwicklungsprozess durchlaufen hat, der aber von eben diesem höheren Wesen auch weiterhin gesteuert wird.

Dies mag damit zusammenhängen, dass es für viele Zeitgenossen eine zutiefst verstörende Erfahrung ist, dass der Mensch als erste Spezies mit den in der jüngsten Zeit entwickelten neuesten molekularbiologischen Methoden (Sequenzierung des Genoms, CRISPR und genome editing) in die Lage versetzt wurde, an der Basis seiner eigenen genetischen Ausstattung „gezielt“ zu manipulieren, wodurch wir uns gleichsam im neuen Zeitalter einer beschleunigten „akzelerierten Evolution“ befinden: Es ist nicht mehr alleine die gesamte Umwelt, die den Selektionsdruck (survival of the fittest) ausmacht, sondern der Mensch selbst tritt plötzlich in einer Art „Feedback-Schleife“ in den Mittelpunkt das Selektionsmechanismus. Er erhält erstmals die Möglichkeit in den Prozess der Evolution selbst aktiv einzugreifen, indem er mittels molekularbiologischer Methoden das Erbgut von Pflanzen, Tieren und Menschen verändert.

Es wird dabei nicht ausgeschlossen, dass auf diese Weise auch neue Arten entstehen könnten.

* Kurzfassung des Eröffnungsvortrags "Zur Darwin-Rezeption in Zentraleuropa 1860 – 1920", den Herbert Matis anlässlich des Ignaz-Lieben-Symposiums "Darwin in Zentraleuropa" (9. - 10. November 2017, Wien) gehalten hat. Die komplette Fassung (incl. Fußnoten) wird 2018 auf der homepage der Lieben-Gesellschaft http://www.i-l-g.at erscheinen.

Weiterführende Links

Darwin Publications: Books (American Museum of History, Darwin Manuscripts Project). open access.

Darwin online. Reproducing images from Darwin Online.

Gustav Jäger (1862): Die Darwinsche Theorie über die Entstehung der Arten. (PDF-Download)

Artikel zur Evolution von Organismen im ScienceBlog:

Im Themenschwerpunkt Evolution gibt es zahlreiche Artikel zu

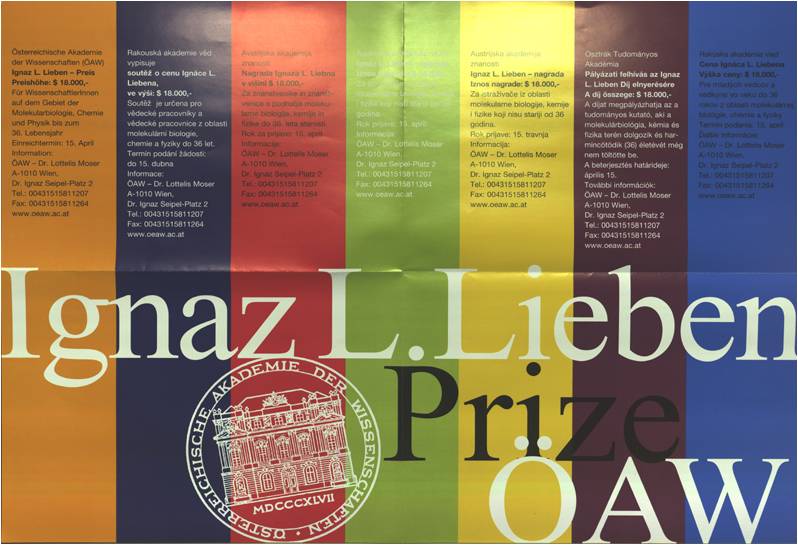

EU-Bürger, Industrien, Regierungen und die Europäische Union in SachenUmweltschutz - Ergebnisse der Special Eurobarometer 468 Umfrage (Teil 2)

EU-Bürger, Industrien, Regierungen und die Europäische Union in SachenUmweltschutz - Ergebnisse der Special Eurobarometer 468 Umfrage (Teil 2)Do, 23.11.2017 - 08:36 — Inge Schuster

![]() Über einen Teil der jüngst erschienenen Ergebnisse des Special Eurobarometer 486 - die Einstellung der EU-Bürger zu Umweltproblemen, ihr Wunsch die Umwelt zu schützen und dazu auch selbst beizutragen - wurde vergangene Woche berichtet. Weitere Aspekte der Umfrage, vor allem welche Rolle wer - Industrien, Regierungen und die EU selbst - im Umweltschutz spielen sollte, sind nun Gegenstand des gegenwärtigen Artikels. Dabei wird auch auf die Meinung der Österreicher Bezug genommen.

Über einen Teil der jüngst erschienenen Ergebnisse des Special Eurobarometer 486 - die Einstellung der EU-Bürger zu Umweltproblemen, ihr Wunsch die Umwelt zu schützen und dazu auch selbst beizutragen - wurde vergangene Woche berichtet. Weitere Aspekte der Umfrage, vor allem welche Rolle wer - Industrien, Regierungen und die EU selbst - im Umweltschutz spielen sollte, sind nun Gegenstand des gegenwärtigen Artikels. Dabei wird auch auf die Meinung der Österreicher Bezug genommen.

Die Generaldirektion Umwelt der Europäischen Kommission sieht ihr Ziel darin für gegenwärtige und künftige Generationen die Umwelt zu schützen, zu bewahren und zu verbessern. Um dies zu erreichen, schlägt sie Maßnahmen vor und führt solche ein, die ein hohes Maß an Umweltschutz und Sicherung der Lebensqualität von EU-Bürgern gewährleisten sollen; sie wacht auch darüber, dass die Umweltgesetze der EU von den Mitgliedstaaten eingehalten werden.

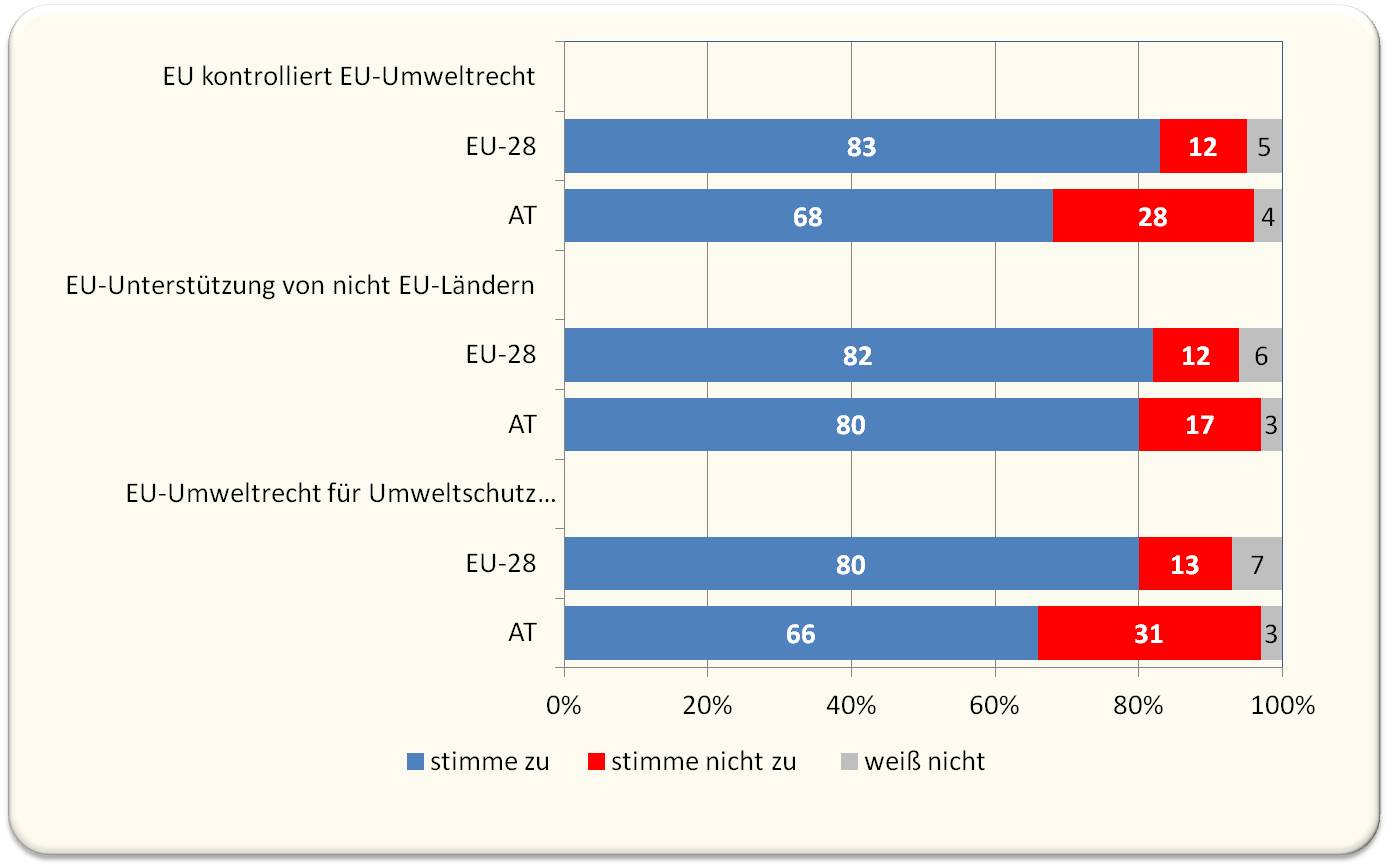

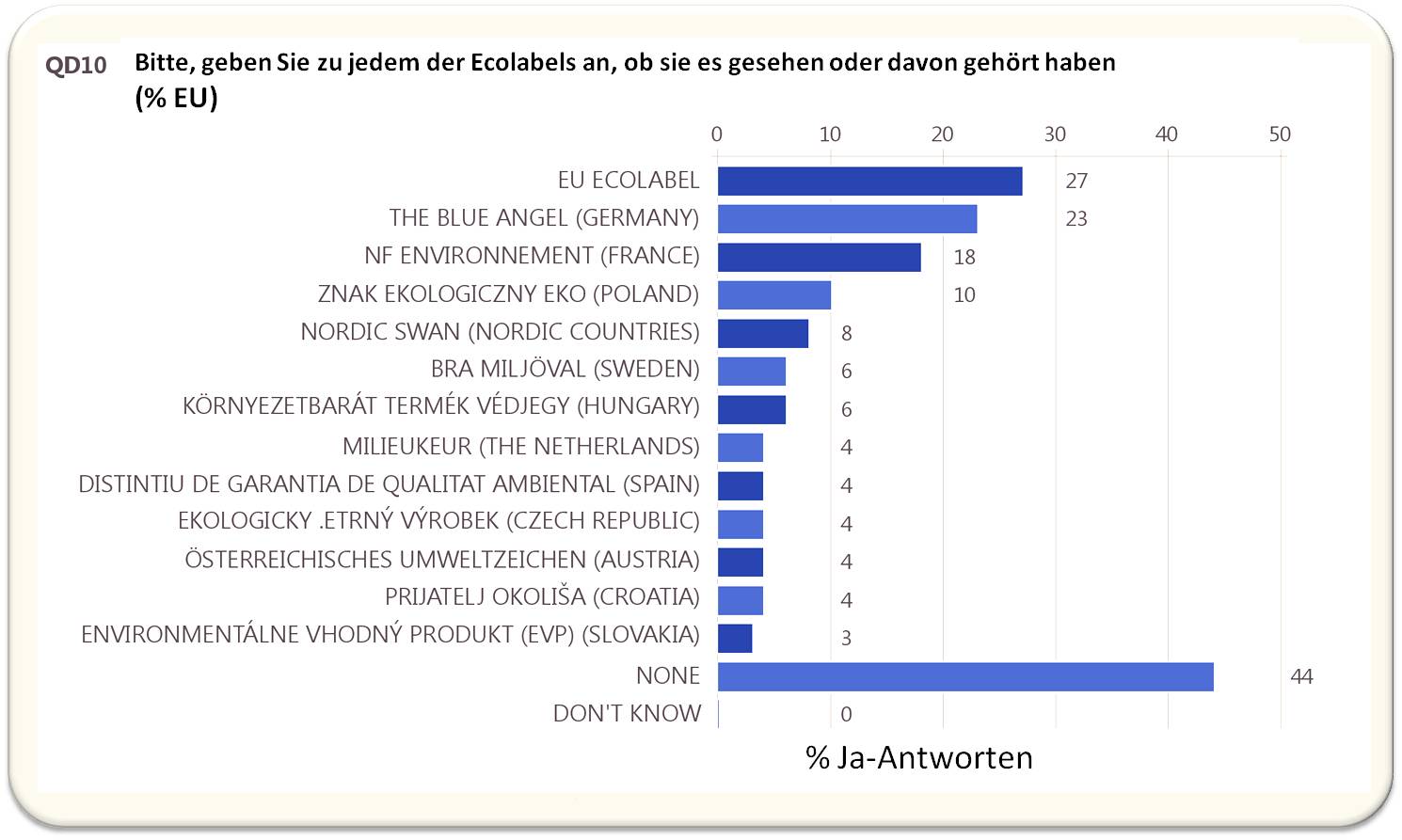

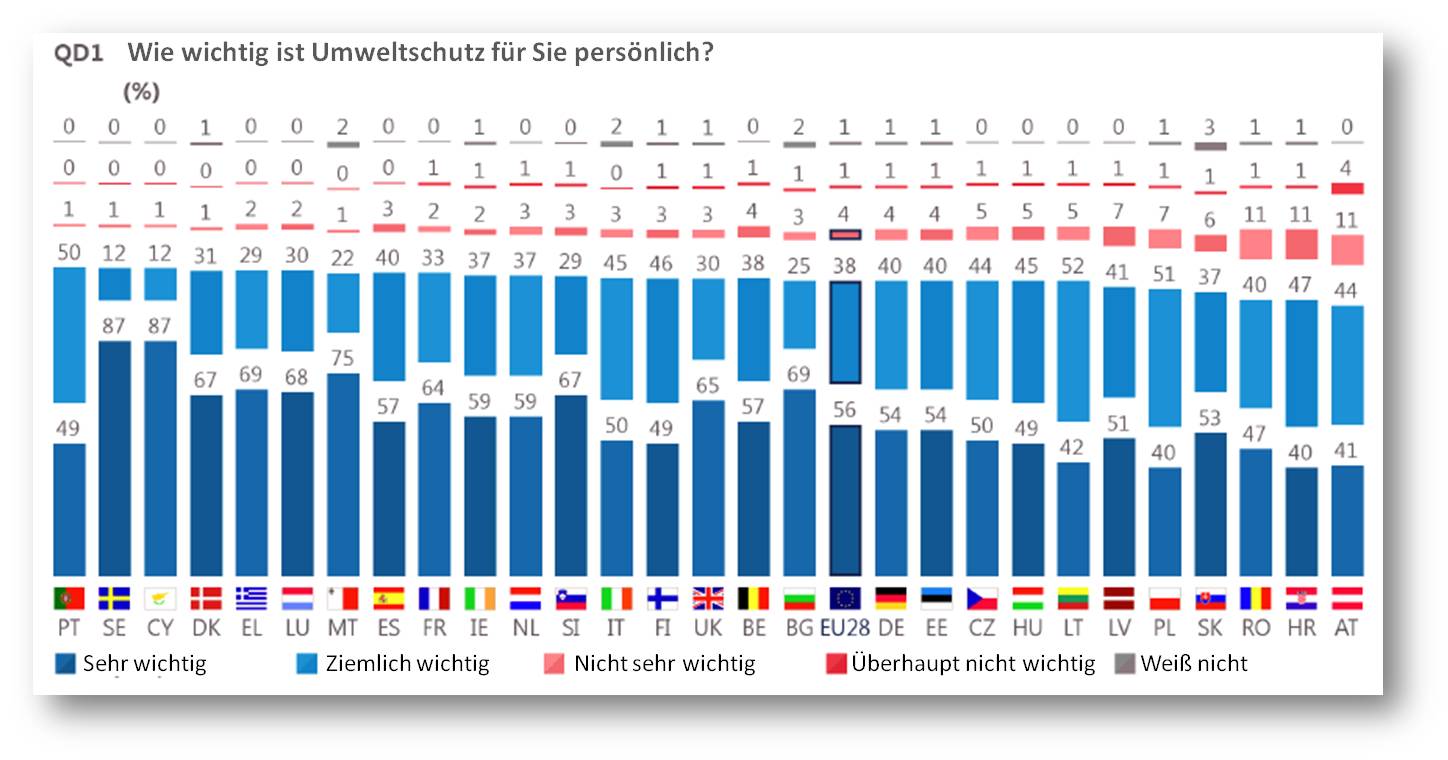

Wie sehen dies aber die EU-Bürger?

In regelmäßigen Abständen gibt die EU-Kommission dazu repräsentative Umfragen in Auftrag, wobei je Mitgliedsland persönliche (face to face) Interviews mit rund 1000 Personen ab 15 Jahren und aus unterschiedlichen sozialen und demographischen Gruppen, in ihrem Heim und in ihrer Muttersprache geführt werden. Aus dem jüngsten, vor knapp 2 Wochen erschienenen Bericht "Special EU-Barometer 468" [1] geht hervor, dass der Wunsch die Umwelt zu schützen bei den EU-Bürgern sehr breite Unterstützung findet, sie Maßnahmen dazu bejahen und bereit sind auch persönlich beizutragen. Darüber wurde vergangene Woche im ScienceBlog berichtet [2]. Weitere Aspekte der Umfrage, vor allem welche Rolle wer - Industrien, Regierungen und die EU selbst - im Umweltschutz spielt/spielen sollte, ist Gegenstand des gegenwärtigen Artikels.

Wie sehen die EU-Bürger das Verhalten von Industrie und Institutionen in Sachen Umweltschutz?

Hohe Einigkeit zeigten die EU-Bürger bei der Frage, ob große Umweltverschmutzer primär für die Schäden aufkommen sollten, die sie verursachen. Ähnlich wie schon bei der Umfrage im Jahr 2014 stimmten dem im EU-28 Mittel insgesamt 94 % zu (65 % volkommen, 29 % eher) und nur 4 % sprachen sich dagegen aus. Unter den Ländern stach Rumänien mit 11 % Ablehnung heraus.

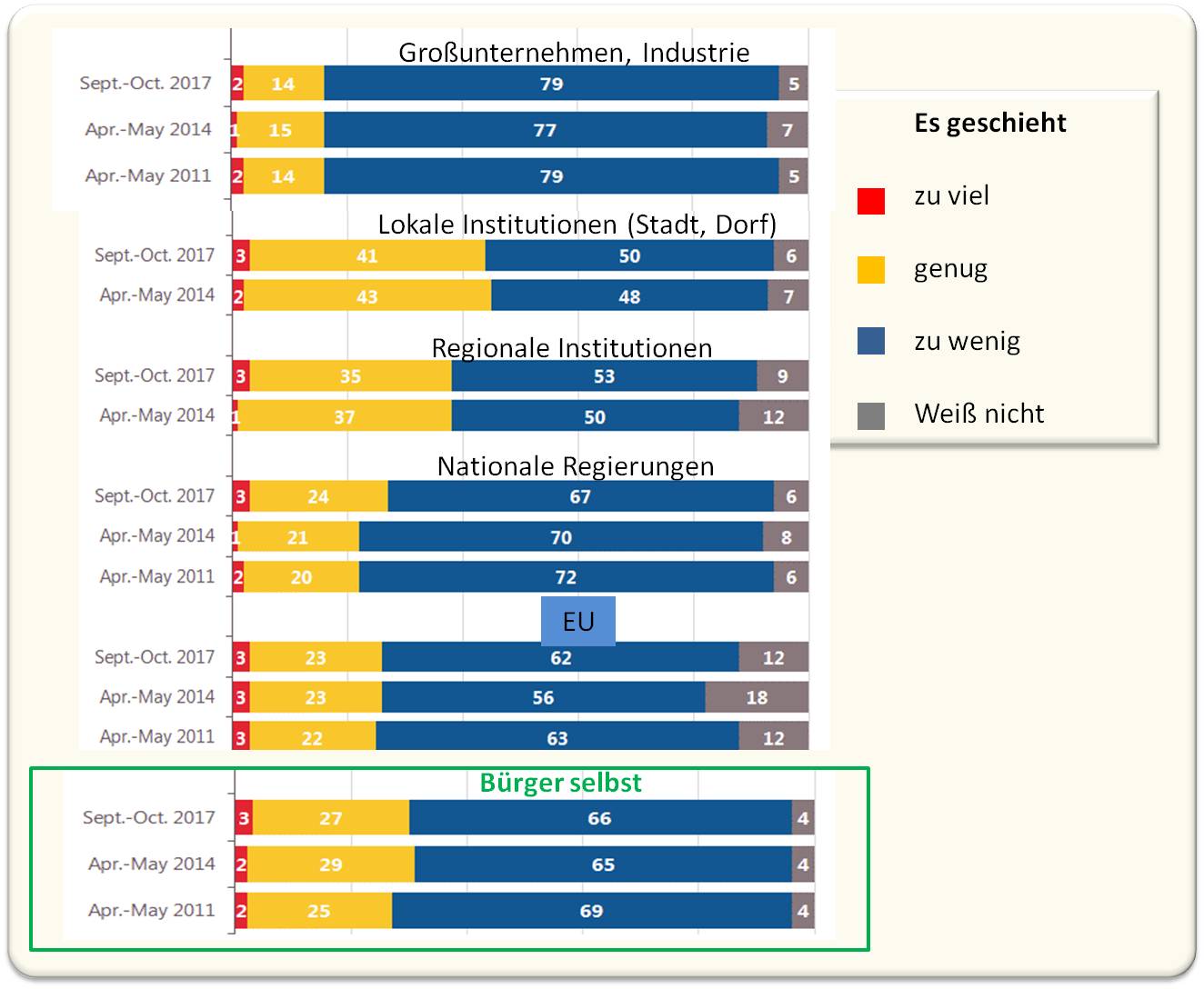

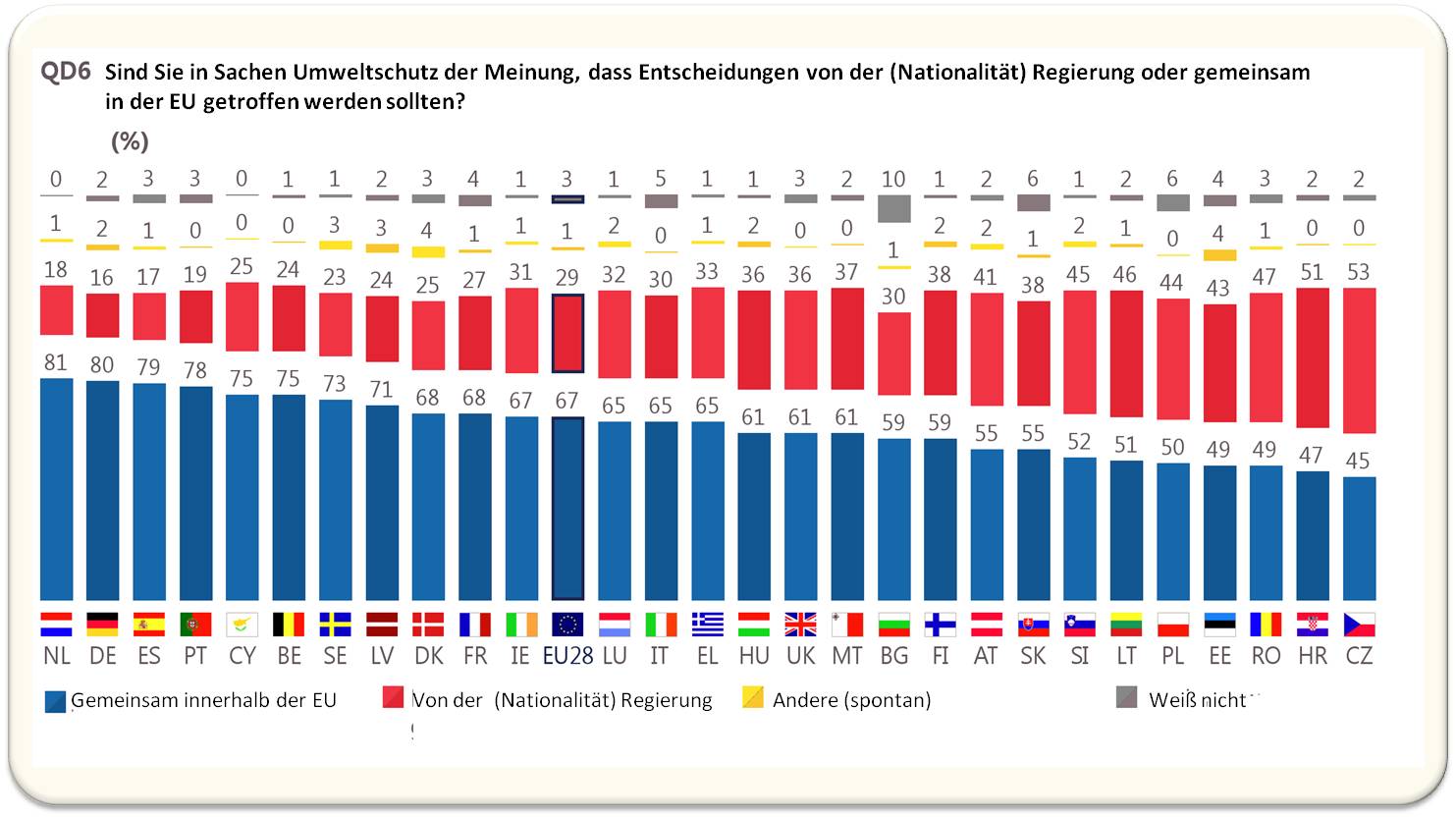

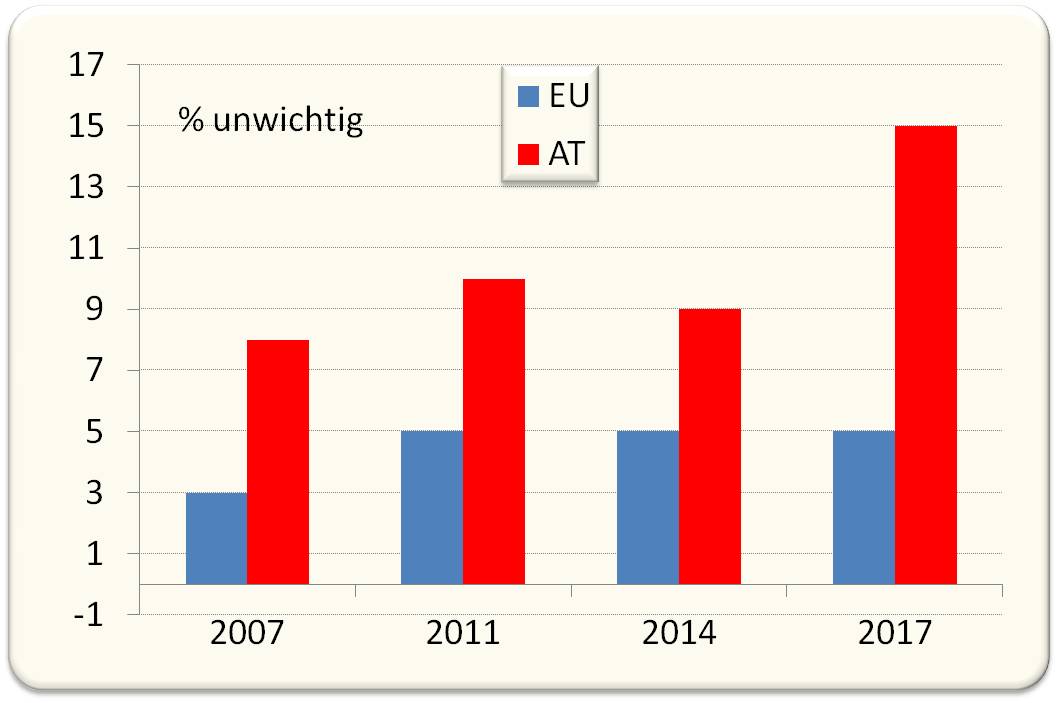

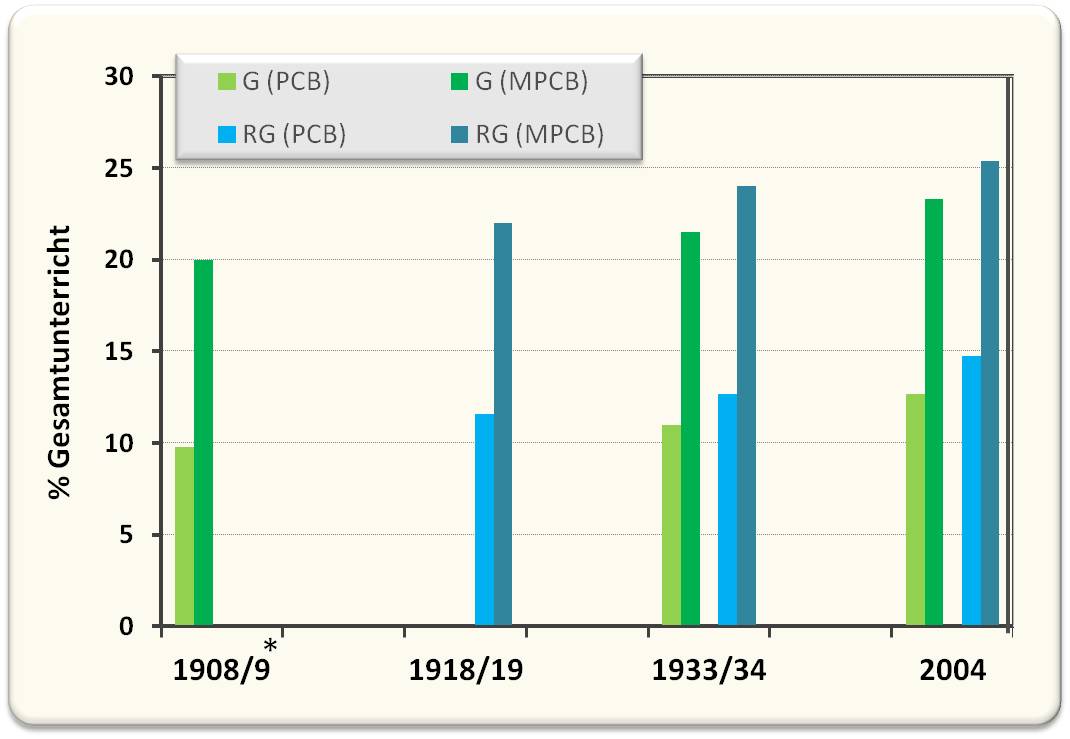

Auch auf die Frage ob Industrie, Institutionen oder die Bürger selbst genügend für den Umweltschutz machten, zeigte sich wenig Veränderung gegenüber früheren Umfragen. Abbildung 1.

Großunternehmen und Industrie wurden am schlechtesten beurteilt; im EU-28 Mittel gaben 4 von 5 Befragten an, dass dort zu wenig für die Umwelt getan würde. In einigen Ländern hatte sich die Einschätzung etwas gebessert - u.a. in Österreich um 8 Punkte auf insgesamt 24 % "zu viel/genug Umweltschutz" -, dafür in anderen Staaten wie UK, Holland oder Deutschland um mehrere Prozentpunkte verschlechtert. Am unteren Ende der Skala lag die Bewertung der Griechen, von denen nur 4 % meinten dass zu viel (1 %) oder ausreichend (3 %) getan würde.

Abbildung 1. Frage QD 7: Machen Ihrer Meinung nach die folgenden Akteure zu viel, genug oder zu wenig für den Umweltschutz[1].

Selbsteinschätzung der Bevölkerung: Auch hier fanden im EU-Mittel zwei Drittel der Befragten, dass nicht genügend für die Umwelt getan würde. Am Positivsten wurde die Situation in Deutschland, Tschechien und Österreich beurteilt (41 - 42 % gaben an "zu viel/genug Umweltschutz" zu betreiben), am Schlechtesten in Frankreich, Malta und Bulgarien (80 % urteilten "zu wenig Umweltschutz").

Institutionen. Rund zwei Drittel der EU-Bürger fanden, dass ihre jeweiligen Regierungen zu wenig für die Umwelt machten, ihre regionalen und lokalen Institutionen bewerteten sie dagegen besser. Dass die einzelnen Institutionen zu viel machten, fand nur ein kleiner Teil der Befragten. In den Bewertungen unterschieden sich die Länder stark.

- Lokale Institutionen: während 74 % der Griechen und 72 % der Bulgaren angaben, dass ihr Dorf, ihre Stadt nicht genug für die Umwelt machen würde, waren nur 29 % der Dänen, 30 % der Luxemburger und 31 % der Tschechen dieser Ansicht; in Deutschland waren dies 33 % und in Österreich 36 %.

- Regionaler Umweltschutz: diesen beurteilten Griechen (76 %) und Bulgaren (72 %) ähnlich schlecht wie den lokalen Umweltschutz. Dagegen fand zumindest die Hälfte der Befragten in Tschechien, Deutschland, Luxemburg, Dänemark und Österreich, dass zu viel/genug für die Umwelt geschehe.

- Nationale Regierungen: Am unzufriedensten mit dem Umweltschutz ihrer Regierungen waren wiederum die Griechen (88 %), dann folgten die Spanier (78 %) und Bulgaren (75 %), am wenigsten unzufrieden waren die Luxemburger (42 %), Dänen und Finnen (je 52 %). In Österreich hatte seit 2014 die Zufriedenheit um 16 % zugenommen.