2012

2012 Redaktion Wed, 20.03.2019 - 01:01Holzkonstruktionen werden berechenbar — Neue gestalterische Möglichkeiten im Ingenieurholzbau

Holzkonstruktionen werden berechenbar — Neue gestalterische Möglichkeiten im IngenieurholzbauDo, 20.12.2012 - 09:00 — Josef Eberhardsteiner

„Holz ist der größten und nötigsten Dinge eines in der Welt, des man bedarf und nicht entbehren kann.“ (Martin Luther, 1532). Seit den frühesten Epochen dient Holz als Baumaterial für die verschiedenartigsten Konstruktionen, seine mechanischen Eigenschaften werden allerdings auch heute noch überwiegend empirisch, in langwierigen Testreihen, ermittelt. Mikromechanische Modelle von Holz machen die Materialeigenschaften berechenbar und ermöglichen es, das volle architektonische und konstruktive Potential von Holz auszuschöpfen.

Holzwerkstoffe zur Herstellung von Strukturelementen gewinnen im Bauwesen zunehmend an Bedeutung. Der Verbrauch an Bauholz boomt nicht zuletzt auf Grund der offensichtlichen ökologischen Vorteile. Hinsichtlich des Holzvorrats liegt unser Land im europäischen Spitzenfeld (rund 48 % der Gesamtfläche sind bewaldet, davon etwa 54 % mit Fichten). Es wächst jährlich mehr Holz nach als geerntet wird und steht damit auch künftigen Generationen nachhaltig zur Verfügung (http://www.proholz.at/wald-holz/wald-in-zahlen/).

Den gestalterischen Möglichkeiten des Bauens mit Holz sind allerdings enge Grenzen gesetzt. Nach wie vor gehen die Bemessungskonzepte von Holzkonstruktionen, ebenso wie zahlreiche Bauvorschriften von einer rein empirischen, veralteten Basis aus, welche leider häufig unbefriedigende Resultate hinsichtlich der Effizienz und Sicherheit von Holzbaukonstruktionen liefert. Stark überdimensionierte Tragelemente aus Holz sind oftmals das Ergebnis.

Will man das volle architektonische und konstruktive Potential des überaus vielseitigen Werkstoffs Holz ausschöpfen und seine Verwendung für moderne, innovative Konstruktionen erleichtern, so bedarf es verlässlicher neuer Methoden zur Berechnung der Materialeigenschaften. Die rechnerischen Methoden sollten einerseits langwierige experimentelle Testreihen (zum Teil) ersetzen können und andererseits als Instrument zur Vorhersage und Optimierung der Materialeigenschaften von Holzwerkstoffen dienen.

Ein Beispiel für derartige neue Konstruktionen, welche durch komplexe zwei-und dreidimensionale Beanspruchungszustände charakterisiert sind, ist das in Abbildung 1 dargestellte „Metropol Parasol“, eine zwar ästhetisch anspruchsvolle, konstruktiv aber äußerst herausfordernde Holzkonstruktion.

Abbildung 1. Metropol Parasol: Das 2011 in der Altstadt von Sevilla fertiggestellte Bauwerk – sechs Riesen-Pilze (Architekt: Jürgen Mayer-Hermann) - gilt mit seinen Abmessungen von 150 x 70 m, einer Höhe von 26 m und insgesamt 3400 einzelnen Holzelementen als weltweit größte Holzkonstruktion. Das ursprüngliche Baukonzept erwies sich allerdings als undurchführbar und zog langwierige Untersuchungen zur Verbesserung der Materialeigenschaften nach sich, die zur Verlängerung der Bauzeit und Verdoppelung der Baukosten führten (aus: Wikipedia).

Abbildung 1. Metropol Parasol: Das 2011 in der Altstadt von Sevilla fertiggestellte Bauwerk – sechs Riesen-Pilze (Architekt: Jürgen Mayer-Hermann) - gilt mit seinen Abmessungen von 150 x 70 m, einer Höhe von 26 m und insgesamt 3400 einzelnen Holzelementen als weltweit größte Holzkonstruktion. Das ursprüngliche Baukonzept erwies sich allerdings als undurchführbar und zog langwierige Untersuchungen zur Verbesserung der Materialeigenschaften nach sich, die zur Verlängerung der Bauzeit und Verdoppelung der Baukosten führten (aus: Wikipedia).

Holz ist ein inhomogener Werkstoff

Holz ist ein natürliches Material mit einer sehr heterogenen Mikrostruktur; sein Aufbau ist artspezifisch und durch das Vorhandensein von Astansätzen, Änderungen im Faserverlauf und anderen Defekten und Wuchsunregelmäßigkeiten gekennzeichnet.

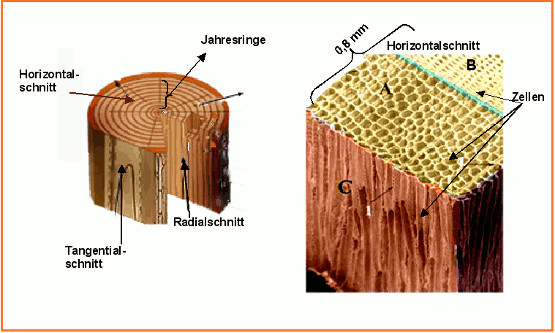

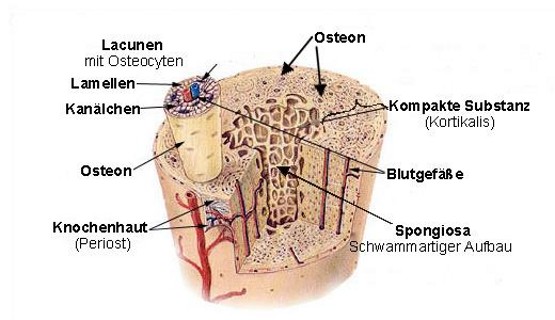

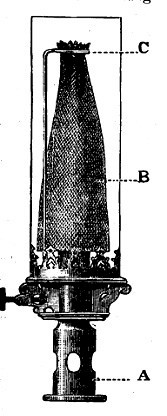

Alle Eigenschaften von Holz sind von seinem strukturellen Aufbau abhängig. Das mechanische Verhalten, beispielsweise Steifigkeit und Festigkeit, ist zudem stark anisotrop, d.h. von der Richtung der Beanspruchung – radial (R-Richtung), in Längsrichtung des Stammes (L-Richtung), tangential (T-Richtung) – abhängig und variabel. Die Heterogenität der Mikrostruktur ist in Abbildung 2 ersichtlich, die Richtungsabhängigkeit der mechanischen Eigenschaften wird daraus verständlich:

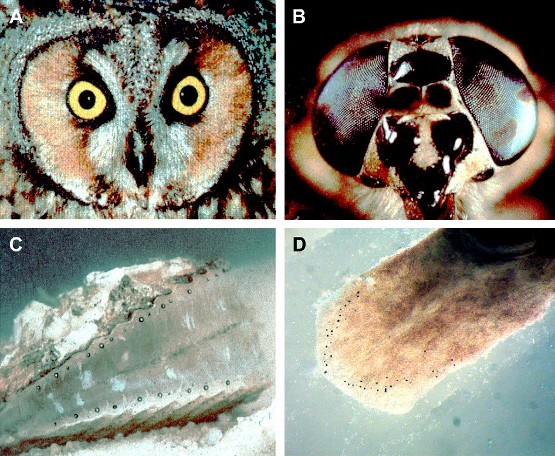

Die wabenartige Mikrostruktur von Holz setzt sich bis zu 95 % aus so genannten Tracheiden zusammen. Das sind längs zur Stammachse ausgerichtete Zellen mit einem radialen Querschnitt von 20–50 Mikrometer und einer Länge von 2–5 mm. Am Beginn der Wachstumsphase weisen die Zellen ein größeres Lumen und dünnere Zellwände auf (Frühholz); erstere dienen dem Wassertransport von der Wurzel in die Krone. Die Zellen im Spätholz haben ein kleineres Lumen und sind dickwandiger, mit einem höheren Anteil an Lignin in den Zellwänden; sie dienen überwiegend der Stützfunktion.

Abbildung 2. Makrostruktur (links) und Mikrostruktur (rechts) von Nadelholz: Die wabenartige Mikrostruktur aus so genannten Tracheiden zeigt Zellen mit größeren radialen Lumen im Frühholz (A) und kleineren Lumen im Spätholz (B). Die Zellen sind in Stammrichtung ausgerichtet (C) und ihre Länge übertrifft ihren radialen Durchmesser um rund zwei Größenordnungen. (Bild modifiziert nach http://www.vcbio.science.ru.nl/images/stemgrowth/woodanatomy-slide-03.jpg)

Abbildung 2. Makrostruktur (links) und Mikrostruktur (rechts) von Nadelholz: Die wabenartige Mikrostruktur aus so genannten Tracheiden zeigt Zellen mit größeren radialen Lumen im Frühholz (A) und kleineren Lumen im Spätholz (B). Die Zellen sind in Stammrichtung ausgerichtet (C) und ihre Länge übertrifft ihren radialen Durchmesser um rund zwei Größenordnungen. (Bild modifiziert nach http://www.vcbio.science.ru.nl/images/stemgrowth/woodanatomy-slide-03.jpg)

Wie können Materialeigenschaften von Holz berechenbar gemacht werden?

Gegenwärtige Konzepte in der Holzbautechnologie sind vielfach charakterisiert durch:

- Mangelhaftes Verständnis über das mechanische Verhalten von fehlerfreiem Holz und dessen Bezug zu den mikrostrukturellen Eigenschaften. Daraus resultiert eine unzureichende Kenntnis der Materialeigenschaften unterschiedlicher Holzarten und wie diese von holzspezifischen Parametern, wie beispielsweise Dichte und Feuchtigkeit, abhängen.

- Ungenügende Kenntnis darüber, wie sich Astansätze und andere „Defekte“ auf die mechanischen Eigenschaften von Holzwerkstoffen auswirken. Entsprechend werden dann im Bauwesen Holzstrukturelemente als weniger geeignet eingestuft und das Potential ihrer Anwendungsmöglichkeiten nicht voll ausgeschöpft./li>

- Vereinfachung und Vereinheitlichung der zu Grunde liegenden mechanischen Prozesse (beispielweise unterschiedliche Effekte bei Platten, Laminierungen, mechanischen Verbindungen). Da ein ausreichendes physikalisches Werkstoffverständnis und daraus resultierend ein umfassendes mechanisches Konzept fehlt, welches auf verschiedenste Holzkonstruktionen angewendet werden kann, werden aktuelle Modellierungsansätze vielfach von empirischen, experimentell bestimmten Parametern dominiert.

Unter Berücksichtigung dieser wichtigen Probleme verfolgt eine Forschergruppe am Institut für Mechanik der Werkstoffe und Strukturen (IMWS) der Technischen Universität Wien die Strategie mikrostrukturelle Charakteristika mit dem mechanischen Verhalten von fehlerfreiem und in weiterer Folge von „fehlerbehaftetem“ Holz zu verknüpfen. Auf dieser Basis werden Modelle für Holz, Holzprodukte und Strukturelemente erstellt, die praktisch auf alle Holzbaukonsturktionen anwendbar sind:

Diese Modelle gehen von einem Mehrskalenmodell aus, welches die mechanischen Eigenschaften von fehlerfreiem Holz beschreibt. Auf diesem Ansatz bauen weitere Berechnungskonzepte (3D-Finite Element Modelle) auf, welche (a) den Einfluss von Astansätzen und anderen Wuchsunregelmäßigkeiten berücksichtigen und zur Beschreibung von Holzprodukten dienen und (b) Modelle zur Analyse von Holzverbindungen, die die Geometrie der Verbindungen, ihre Belastbarkeit und Nachgiebigkeit sowie gegebenenfalls Verstärkungsmöglichkeiten charakterisieren. Ein dreidimensionales stochastisches numerisches Modell erlaubt die Vorhersage von Steifigkeits- und Festigkeitswerten von geschichteten Leimholzprodukten (Brettsperrholz, Brettschichtholz, u.a.) unter Berücksichtigung der unterschiedlich schwankenden mechanischen Eigenschaften der Einzellamellen.

Eine Beschreibung all dieser Modelle würde den Artikel weit über die im Blog übliche Länge ausdehnen. Im Folgenden soll deshalb nur das grundlegende Mehrskalen-Modell dargestellt werden. Detaillierte Information über alle Modelle ist in [1] nachzulesen.

Das Mehrskalen-Modell für Holz

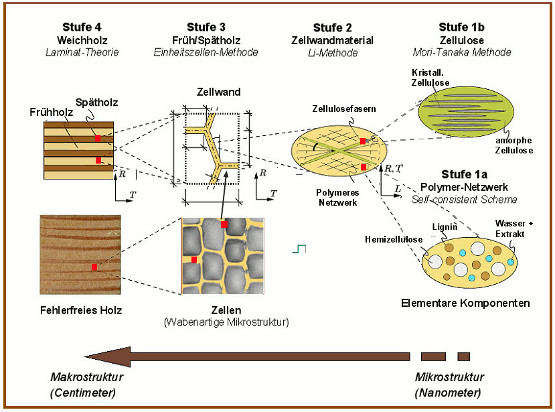

Abbildung 3. Holz ist hierarchisch aufgebaut: Das Mehrskalenmodell für fehlerfreies Holz geht schrittweise von der submikroskopischen Ebene aus und verwendet repräsentative Volumselemente (rote Quadrate) um die Eigenschaften der jeweils nächsten höheren Beobachtungsebene zu beschreiben und zu prognostizieren. Die elementaren Komponenten bestimmen die Strukturen der Zellwände, die Zellwände die mechanischen Eigenschaften der Zellen und diese die Eigenschaften des Werkstoffs Holz. Zur Wabenstruktur von Holz siehe Abbildung 2. (Zu den Methoden siehe [1])

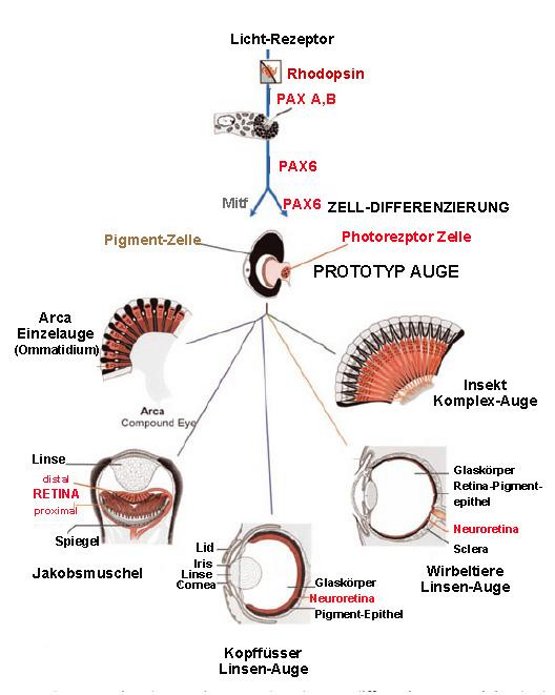

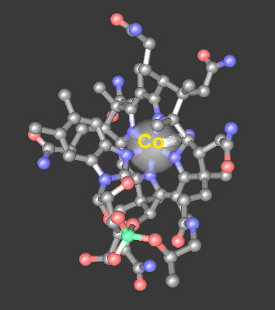

Wie bereits weiter oben beschrieben, besitzt Holz eine sehr heterogene Mikrostruktur, sein mechanisches Verhalten ist stark richtungsabhängig und variabel. Geht man allerdings zu sehr kleinen, submikroskopischen Dimensionen, werden hierarchische Bauprinzipien ersichtlich, und man findet universelle Komponenten, die allen Holzarten gemeinsam sind (Abbildung 3):

Diese elementaren biochemischen Komponenten – Zellulose, Hemizellulose, Lignin und in geringerem Ausmaß Extraktstoffe – bilden, vereinfacht dargestellt, ein Zellulosefaser-verstärktes, polymeres Netzwerk. Aus diesem sind in mehreren Schichten die Zellwände der in Stammrichtung verlaufenden Holzfasern aufgebaut. Zellulose liegt dabei zu größeren Struktureinheiten (Elementarfibrillen) gebündelt vor, diese wiederum (jeweils bis 2000 Zelluloseketten) sind zu fadenförmigen Mikrofasern zusammengefasst. Die Mikrofasern sind in eine Matrix aus Hemizellulose und Lignin eingebettet. Auf Grund der hygroskopischen Eigenschaften dieser Polymere ist auch Wasser in die Zellwände eingelagert.

Die Zusammensetzung aus diesen elementaren Komponenten, deren Strukturen und Verteilung innerhalb des mikroheterogenen Materials, ebenso wie die Wechselwirkungen, die sie aufeinander ausüben und die daraus resultierenden mechanischen Eigenschaften, bestimmen auch die mechanischen Eigenschaften auf der makroskopischen Ebene! Dementsprechend zielen rechnerische Ansätze darauf ab, eine Beziehung zwischen den mechanischen Eigenschaften auf (sub)mikroskopischen Ebenen und jenen auf der makroskopischen Ebene herzustellen. Auf der Basis seiner hierarchischen Struktur können hier für fehlerfreies Holz so genannte Mehrskalen-Modelle entwickelt werden:

Die Methode beruht darauf, dass in jeder Größenskala repräsentative Volumselemente oder Einheitszellen ausgewählt werden können, welche geeignet sind, die unterschiedlichen Mikrostrukturen in einer statistisch relevanten Art darzustellen. (Links zu den entsprechenden mikromechanischen Ansätzen – Mori-Tanaka-Methode, self-consistent scheme-Methode, Einheitszellen-Methode und Laminate-Theorie – sind in [1] zu finden.) Auf diese Weise wurden bereits Modelle für unterschiedliche Arten von Weichholz und Hartholz entwickelt, ebenso auch für Holz mit Pilzbefall und archäologisches Holz. In allen bisherigen Anwendungen haben Vergleiche mit experimentell, auf verschiedenen Größenskalen erhobenen Ergebnissen die Brauchbarkeit dieser Verfahren aufgezeigt, ebenso deren Potential, Holzeigenschaften ohne aufwändige Testreihen verlässlich prognostizieren zu können. Ein weiterer wesentlicher Vorteil der vorgestellten Methoden ist , erwünschte mechanische Eigenschaften auf der makroskopischen Ebene auf der Basis von mikroskopischen Änderungen definieren zu können.

Ausblick

Die Anwendung geeigneter rechnerischer Verfahren zur Charakterisierung von Holz, Holzprodukten und Holzverbundmaterialien liefert eine verbesserte Basis um mechanische Eigenschaften – wie Steifigkeit, Festigkeit, Belastbarkeit – von nicht experimentell getesteten Materialien verlässlich abschätzen und prognostizieren zu können. Die Etablierung derartiger Berechnungsmöglichkeiten, deren Relevanz durch experimentelle Untersuchungen bestätigt wurde, lässt hoffen, dass nicht nur ästhetisch anspruchsvolle und leistungsfähige Holzkonstruktionen verstärkt zum Einsatz gelangen, sondern – basierend auf zuverlässigen Technologien – sich auch innovative neue Betätigungsfelder im Ingenieur-Holzbau eröffnen.

[1] J. Füssl, T.K. Bader, J. Eberhardsteiner (2012) Computational mechanics for advanced timber engineering – from material modeling to structural applications. IACM Expressions 32/12, 6-11.

Anmerkungen der Redaktion

Holz-Struktur

"Structure of wood" (3:45 min) http://www.youtube.com/watch?v=E5GWBRMfF20&list=PL1815F6DBF74F31F0&index=17

Zum Holzbau

Wood in Education: Building a Strong Foundation (5:37 min) Inhabitat talks with Architect Jürgen Mayer H. about the Metropol Parasol (5:42 min) Zum Thema Mehrskalen-Analyse siehe auch den Artikel von Herbert Mang: »Multi-scale Analysen zur Prognose der Tragsicherheit von Bauwerken« im ScienceBlog

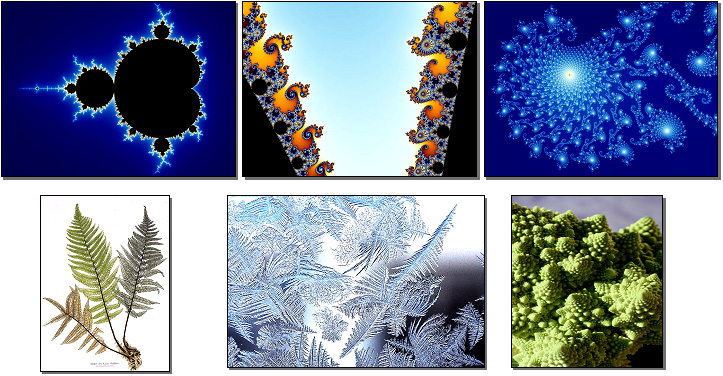

Multiskalenansätze zur Bewältigung von Komplexität in Natur- und Geisteswissenschaften

Stimmen der Nacht - Gedanken eines emeritierten Professors über Wissenschaft und Universitäten

Stimmen der Nacht - Gedanken eines emeritierten Professors über Wissenschaft und UniversitätenDo, 06.12.2012- 0:00 — Gottfried Schatz

Genügt es, wenn Professoren nur Fachwissen vermitteln? Sollten sie nicht vielmehr junge Menschen dazu ermuntern, unabhängig zu denken, sich von anerzogenen Vorurteilen zu befreien und Antworten auf die grossen Fragen zu finden - Fragen nach unserem Dasein und dem Wesen der materiellen und geistigen Welt? Gedanken eines Vermittlers von Wissenschaft par excellence, der auch hochkomplexe Zusammenhänge in einfachen, für Laien verständlichen Worten darzustellen vermag.

Seit Jahren bin ich emeritiert - ein Professor im Ruhestand. Ich habe kein Laboratorium, keine Mitarbeiter und keine Forschungsgelder mehr, muss aber auch nicht mehr sinnlose Formulare ausfüllen, Berichte für Schubladen schreiben und an unnötigen Sitzungen mit dem Schlaf kämpfen. Meine Freiheit ist mir noch immer nicht ganz geheuer. Sie macht jeden Tag zu einem Experiment, das Unerwartetes zutage fördern kann - über Wissenschaft, über meinen ehemaligen Beruf oder über mich selbst.

Zwischen Wachen und Träumen

Als frischgebackener Biochemiker war ich fast stets im Laboratorium und arbeitete bis spät in die Nacht - manchmal auch bis in den frühen Morgen. Die Stille des nächtlichen Laboratoriums schenkte meinen Gedanken freien Lauf und mir neue Ideen. Wenn ich jetzt nachts wach liege und meinen Erinnerungen nachgehe, vermisse ich diese Stille, denn die Stimmen der Nacht stören sie mit ihren Fragen. Die Stimmen sind unerbittlich und lassen sich nicht belügen. Ich versuche, ihnen zu widerstehen, doch sie kommen zur Stunde des Wolfs, wenn meine Gedanken im Niemandsland zwischen Wachen und Träumen wandern und meine Verteidigung versagt.

Immer wieder wollen die Stimmen wissen, was Wissenschaft mir gab. Es ist nicht leicht, darauf zu antworten, denn es gibt zu viele Antworten. Ich wollte Wissenschafter werden, um zu erfahren, wie die Welt um mich beschaffen ist. Bald jedoch erkannte ich, dass die wissenschaftliche Wahrheit von heute schon morgen falsch sein kann. Einer meiner Kollegen gestand dies in seiner Festrede für frischgebackene Doktoren mit folgenden Worten: «Wir haben unser Bestes getan, um Ihnen die neuesten Erkenntnisse der Wissenschaft beizubringen. Dennoch ist wahrscheinlich die Hälfte dessen, was wir Sie lehrten, falsch. Leider kann ich Ihnen nicht sagen, welche Hälfte.» Wissenschaft zeigte mir nicht die endgültige Wahrheit, sondern den Weg, um mich einer Wahrheit zu nähern. Ich erfuhr, dass sie nicht das Sammeln und Ordnen von Tatsachen ist, sondern der Glaube, dass wir die Welt durch Beobachten, Experimentieren und Nachdenken begreifen können. Wissenschaft zeigte mir auch die engen Grenzen des menschlichen Verstandes und lehrte mich Bescheidenheit. Arroganz, Hierarchie und Macht waren stets ihre Todfeinde.

Dennoch konnte mich Wissenschaft nie ganz befriedigen. Das Adagio aus Mahlers Zehnter Sinfonie, Shakespeares Sonette oder Cézannes Visionen des Mont Sainte-Victoire erzählten mir von einem verzauberten Land, das jenseits jeder Wissenschaft liegt. Erst dieses Land schenkte meiner Sicht der Welt einen zweiten Blickwinkel und damit die Dimension der Tiefe.

Und immer wieder die Frage, vor der ich mich fürchte: «Warst du ein guter Wissenschafter?» Nur allzu oft war ich es nicht, denn ich war nicht immer leidenschaftlich, mutig und geduldig genug. Wissenschaftlicher Erfolg entspringt nicht nur aus Intelligenz und Originalität, sondern auch vielen anderen Talenten. Die wichtigsten Voraussetzungen jedoch sind Leidenschaft, Mut und Geduld. Es braucht sie, um allgemein akzeptierte Ideen und Dogmen zu hinterfragen und ein schwieriges wissenschaftliches Problem zu lösen. Und es braucht sie auch, um trotz Fehl- und Rückschlägen ein Ziel über Jahre hindurch unbeirrt zu verfolgen.

Die Waffe der Wissenschaft ist Wissbegierde - doch diese Waffe ist stumpf ohne die Schärfe der Intelligenz. Aber selbst die schärfste Intelligenz ist kraftlos ohne Leidenschaft und Mut - und diese wiederum sind Strohfeuer ohne die Macht der Geduld. Und die Stimmen fragen weiter. «Hast du deinen Studenten und Mitarbeitern geholfen, leidenschaftlich, mutig und geduldig zu sein?» Hier schmerzt die Antwort: «Sicher nicht genug.» Ich glaube nicht, dass Leidenschaft sich lehren lässt, doch Mut und Geduld erstarken im Umgang mit mutigen und geduldigen Menschen. Darum versuchte ich, so gut ich konnte, meinen Mitarbeitern Mut und Geduld vorzuleben, denn persönliche Vorbilder sind für die Entwicklung junger Menschen von überragender Bedeutung. Sie sind die wichtigste Gabe, die eine Universität ihren Studenten geben kann. Wie schade, dass ich dies erst jetzt ganz erkenne.

Wissenschaft und Lehre

Und dann die Frage: «Was würdest du besser machen, wenn du nochmals beginnen könntest?» Hier fällt mir die Antwort leicht: «Ich würde die Lehre mindestens ebenso wichtig nehmen wie die Forschung.» Unter «Lehre» verstehe ich nicht die Aufzählung wissenschaftlicher Tatsachen, sondern die Weitergabe meiner wissenschaftlichen Erfahrungen und meiner persönlichen Ansichten über Wissenschaft, die Welt und uns Menschen. Professoren dürfen nicht nur Fachwissen vermitteln, sondern müssen junge Menschen dazu ermuntern, unabhängig zu denken, sich von anerzogenen Vorurteilen zu befreien und Antworten auf die grossen Fragen zu finden - Fragen nach unserem Dasein und dem Wesen der materiellen und geistigen Welt.

Alle jungen Menschen suchen Antworten auf diese Fragen, selbst wenn sie sich dessen nicht bewusst sind oder es nicht zugeben wollen. Und wenn unsere Bildungsstätten sie dabei im Stich lassen, werden sie bei Gurus und religiösen Fanatikern Rat suchen. Wie anders lässt es sich erklären, dass so viele Anhänger der berüchtigten Bhagwan-Sekte an den besten Universitäten der USA studiert hatten? Im Rückblick erscheint es mir fast unglaublich, dass Hunderte von begabten jungen Menschen mir bei meinen Vorlesungen über eine Stunde lang zuhörten. Welch einmalige Möglichkeit, diese jungen Menschen zu formen! Doch ich nutzte sie oft zu wenig, weil es mich zurück ins Laboratorium zog. «Was hat dich an der Wissenschaft überrascht?», fragt eine Stimme. Auch hier muss ich nicht lange nach der Antwort suchen. «Ich hatte einsames Forschen erwartet und nicht geahnt, wie sehr die Gemeinschaft mit anderen Wissenschaftern mein Leben prägen und bereichern würde.» Grosse wissenschaftliche Entdeckungen sind meist Kinder der Einsamkeit, werden aber dennoch nicht in Isolation geboren. Wir Wissenschafter arbeiten an einer Kathedrale, deren Vollendung keiner von uns erleben wird. Deshalb zehren wir doppelt von der Gemeinsamkeit unseres Schaffens.

Meine nächtlichen Besucher wollen vieles wissen und verstummen erst im Morgengrauen. Um mich gegen ihre Fragen besser zu wappnen, schreibe ich nun meine Antworten im Schutz des Tages nieder. Es sind Versuche - essais. Michel Eyquem de Montaigne sah seine «Essais» als Versuche, sich selbst zu erforschen. Vielleicht wollte aber auch er nur die Stimmen der Nacht besänftigen.

Anmerkung der Redaktion

Zum obigen Thema und über dieses hinaus gibt es in der Reihe „Sternstunde Philosophie“ ein rezentes (12.08.2012), großartiges Interview mit Gottfried Schatz: „Das Rätsel unserer Lebensenergie. Über Biochemie, Forschungsintrigen und Wissenschaftspolitik“ (55 min)

Schatz nimmt u.a. darin Stellung zu Themen wie: Arroganz und beschränkte Erkenntniskraft, Wahrheiten und Modelle in der Wissenschaft, Kultur und die Naturwissenschaften, Wissenschaft und Politik und Zukunft der Wissenschaft.

Zahlreiche weitere Artikel von Gottfried Schatz zu wissenschaftlichen und wissenschaftspolitischen Themen sind im ScienceBlog erschienen und unter der Rubrik „Einträge nach Autoren“ nachzulesen.

Homo ludens - Spieltheorie

Homo ludens - SpieltheorieDo, 29.11.2012- 04:20 — Karl Sigmund

Die Spieltheorie ist eine mathematische Disziplin, die sich direkt aus dem Spiel ableitet. Auf der Basis von Gesellschaftsspielen (wie z.B. Schach oder Poker) modelliert die Spieltheorie die sozialen/ökonomischen Wechselwirkungen zwischen den Mitspielern. Der Zufall kann dabei eine Rolle spielen, jedoch kommt ein weiteres Element der Ungewissheit hinzu: der Spielausgang hängt nicht nur von den eigenen Entscheidungen, sondern von anderen ab, die zumeist andere Interessen haben.

Spieltheorie ist die Theorie von Interessenskonflikten. Diese spielen bei sozialen, wirtschaftlichen oder militärischen Wechselwirkungen eine wesentliche Rolle; auch Recht und Moral dienen in erster Linie dazu mit Interessenskonflikten fertig zu werden.

Spieltheoretiker befassen sich zumeist nicht mit der Theorie von Brett- oder Kartenspielen. Sie verwenden nur die Sprechweise von Gesellschaftsspielen – Spiel, Spieler, Strategien, Auszahlung - um soziale Wechselwirkungen zu beschreiben.

- Die Wechselwirkung wird als Spiel bezeichnet,

- die Individuen heißen Spieler,

- diese müssen sich zwischen mehreren Alternativen (= Strategien) entscheiden und

- je nachdem, was die Spieler gewählt haben, fällt dann ihre Auszahlung aus (die keineswegs in Geld bestehen muss, aber ihre Präferenzen widerspiegelt: jeder möchte möglichst gut abschneiden).

Als Geburtstunde der Spieltheorie wird das Erscheinen des Buches von Oskar Morgenstern und John von Neumann angesehen, 1944: ‚Game Theory and Economic Behaviour‘ sollte ursprünglich ‚Theory of Rational Decisions‘ heißen, und wahrscheinlich wäre dann der Erfolg weniger fulminant gewesen. Das Buch begeisterte Journalisten, Politikberater und Militärs, vor allem aber junge Mathematiker wie etwa den genialen John Nash, der bald darauf die Spieltheorie auf neue Füße stellte, und dessen tragisches Leben durch den Film ‚A beautiful mind‘ einem großem Publikum bekannt wurde. Bald entdeckten auch Moralphilosophen, Ökonomen, und Verhaltensbiologen die Spieltheorie. Sie ist das Werkzeug par excellence des methodologischen Individualismus.

Im folgenden möchte ich einige Beispiele für typische spieltheoretische Gedankengänge bringen.

Beispiel 1: Schaden durch Eigennutz

Stellen Sie sich folgenden Versuch vor. Zwei Probanden (also Spieler A und B), die einander nicht kennen und nie sehen werden (und die das wissen) sitzen in zwei Kämmerchen. Jeder hat die Wahl zwischen zwei Alternativen (also Strategien) C und D: Wenn ich C wähle, muss ich dem Versuchsleiter 5 € zahlen, und der andere Spieler erhält (durch den Versuchsleiter) 15 €. Wenn ich D wähle, geschieht das nicht. Wir müssen unsere Entscheidungen – soll ich dem anderen Spieler etwas schenken oder nicht? - unabhängig voneinander treffen.

Abbildung 1. Das Gefangenendilemma.

Abbildung 1. Das Gefangenendilemma.

Es ist klar: wenn der andere C wählt, und ich auch, erhält jeder unterm Strich 10 € . Mehr erhielte ich, wenn ich das Geschenk des anderen nicht erwidere, also D spiele: dann bekomme ich 15 €. Also: wenn der andere C spielt, ist es für mich besser, D zu spielen. Wenn der andere D spielt, natürlich erst recht. Denn wenn ich C wähle, verliere ich 5 €, und wenn ich D spiele, nichts. Also ist es in jedem Fall besser, D zu spielen. Das gilt für den anderen genau so. Dann bekommen wir aber beide nichts. Jeder hat dann auf 10 € verzichtet – und zwar aus Eigennutz!

Das ist ein Beispiel für ein sogenanntes Gefangenendilemma (siehe unten). Das Paradoxon: durch Eigennutz schaden wir uns selbst!

Oft fasst man das Wirtschaftsleben auf als Unterfangen, wo jeder seinen eigenen Nutzen verfolgt, zum schließlichen Wohle aller. Laut Adam Smith harmonisiert eine ‚unsichtbare Hand‘ die eigennützigen Bemühungen der Wirtschaftstreibenden: dadurch, dass sie ihr eigenes Einkommen maximieren wollen, maximieren sie das Allgemeinwohl.

„Durch das Verfolgen der eigenen Interessen fördert der Mensch oft das Interesse der Gesellschaft wirksamer, als wenn er es wirklich fördern wollte... Der Mensch beabsichtigt nur den eigenen Vorteil, und er wird so wie durch eine unsichtbare Hand zu einem Ziel geführt, das er gar nicht beabsichtigt.“ (Adam Smith)

Und manchmal funktioniert das auch wirklich. Aber bei einem Sozialdilemma eben nicht! Da lässt sich mit Joseph Stiglitz sagen: ‚Die unsichtbare Hand ist unsichtbar, weil sie gar nicht da ist.‘

Nebstbei gesagt, der ‚Eigennutz‘ ist nicht notwendigerweise Egoismus, Präferenzen müssen nicht selbstsüchtig sein. Mir könnte es beispielsweise ausschließlich um das Wohl von Seehundbabys gehen. Trotzdem, solange ich und mein Spielpartner verschiedene Präferenzen haben, können wir uns in so einer sozialen Falle verfangen.

Es gibt tausende von wissenschaftlichen Artikeln und eine ganze Reihe von Büchern über das Gefangenendilemma! Es taucht immer dort auf, wo zwei Personen zusammenarbeiten. Sobald es möglich ist, den Beitrag des anderen auszubeuten, oder den eigenen Beitrag auf Kosten anderer zu verringern, können wir in eine soziale Falle tappen. Anscheinend sind Menschen aber besonders befähigt, sich daraus zu befreien. Wir kooperieren oft mit Erfolg, ohne immer zu wissen, wieso. Wenn man zum Beispiel ein Bild des anderen sieht, steigt die Bereitschaft, dem etwas zu schenken, umso mehr, als der uns ähnlich sieht (selbst wenn uns diese Ähnlichkeit gar nicht auffällt!). Man kann im Experiment das Bild des anderen digital manipulieren und damit auch die Bereitschaft, zu schenken.

Beispiel 2: Das Ultimatum-Spiel - Homo oeconomicus

Dieses Experiment erfordert wieder einen Spielleiter und zwei Spieler, die einander nicht kennen, nicht einmal sehen, und die wissen, dass sie einander nach dem Spiel nie wieder begegnen werden. Der Spielleiter verkündet, dass er 10 € unter die zwei Spieler aufteilen wird, unter den folgenden Bedingungen:

- Zuerst entscheidet ein Münzwurf, wer von den zwei Spielern der Bieter ist.

- Dann darf der Bieter (hier A) einen Vorschlag machen, wie die 10 € aufgeteilt werden.

- Wenn der andere (hier B) zustimmt, wird das auch so gemacht, und das Spiel ist zu Ende.

- Wenn aber der andere ablehnt, ist das Spiel ebenfalls zu Ende. Denn dann nimmt der Spielleiter die 10 € wieder an sich, und die beiden Spieler gehen ihrer getrennten Wege, ohne irgend etwas bekommen zu haben. Es gibt kein Feilschen, keine zweite Runde; sondern nur ein Angebot, das akzeptiert oder verworfen werden muss. Ein Ultimatum halt! Gespielt wird um echtes Geld.

Wie würden Sie sich entscheiden, in der Rolle des Bieters oder des anderen?  Abbildung 2. Entscheidungsbaum für den Homo oeconomicus

Abbildung 2. Entscheidungsbaum für den Homo oeconomicus

Ist der andere rational, sollte er jedes (positive) Angebot annehmen, auch wenn es noch so gering ist – ein Euro ist besser als keiner. Im Hinblick darauf sollte ein rationaler Bieter dem anderen einen Minimalbetrag anbieten, hier etwa 1 €, und sich den Rest behalten. So sollte der sogenannte Homo oeconomicus handeln, zumindest wenn er glaubt, seinesgleichen zum Partner zu haben. In Wirklichkeit geschieht das fast nie! Der weitaus überwiegende Teil der Angebote beträgt 4 oder 5 €, also die Hälfte der Summe oder knapp darunter. Nur ganz wenige Angebote betragen 2 € oder weniger. Solche ‚unfairen‘ Angebote werden fast ausnahmslos empört abgelehnt. Die meisten Spieler bestehen auf einer ‚fairen‘ Lösung, also einer Aufteilung zu etwa gleichen Teilen.

Das Spiel ist an vielen Orten wiederholt worden (Tokio, Ljubljana, Chicago, Zürich…), die Resultate sind zumeist ganz ähnlich. Die Stadtmenschen sind in dieser Beziehung überall gleich. Aber dann hat man dieses Spiel in sogenannten small-scale societies durchgeführt, also etwa bei den Machiguenga (Jägern und Sammlern aus dem Amazonasbecken), den Hazda (einem Hirtenvolk aus Kenia), den Lamalera (Fischern in Indonesien). kulturelle bedingte Unterschiede. Die Jäger und Sammler sind am ‚unfairsten‘ (aber immer noch viel weniger unfair als der fiktive Homo oeconomicus: sie bieten im Mittel etwa ein Viertel der Gesamtsumme). Die Lamalera sind dagegen hyperfair, sie bieten mehr als die Hälfte (und lehnen übrigens solche Angebote meist ab: das hängt mit ihrer Geschenkkultur zusammen). Am ‚fairsten‘ sind Gruppen aus modernen Großstädten wie Los Angeles oder Chicago.

Beispiel 3: Solidarität, Trittbrettfahrer und institutionelle Bestrafung

In einer Gruppe von, sagen wir, 6 Spielern kann jeder einen gewissen Betrag in eine Gemeinschaftskasse einzahlen, sagen wir 20 €, wissend, dass der vom Versuchsleiter verdoppelt wird, und dann auf alle Teilnehmer gleichmäßig aufgeteilt. Auf alle, egal, ob die eingezahlt haben oder nicht! Die Gemeinschaftskasse ist ein öffentliches Gut, in dem Sinn. Jeder hat daran teil.

Wenn alle brav einzahlen, bekommt jeder doppelte heraus. Das ist gut! Ich gewinne 20 €. Aber noch besser scheint es, ein sogenannter Trittbrettfahrer oder Schwarzfahrer zu sein. Wenn die fünf anderen 20 € einzahlen und ich nichts, gewinne ich 33€! Freilich, wenn alle schwarzfahren, also nichts einzahlen, dann erhält keiner was. Wieder so eine soziale Falle!

Klar ist: Schwarzfahrer gehören bestraft. Denn wenn sie eine Strafe zahlen müssen, werden sie keinen Anreiz haben, schwarz zu fahren, also das öffentliche Gut auszubeuten. Ein Kontrollor gehört her! Aber stellen wir uns vor, dass so eine schwarzkäpplerische Obrigkeit nicht existiert, also Anarchie herrscht. Was dann?

Nun, dann sollten wir die Missetäter selbst bestrafen. Aber das kostet uns etwas (Zeit und Aufwand, und das Risiko, dass sich der Schwarzfahrer rächt…). Im Experiment dürfen jetzt die Spieler die Ausbeuter bestrafen, aber das kostet sie etwas! Das Bestrafen wirkt, und verhindert das Schwarzfahren. Aber in Anbetracht der Kosten ist es besser, wenn ich es den anderen überlasse, die Schwarzfahrer bestrafen, und damit dafür zu sorgen, dass das öffentliche Gut nutzbar ist. Was ich dann aber mache, ist nichts anderes als Trittbrettfahren zweiter Ordnung! Wieder nutze ich andere aus!

Kann sich in so einer Situation das Bestrafen von Missetätern durchsetzen?

Strategien – Computersimulation [1,2]

Es gibt zahlreiche Möglichkeiten, sich diesem Problem zu nähern. Ich möchte aus Zeitgründen nur einen Weg einschlagen, der dem Mathematiker besonders liegt, nämlich dem der Computersimulation, also ein rechnergestütztes Gedankenexperiment. Nehmen wir an, wir haben eine fiktive Population von (sagen wir) hundert Spielern. Jeder hat eine Strategie. Unsere Spieler sind also Roboter, jeder mit einem Verhaltensprogramm.

Zur Wahl stehen drei Strategien:

(a) zum öffentlichen Gut beizutragen, und Schwarzfahrer zu bestrafen;

(b) beizutragen, aber Schwarzfahrer nicht zu bestrafen (das sind die Trittbrettfahrer zweiter Ordnung;

(c) nicht beizutragen, und die anderen auszubeuten.

Von Zeit zu Zeit werden sechs Spieler zufällig ausgewählt aus der hundertköpfigen Roboterpopulation, um dieses Spiel gemäß ihrer Strategie zu spielen. Von Zeit zu Zeit können sie auch Strategie wechseln, und zwar, wie wir naheliegender weise annehmen wollen, eher zu einer Strategie mit höherer als mit geringerer Auszahlung. Ein simpler Lernprozess.

Die Auszahlung hängt natürlich davon ab, was die anderen in der Gruppe machen, hängt also von der Zusammensetzung der Bevölkerung ab; die Zusammensetzung wiederum hängt von den Auszahlungen ab, auf Grund des Lernprozesses; also ein Rückkoppelungskreis, wie bei einer Katze, die mit dem eigenen Schweif spielt.

Was passiert, ist unausweichlich. Die Neigung, Ausbeuter zu bestrafen, verschwindet, denn sie ist kostspielig. Die ungebremsten Ausbeuter übernehmen die Gesellschaft, und bald gibt es keine Kooperation mehr. Das soziale Dilemma (oder: die Tragödie der Allmende) hat voll zugeschlagen. Führen wir aber jetzt eine weitere, vierte Strategie ein. Nämlich

d) an dem gemeinsamen Unternehmen gar nicht teilzunehmen.

Dieses Unternehmen ist ja eine Spekulation; eine, die aufgeht, wenn alle kooperieren, aber fehlschlägt, wenn viele schwarzfahren. Es kann sein, dass risiko-scheue Spieler sich lieber nicht auf so eine Spekulation einlassen wollen. Dann tragen sie weder zur Gemeinschaftsleistung bei, noch nehmen sie diese in Anspruch. Was passiert jetzt?

Nun, erstaunlicherweise setzen sich jetzt, nach einer gewissen Lernphase, die Bestrafer durch, und die Bevölkerung kooperiert. Wohlgemerkt: es sind nicht die Eigenbrötler, die sich durchsetzen; aber sie wirken als Katalysatoren für die Emergenz der Zusammenarbeit.

Das war nur ein Computermodell. Wir können jetzt Varianten untersuchen. Zum Beispiel, dass die Spieler nicht auf eigene Faust bestrafen, sich also gewissermaßen persönlich rächen, sondern in einen Fonds einzahlen, der eine Obrigkeit (einen Sheriff, vielleicht) finanziert. Wieder sehen wir dasselbe. Wenn die Spieler am Spiel teilnehmen müssen, dann erlischt die Zusammenarbeit. Wenn die Teilnahme freiwillig ist, also Eigenbrötler vorkommen dürfen, dann setzt sich die Zusammenarbeit durch.

Dazu bedarf es bemerkenswerterweise gar keiner philosophischer Überlegungen und politischer Vereinbarungen, keiner höheren Offenbarung oder tieferen Einsicht. Bloßes Nachäffen erfolgreicher Verhaltensweisen führt schon zu dem Resultat. Andere Tierarten, wie etwa Bienen und Ameisen, kooperieren auch, aber nur innerhalb ihrer Familie (also des Bienenstocks, oder des Ameisenhaufens). Wir Menschen aber kooperieren auch mit Nichtverwandten, und das auf Grund zweier zusammengehöriger ‚Erfindungen‘ der Evolution, die unserer Spezies vorbehalten waren: einerseits Institutionen, die uns von außen, andrerseits Tugenden, die uns von innen steuern (und die ich aus Zeitmangel heute außer Acht lassen muss).

Spielen mit Gesellschaften - Die freiwillige Festlegung gehört zum Spiel

Unsere Computersimulationen sind Spiele mit fiktiven Gesellschaften. Von den Gesellschaftsspielen sind wir also zum Spielen mit Gesellschaften gelangt. Natürlich kann es bei derlei computergestützten Gedankenexperimenten nicht bleiben: alle Schlussfolgerungen müssen in wirklichen Gesellschaften getestet werden.

An der Wirklichkeit haben wir uns zu messen, und das liefert ein Riesen-Programm für historische, soziologische, anthropologische, psychologische und neurologische Untersuchungen!

Jedenfalls versprechen diese spieltheoretischen Modelle einige Einsicht. In unserem dritten Beispiel die Einsicht: Damit die Gemeinschaft trotz Sozialdilemma kooperiert, muss auf Ausbeutung Strafe stehen, wir müssen uns also einem Zwang unterwerfen. Aber das klappt besser, wenn das Unterwerfen freiwillig erfolgt, wir uns also freiwillig entscheiden, einander gegenseitig zu zwingen, zu kooperieren.

Was doch stark an den Sozialkontrakt erinnert! Der erste Satz in Jean Jacques Rousseaus Büchlein lautet: ‚Der Mensch wird frei geboren, und überall liegen die Menschen in Ketten‘. Das wird oft falsch übersetzt, mit ‚aber‘ statt ‚und‘, so als gäbe es eine Opposition zwischen den beiden Halbsätzen. Unsere simplen spieltheoretischen Modelle zeigen, dass dem nicht so ist. Sondern vielmehr: gerade weil wir uns frei entscheiden können für die Teilnahme, gerade weil der Ausweg des Eigenbrötlers offen steht, bleibt es profitabel, uns Zwängen zu unterwerfen. Wir legen uns fest. Die freiwillige Festlegung gehört zum Spiel.

Wir legen uns in Ketten, oder weniger pathetisch: wir zähmen uns gewissermaßen selbst. Haustiere, wie etwa Rinder und Schweine, haben wir erst im Lauf der letzten Jahrtausende domestiziert, Hunde (also Wölfe) seit höchstens hundert tausend Jahren, uns selbst vielleicht viel länger. Nicht homo homini lupus, sondern homo homini canes sollte es heißen!

Konrad Lorenz hat diese Idee der Selbstdomestikation diskutiert, leider in einer Arbeit, die er schrieb, als er einigermaßen infiziert war von nationalsozialistischem Gedankengut. Lorenz spricht von der Verhausschweinung des Menschen im denkbar abschätzigen Ton, und insinuiert einen Widerspruch zu den edlen Wilden, oder blonden Bestien, und ähnlicher Tarzan-Romantik! Das ist wohl Unsinn.

An der Selbstdomestikation ist aber etwas dran. Sie führt nicht, wie Lorenz glaubte, zu moralischem Verfall sondern im Gegenteil zur Ausbildung unserer Anlagen zu ethischen Normen und wechselseitiger Erziehung. Schon vor 200 Jahren hat der Zoologe Blumenthal, ein Lehrer Schopenhauers und Fakultätskollege von Gauss, den Menschen als das ‚vollkommenste aller Haustiere‘ bezeichnet.

Die Selbstzähmung des Menschen, im Sinn eines Sozialkontrakts, ist keine Entartung, sondern Ausgangspunkt seines unerhörten stammesgeschichtlichen Erfolgs. Zur Selbstzähmung gehört die menschliche Bereitschaft, freiwillig Regeln zu folgen: genau das ist es aber, was beim Spielen geschieht.

Wichtigste Funktion des Spieltriebs, beim Menschen, ist also vielleicht nicht, dass er dadurch seine Umgebung spielerisch erkundet, oder seinen Bewegungsapparat spielerisch trainiert, sondern dass er spielerisch lernt, mit Verhaltensregeln zu experimentieren. Dass er bei dieser fürs menschliche Überleben so wesentlichen Tätigkeit großen verspürt, verrät die Handschrift der natürlichen Auslese.

Die freiwillige Festlegung auf Regeln macht nicht nur das Spielen möglich, sondern ermöglicht die Kooperation, also das Gesellschaftswesen Mensch – den Homo ludens.

Einzelnachweise und Quellen

[1] Karl Sigmund, et al., (2010), Social learning promotes institutions for governing the commons. Nature 466:861-863

[2] T Sasaki, A Braennström, U Dieckmann, and K Sigmund (2012) The take-it-or-leave-it option allows small penalties to overcome social dilemmas. ProcNat AcadSci 109: 1165-69

Anmerkungen der Redaktion

Dieser Text entstand auf der Basis eines Referats mit dem Titel „Homo ludens: Offenheit, Wahrscheinlichkeit, Festlegung“, das am 27. September in der Österreichischen Akademie der Wissenschaften gehalten wurde. Der erste Teil des Referats ist unter dem Titel: „Homo ludens - Spiel und Wissenschaft“ am 15. November hier im Science-Blog erschienen.

Gefangenendilemma: die Interaktion zwischen zwei Spielern wurde erstmals - der Anschaulichkeit halber - durch zwei schuldige, räumlich getrennte Untersuchungshäftlinge dargestellt, die vor die Wahl gestellt werden zu leugnen oder zu gestehen. Kooperieren (= beide leugnen) bringt das beste Gesamtergebnis, für den Einzelnen ist es am sichersten zu gestehen. Die Bezeichnung Gefangenendilemma wird seitdem für alle „Spiele“ unter denselben Rahmenbedingungen (Interaktion zwischen 2 Spielern, 2 Strategien, ohne Möglichkeit der Absprache, symmetrische Auszahlung) angewandt.

Eine sehr gute Darstellung: „Das Gefangenendilemma als Paradigma von Kooperation - ZEIT Akademie Philosophie“ , 7:45 min

Weiterführende Links

Evolutionäre Spieltheorie. Von Gesellschaftsspielen zum Spielen mit Gesellschaften. (PDF-Download)

im Science-Blog:

Karl Sigmund Die Evolution der Kooperation

Karl Sigmund : Homo ludens - Spiel und Wissenschaft

Peter Schuster: Die Tragödie des Gemeinguts

Erkrankungen des Bindegewebes: Fibrose – eine häufige Komplikation bei Implantaten.

Erkrankungen des Bindegewebes: Fibrose – eine häufige Komplikation bei Implantaten.Do, 22.11.2012- 04:20 — Georg Wick

Unser Organismus reagiert auf ein Implantat, indem er um diesen Fremdkörper eine zarte und weiche Kapsel aus Bindegewebe aufbaut und ihn damit im umgebenden Gewebe verankert. Allerdings kann daraus in Folge einer verstärkten Körperreaktion eine exzessive, krankhafte Vermehrung und Verhärtung des Bindegewebes – eine sogenannte ›Fibrose‹ – entstehen. Die Grundlagen für die Entstehung und Entwicklung derartiger Fibrosen werden hier am Beispiel der relativ häufig an Silikon-Brustimplantaten auftretenden Komplikation „Kapselfibrose“ aufgezeigt.

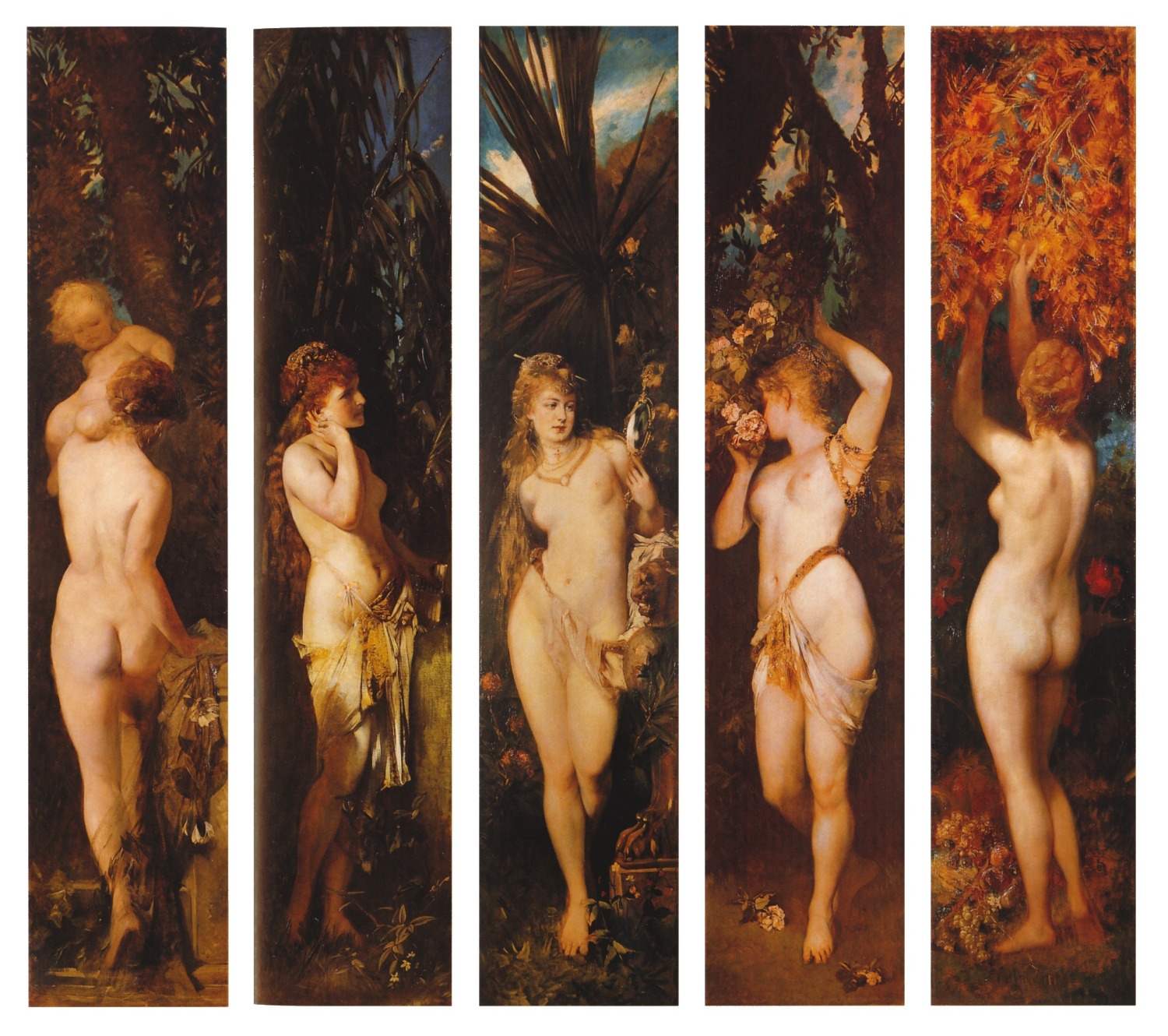

Der Wunsch nach Schönheit und „ewiger Jugend“ hat in unserer Zeit einen Boom in der plastischen Chirurgie ausgelöst. Eine vorrangige Rolle spielt dabei die Vergrößerung der weiblichen Brust, ebenso wie deren Wiederaufbau nach Tumoroperationen. (Laut einer Statistik der American Society of Plastic Surgeons unterzogen sich im Jahr 2010 beispielsweise in den USA 296 203 Frauen einer Brustvergrößerung und 93 083 einer Brustrekonstruktion [1]; die jährliche Gesamtzahl an Brustimplantaten liegt in der westlichen Welt bei rund 3 Millionen). Patientinnen mit Silikon-Brustimplantaten entwickeln allerdings relativ häufig um das Implantat herum verdickte, verhärtete Bindegewebskapseln – sogenannte Fibrosen -, die zur Kapselkontraktur führen und neben ästhetischen Problemen auch Schmerzen bereiten.

Derartige Fibrosen finden sind nicht nur bei Brustimplantaten, sondern können sich auch um andere Silikon- (überzogene) Implantate entwickeln, wie beispielsweise um Herzschrittmacher, Cochleaimplantate, Insulinpumpen, etc. und um sogenannte passive Medizinprodukte wie Drainageschläuche, Kontaktlinsen oder Magenbänder (zur Gewichtsreduktion).

Da Brustimplantationen weltweit an großen Gruppen von Frauen ausgeführt werden, liegen hier auch die umfangreichsten epidemiologischen Studien zu Silikon-Nebenwirkungen vor. Der vorliegende Artikel beschränkt sich nur auf die durch Brustimplantate bei ansonsten gesunden Frauen ausgelöste Kapselfibrose, die aber als Paradigma für Reaktionen auf andere Typen von Silikon-Implantaten gelten kann. Im weiteren werden neue Erkenntnisse zur Entstehung dieser Fibrosen aufgezeigt und verbesserte Möglichkeiten zur Abschätzung des Risikos ihrer Entstehung und zur frühzeitigen Diagnose. Zur besseren Verständlichkeit dieses pathogenen Prozesses erfolgt einleitend eine kurze Charakterisierung des Bindegewebes, aus welchem heraus sich Fibrosen entwickeln und eine vereinfachte allgemeine Beschreibung von Fibrosen.

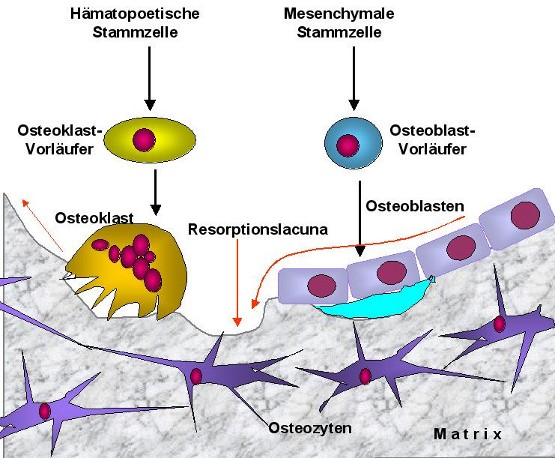

Was ist Bindegewebe?

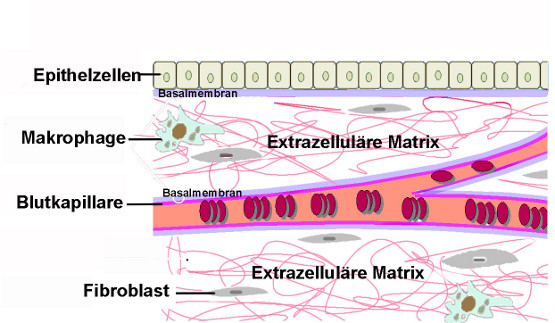

Bindegewebe ist eine Sammelbezeichnung für unterschiedlichste, überall im Organismus anzutreffende Gewebetypen, welche die Zellzwischenräume – das sogenannte Interstitium - bilden.

Bindegewebe bestehen aus einem dichten fachwerkartigen Maschenwerk von Proteinfasern, der extrazellulären Matrix, die in eine dem Serum vergleichbare Flüssigkeit eingebettet ist. In dieser Matrix finden sich in lockerem Verband Gewebszellen – sogenannte Fibroblasten –, welche u.a. die kollagenen und nicht-kollagenen Matrixproteine aufbauen. Im Bindegewebe verlaufen auch Nervenbahnen, Blutkapillaren und Lymphgefäße. Sauerstoff und Nährstoffe, welche aus den Blutgefässen austreten versorgen die umliegenden Zellen, metabolische Produkte werden in Blut- und Lymphkapillaren abtransportiert. Neben den Fibroblasten finden sich im Bindegewebe mobile Zellen, wie u.a. Fresszellen – Makrophagen – und Mastzellen, welche essentielle Rollen in der körpereigenen Abwehr spielen und dem angeborenen („innate“) Immunsystem zuzurechnen sind. Eine stark vereinfachte Darstellung des Bindegewebes ist in Abbildung 1 gegeben.

Abbildung 1. Schematische Darstellung eines Bindegewebes. Den Raum zwischen den Epithelzellen eines Organs (Interstitium) nimmt die extrazelluläre Matrix ein, ein Maschenwerk aus Proteinfasern (Kollagen-, Elastinfasern,...), das, eingebettet in eine viskose, wässrige Flüssigkeit, Organen ihre Form und Festigkeit verleiht. Die Gewebeflüsssigkeit ist zusammengesetzt aus stark quellenden Glykoproteinen, Komponenten des Plasmas, die aus den Blutkapillaren austreten und sezernierten Produkten (Metaboliten, Hormonen, Kofaktoren, etc.) benachbarter Zellen. In die Matrix eingelagerte Fibroblasten sind für den Aufbau der kollagenen und nicht-kollagenen extrazellulären Matrix verantwortlich. Zellen des Immunsystems schützen vor Fremdkörpern, Infektionen (Bild: modifiziert nach Wikipedia)

Was sind Fibrosen?

Unter Fibrose versteht man eine krankhafte, exzessive Bildung der extrazellulären Matrix des Bindegewebes, die auf einer unkontrollierten Vermehrung und Aktivierung der Fibroblasten basiert. Der Umbau zu fibrotischem Gewebe kann in praktisch allen Organen auftreten (von Lungenfibrosen, Leberzirrhose bis hin zur Fibrose der arteriellen Innenwand, der Arteriosklerose), zur Einschränkung bis hin zum Verlust der Funktion betroffener Organe führen und stellt damit ein enormes globales Gesundheitsproblem dar. Rund 45 % aller Todesfälle sind durch Fibrosen verursacht. Dementsprechend finden sich zum Thema „fibrosis“ in der größten textbasierten biomedizinischen Datenbank PubMed (www.ncbi.nlm.nih.gov/pubmed) seit 1974 rund 153 000 Veröffentlichungen. Dennoch sind erstaunlicherweise die Prozesse, welche Fibrosen auslösen und deren Pathogenese im Detail noch zu klären, ebenso sind Diagnose und Therapie von Fibrosen noch unbefriedigend.

Fibrosen können spontan, ohne feststellbare Ursache entstehen, häufiger entwickeln sie sich jedoch in Folge verschiedenster pathologischer Bedingungen: Entzündungsprozesse (verursacht durch Infektionen, Autoimmunreaktionen, etc.), Gewebsschädigung/-zerstörung (infolge von Trauma, Chemikalien, Verbrennungen, postoperativen Narben, Leberzirrhose, etc.), Tumore oder Kontakt mit Fremdmaterial (beispielsweise Silikonimplantate) können Fibrosen auslösen. Unabhängig davon, durch welche der diversen pathologischen Situationen eine Fibrose ausgelöst und perpetuiert wurde, entwickeln sich Fibrosen

- in ihrem weiteren Verlauf völlig stereotypisch und

- sind immer gekennzeichnet durch entzündlich-immunologische Merkmale:

Als Abwehr- und Reparaturmechanismus des Bindegewebes findet um die Blutgefäße herum eine Infiltration mit Zellen des Immunsystems (Monozyten, Lymphozyten) statt, welche vorerst sowohl pro- als auch anti-entzündliche sowie pro- und antifibrotische Botenstoffe (Zytokine) produzieren und die Normalisierung des Gewebes bewirken können. In der Folge kann es aber zu einem Ungleichgewicht der Botenstoffproduktion in Richtung pro-entzündlicher und pro-fibrotischer Mediatoren kommen, die zu einer Vermehrung von Fibroblasten und zu deren verstärkter Ablagerung von kollagenen sowie nicht-kollagenen extrazellulären Matrixproteinen führt. Die Population dieser Fibroblasten (sogenannter Myofibroblasten)ist dabei stark heterogen und unterscheidet sich von der in gesundem Gewebe durch Entstehung, Eigenschaften und Profil der produzierten Botenstoffe.

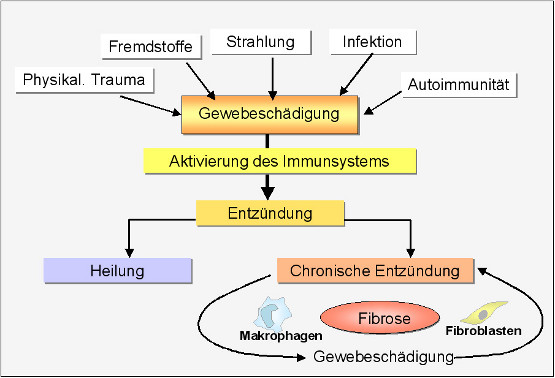

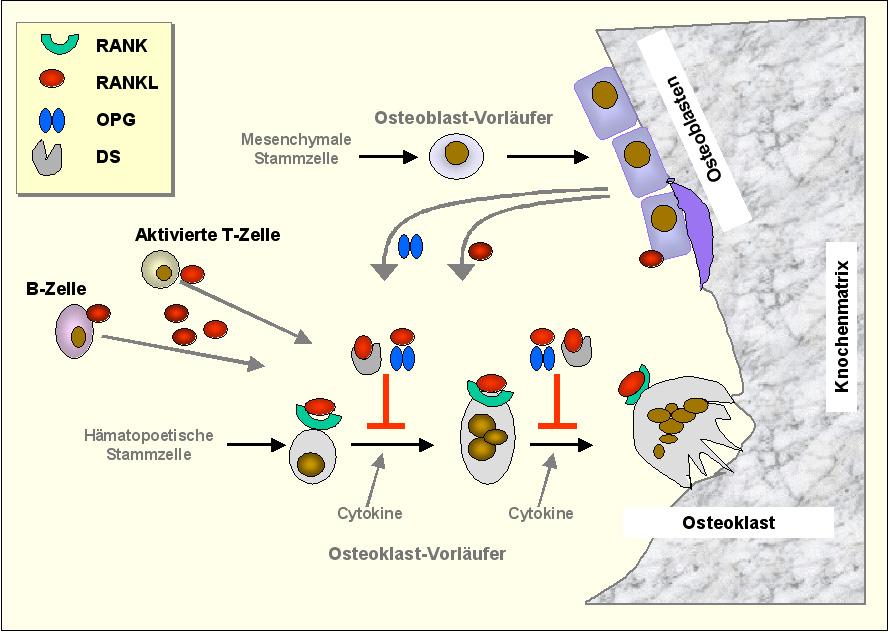

Wodurch der Abwehrmechanismus ursprünglich in Gang gesetzt wurde, ist in den meisten Fällen noch ungeklärt. Diesbezügliche, einander nicht ausschließende Hypothesen reichen von Infektionen, Reaktionen des Immunsystems gegen veränderte Proteinstrukturen („altered self“), Überproduktion von reaktivem Sauerstoff bis hin zu mechanischem Streß. Abbildung 2. fasst in vereinfachter Weise Ursachen und Entwicklung von Fibrosen zusammen.

Abbildung 2. Ursachen und Entwicklung von Fibrosen. Beschreibung: siehe Text. (Bild: modifiziert nach Wick et al., 2010)

Abbildung 2. Ursachen und Entwicklung von Fibrosen. Beschreibung: siehe Text. (Bild: modifiziert nach Wick et al., 2010)

Silikon-Implantate

Das Polymer Silikon (Polydimethylsiloxan) ist auf Grund seiner hervorragenden Materialeigenschaften und einer relativ hohen Bioverträglichkeit seit Jahrzehnten das weltweit am häufigsten verwendete Fremdmaterial für medizinische Produkte, darunter auch für Implantate. Entsprechend den behördlichen Auflagen für die Zulassung medizinischer Produkte müssen Silikonimplantate eingehend geprüft werden, in Untersuchungen, die über eine physikalisch-chemische Charakterisierung und Feststellung der mechanischen und biologischen Stabilität ein breites Spektrum an biologischen Studien - in sowohl präklinischen, als auch klinischen Anordnungen - zur Verträglichkeit und Toxizität einschließen. Dennoch erzeugen Silikon-Implantate bei zahlreichen Patienten schädigende Nebenwirkungen.

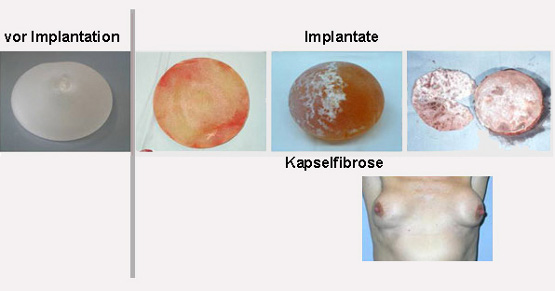

Ein Silikon-Brustimplantat besteht aus einer äußeren Schale, gebildet aus hochvernetztem Polymer Silikon, die (zumeist) mit einem Gel, einer Lösung von wenig-vernetztem Silikon oder mit einer physiologischen Kochsalzlösung gefüllt ist. Um dieses, wie auch um alle anderen Implantate bildet sich eine körpereigene Hülle aus einer zarten dünnen Schicht von Bindegewebe – diese ist nicht spürbar und „verankert“ das Implantat in dem umgebenden Gewebe. Häufig kommt es dann aber zur exzessiven Bildung von Bindegewebe um das Implantat herum, zur sogenannten Kapselfibrose, die eine Verhärtung und Kontraktion der Kapsel hervorruft (Abbildung 3).

Abbildung 3. Silikonbrustimplantate. Von links nach rechts: vor der Implantation, Entwicklung der Kapselfibrose um das Implantat bis hin zur Kapselkontraktion und verkalktem Implantat, darunter Patientin mit Kapselfibrose.

Wie ensteht die Kapselfibrose?

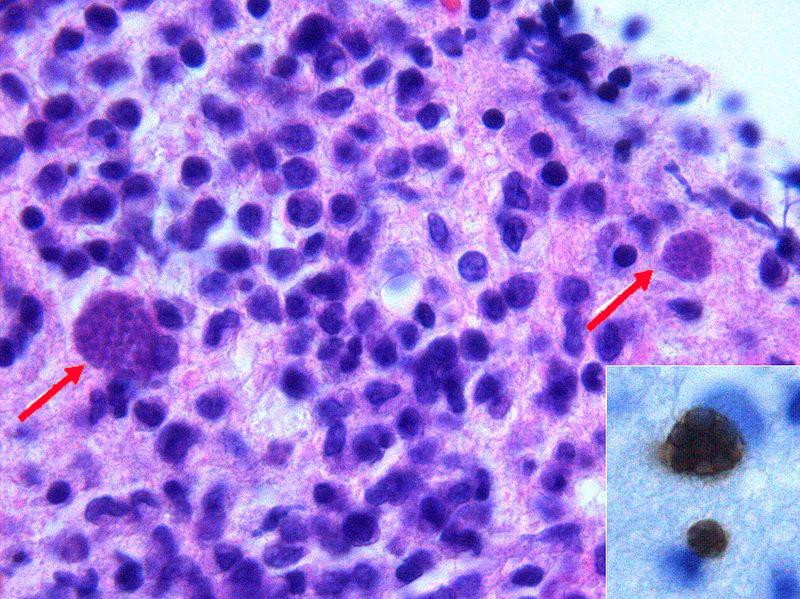

Unser Team hat die zelluläre und molekulare Zusammensetzung operativ entfernter, fibrotischer Kapseln analysiert und die aus den Befunden resultierenden Hypothesen durch in vitro und in vivo Modelluntersuchungen untermauert. In den fibrotischen Kapseln fanden sich reichlich Zellen des Immunsystems (T-Lymphozyten, Makrophagen, dendritische Zellen, einige B-Lymphozyten) und es zeigte sich klar, daß immunologische Prozesse eine primäre Rolle in der Pathogenese der Fibrosen spielen, deren Ablauf stark vereinfacht etwa so beschrieben werden kann [2, 3]:

Primär lagern sich auf der Oberfläche des Silikonimplantats Proteine aus Serum und Wundbettflüssigkeit an. Ein derartiger Proteinfilm entsteht bereits unmittelbar nach der Implantation, sein Ausmaß nimmt mit zunehmendem Alter des Implantats zu.

Es zeigte sich, dass die Proteine an der Silikonoberfläche quasi als Klebstoff wirken, an den sich dann Fibroblasten, Fresszellen (Makrophagen) und Proteine der extrazellulären Matrix anheften. Die Proteine an der Silikonoberfläche weisen zum Teil biochemische Veränderungen auf und/oder präsentieren Strukturbereiche, welche ansonsten im Innern des Protein verborgen sind („kryptische Strukturen“): diese, als fremd angesehenen Strukturen werden von den Makrophagen aufgenommen (phagozytiert) und bewirken deren Aktivierung. Eine Aktivierung der Makrophagen kann auch durch aufgenommene Silikon-Fragmente erfolgen.

Die Komponenten des Proteinfilms konnten diversen Proteinklassen zugeordnet werden - es dominieren Proteine der extrazellulären Matrix, weiters Proteine, welche direkt in die Immunantwort involviert sind, Transportproteine, Proteine, die als Antwort auf Stress gebildet werden, u.a.m. Von besonderer Bedeutung erscheint die vermehrte Ausschüttung des Stressproteins HSP60 (Hitzeschockprotein 60). Dieses Protein wird auch in anderen fibrotischen Erkrankungen, wie beispielsweise der Arteriosklerose, als Antwort auf zellulären Stress an der Zelloberfläche exprimiert, lockt dort als Trigger T-Lymphozyten an und löst die Immunreaktion in der innersten Schicht der Aorta aus.

Aktivierte Lymphozyten in der Kapsel und Makrophagen induzieren dann die Transformation von Fibroblasten in Typen, die mit verstärkter Synthese von Matrixproteinen den Umbau in fibrotisches Gewebe bewirken.

Ausblick

Zweifellos stellt die frühe Identifizierung und Eliminierung – oder zumindest Kontrolle - des auslösenden Faktors einer Fibrose den besten Ansatz zu deren Behandlung dar. Unsere Untersuchungen zur Kapselfibrose beschäftigen mit der Aufklärung der Prozesse, die den entzündlich-immunologischen Reaktionen zugrunde liegen, ebenso wie mit der Identifizierung molekularer Marker, die eine frühzeitige Diagnose der Fibrose ermöglichen und die Effizienz einer Therapie verfolgen lassen.

Basierend auf der Analyse der an Silikonoberflächen anhaftenden Serumproteine wurde ein neues Testsystem – SILISAR - entwickelt, das es erlaubt, das individuelle Adhäsionsmuster (die „Signatur“) dieser Proteine zu bestimmen. Da diese Signatur sich bei Patientinnen mit fibrotischen Komplikationen signifikant von jenem bei Patientinnen ohne derartige Nebenwirkungen unterschied, kann der Test u.a. zur Abschätzung des Risikos von Komplikationen vor der Einsetzung unterschiedlicher Silikonimplantate herangezogen werden. Zusammen mit einem molekularbiologisch bestimmbaren Marker zur Erkennung früher Fibrosestadien, kann SILISAR auch zur regelmäßigen Kontrolle von Implantat-Trägerinnen und damit zur frühzeitigen Erkennung und Behandlung von fibrotischen Komplikationen eingesetzt werden. Schließlich kann mittels der Tests dazu dienen, dass verträglichere Silikon-implantate (nicht nur zur Brustvergrößerung) entwickelt werden.

Diese Tests sollten zweifellos zu einer Verbesserung der gegenwärtigen Situation bei Brustimplantaten führen, die am besten mit der 2011 erfolgten Feststellung der amerikanischen FDA (Food and Drug Administration) aufgezeigt wird [1]:

„Erkennen Sie, dass Brustimplantate keine lebenslang haltbaren Produkte darstellen. Beachten Sie, dass Brustimplantate mit erheblichen lokalen Komplikationen assoziiert sind. Je länger Sie Implantate haben, desto wahrscheinlicher wird es notwendig diese entfernen zu müssen.... Lokale Komplikationen und unerwünschte Nebenwirkungen inkludieren Kapselkontraktion, Umoperieren, Entfernung und Reissen des Implantats. Viele Frauen erleiden auch Schmerzen, Faltenbildung , Asymmetrie, Narbenbildung und Infektionen.“

Einzelnachweise und Quellen

[1] FDA Update on the Safety of Silicone Gel-Filled Breast Implants, June 2011

[2] G.Wick et al., (2009) The immunology of fibrosis: innate and adaptive responses. Trends in Immunology 31: 110-119

[3] Backovic, A. et al. (2007) Identification and dynamics of proteins adhering to the surface of medical silicones in vivo and in vitro. J.Proteome Res. 6, 376–381

Weiterführende links

Fibrosen: Laboratory of Autoimmunity (Georg Wick) Was versteht man unter Kapselfibrose und was kann man dagegen tun? 2:12 min Bindegewebe (Connective Tissue): The Basics 13:30 min, Englisch Connective Tissue Lecture 6:21 min, Englisch

Homo ludens – Spiel und Wissenschaft

Homo ludens – Spiel und WissenschaftDo, 15.11.2012- 04:20 — Karl Sigmund

Von allen Wissenschaften ist sicher die Mathematik dem Spiel am nächsten verwandt und es leiten sich mindestens zwei wichtige mathematische Disziplinen - Wahrscheinlichkeitstheorie und Spieltheorie - direkt und unmittelbar aus dem Spiel ab. Mathematische Axiome entsprechen Spielregeln; es ist die freiwillige Festlegung auf Regeln, welche nicht nur das Spielen ermöglicht, sondern auch die Kooperation, also das Gesellschaftswesen Mensch schafft.

In meiner akademischen Frühzeit war ich Ergodentheoretiker: wenn ich mich als solcher vorstellte, traf ich zumeist auf Stirnrunzeln und blankes Unverständnis. Ganz anders jetzt, wenn ich sagen kann, dass ich Spieltheoretiker bin: meist ernte ich freundliches, ja gelegentlich schelmisches Lächeln. Das Spielen hat einen guten Ruf: ‚Der Mensch spielt nur, wo er in der vollen Bedeutung des Worts Mensch ist, und er ist nur da ganz Mensch, wo er spielt‘ (Friedrich Schiller). Freilich, in der Spieltheorie wird der Begriff ‚Spiel‘ in einem sehr eingeschränkten Sinn verwendet.

Um etwas weiter auszuholen: zum ersten Mal seit bald dreißig Jahren hab ich wieder in den „Homo Ludens“ von Johan Huizinga hinein gelesen, welcher die Rolle des Spiels in allen Bereichen der Kultur untersucht und es als Ursprungsort der großen kulturellen Haltungen ansieht. Der Historiker und Sprachwissenschafter Huizinga (1872 – 1945) liefert da in einem großartigen Galopp durch die geisteswissenschaftlichen Fächer eine klassische Studie des Spielelements in der Kultur. Kaum ein Bereich, zeigt er, der nicht vom Spiel geprägt ist. Aus den Spielregeln werden die selbstgesetzten Regeln zivilisierter Gemeinschaften: etwa für die Feste und Feiern, die besonders in frühen Gesellschaften einen gewaltigen Platz einnehmen. Das festliche Spiel ist ein Hauptbestandteil jedes Kults.

Überall ist Spiel

Thomas Bernhard ist ein Untertreibungskünstler, wenn er meint: ‚Die Leute am Land haben kein Theater außer der Kirche.‘

Rituelle Spielregeln sind auch in der Rechtspflege wesentlich. Noch heute hat jede gerichtliche Verhandlung Elemente von Glücksspiel und von Mummenschanz. Dazu kommt noch das Element des Wettstreits. Spannung und Ungewissheit gehören oft zum Spiel.

Rituelle Spielregeln finden wir auch bei Handel und Industrie wieder. Das Wort ‚Gewinn’ erinnert ans Glückspiel und Wetten (und steht damit im Gegensatz zum Wort ‚Lohn’). Jede Spekulation ist ein Hasardieren: die Börsenkurse beschreiben Irrfahrten. Börse und Spielhalle haben vieles gemeinsam.

Auch die Jagd, lang ein dominierender Wirtschaftszweig, ist von spielerischen Elementen durchsetzt, sowohl in archaischen Gemeinschaften, in denen sie ja eine Lebensnotwendigkeit darstellt, als auch als adeliges Vergnügen. Das ist in der Sprache lebendig geblieben. Die Wienerische ‚Hetz‘ kommt von der Tierhatz. Im Englischen sagt man ‚game‘ zum Wild. Eine Fuchsjagd ist ein Spiel – so grausam einseitig wie jenes der Katze mit der Maus.

Selbst der Krieg ist dem Spiel nahe verwandt. Ausdrücke wie ‚Kriegsspiel‘ (zur Vorbereitung des sogenannten ‚Ernstfalls‘) machen das deutlich. Schach ist angeblich ein Abkömmling generalstäblerischer Gedankenexperimente.

Vom Krieg zur Liebe: Im Geschlechtsleben kommt dem Spiel vor allem bei der Einleitung eine wichtige Rolle zu: Tändeln, Necken, Flirten, die tausend Spielarten des Vorspiels. Und nun zur Kunst: beim Schauspiel ist der Bezug evident, sowohl Darsteller als auch Zuschauer spielen ’als ob’. Alle Literatur spielt mit Wortklang und Vorstellung. In Tanz und Film werden Bewegungsspiele durchgeführt. Und der Zusammenhang von Spiel mit Musik wird schon dadurch unterstrichen, dass auch Berufsmusiker ihre Instrumente ‚spielen‘, ob im Deutschen, Englischen ‚to play an instrument‘, Französischen, Slawischen oder Arabischen. Was die Malerei betrifft, ihre ‚Illusionen’ leiten sich von ‚in-ludere‘ ab, da steckt ‚spielen‘ drin.

Und Architektur wird von sogar von einem Funktionalisten wie Le Corbusier definiert als das ‚korrekte, kluge und wunderbare Spiel von Volumen im Licht‘. Die Pyramidenbauer hätten es nicht besser ausdrücken können.

Zeit zum Lernen, Zeit zum Spielen

Hunderte Märchen und Mythen zeugen von der Bedeutung des Frage- und Antwort-Spiels, manchmal in der Form des Halsrätsels, das über Leben und Tod entscheidet. Im Deutschen löst man Rätsel, wie man Fesseln löst. Bis heute hat sich viel Spielerisches in den Riten der Gelehrsamkeit erhalten (auch das Theater in unserer Akademie der Wissenschaften spielt sich nicht immer nur im Theatersaal ab).

Neben der gestrengen Prüfung gibt es die geheimbündlerischen Weihen und den öffentlichen Disput. Und überhaupt kommt das Wort ‚Schule‘ vom griechischen Scholé, was soviel wie ‚Muße‘ bedeutete. Die wird heute den Kindern, ebenso wie den Lehrpersonen geraubt. Verspieltheit gilt als Zeichen mangelnder Reife, und wird oft getadelt.

Friedrich Nietzsche meinte: ‚In jedem rechten Manne ist ein Kind versteckt, das will spielen.‘ Konrad Lorenz gehörte zu den ersten, die darauf hinwiesen, dass in unserer Stammesgeschichte die verzögerte Reife eine entscheidende Rolle gespielt hat, also das Kind im Manne (und in der Frau). Der Mensch ist so etwas wie ein unreifer Affe. Ein ganzes Bündel sogenannter neotener Eigenschaften belegt das: körperliche Zeichen der Kindlichkeit wie etwa die hohe Stirn, das zarte Kinn, die spärliche Körperbehaarung.

Von den Schimpansen sehen uns die Babys weit ähnlicher als die Erwachsenen. Wir sind steckengeblieben in der Kindheit. Wir benötigen ein Drittel unserer Lebensspanne zum Heranwachsen. Das gibt uns Zeit, um zu lernen, vor allem aber, zu spielen (Abbildung 1).  Abbildung 1: Kinderspiele, P. Bruegel d.Ä. 1550 (Kunsthistorisches Museum, Wien. Bild: Wikimedia)

Abbildung 1: Kinderspiele, P. Bruegel d.Ä. 1550 (Kunsthistorisches Museum, Wien. Bild: Wikimedia)

Wir Menschen haben kein Monopol auf das Spiel

Bei vielen Säugetieren und Vögeln lässt sich Spielverhalten beobachten. Vögel segeln im Sturm, Marder rutschen im Winter über schneebedeckte Windschutzscheiben, Menschenaffen verdecken ihre Augen und blinzeln verstohlen zwischen den Fingern hindurch.

Zur Domestikation von einigen Haustieren hat wohl die Freude an einem verlässlichen Spielpartner erheblich beigetragen. Montaigne schreibt: ‚Wenn ich mit meiner Katze spiele, wer weiß, ob es ihr nicht noch mehr Spaß macht als mir?‘ Spielbereitschaft drückt sich bei Tieren durch eigene Signale aus, und wirkt ansteckend.

Selten ist so ein Spiel von unmittelbarem Nutzen, aber offenbar längerfristig von Wert: ohne Zweck, aber sinnvoll. Bei der spielerischen Erkundung ihrer Umwelt und Gemeinschaft sammeln Heranwachsende viel Erfahrung. Neugierverhalten weist stets einen kindlich-verspielten Zug auf.

Oft übt ein Jungtier Bewegungsabläufe ein, die es später braucht, etwa bei Beutefang, Flucht oder Balz. Eine Katze, die einen Fetzen beutelt, mit der Pfote unter den Teppich wischt oder einem Schnurende nachspringt, führt offenbar Jagdbewegungen aus. Und raufende Welpen erwerben spielerisch Erfahrung für spätere Kämpfe.

Diese Tiere tun so, als ob. Dieses spielerische Üben und Lernen belohnt sich selbst. Eine Katze braucht kein Stück Wurst, um bereit zu sein, die Übung zu wiederholen.

Doch selbst der ausgeprägteste Spieltrieb ist weit schwächer als andere Triebe. Schon ein geringes Maß an Angst oder Hunger reicht aus, um jedes Spiel zum Erliegen zu bringen. Nur dort, wo es von Notwendigkeiten nicht behelligt wird, kann es gedeihen. Jeder Zwang unterdrückt es.

Selbst angeborenes Spielverhalten ist in diesem Sinn frei von Zwang, ist programmierte Offenheit. Diese Offenheit macht es so schwer zu Umschreiben wie keine andere biologische Funktion. Psychologen unterscheiden Funktionsspiele, Fiktionsspiele, Konstruktionsspiele, Rollenspiele und so fort, aber die Grenzen sind fließend.

Was ist allen Spielen gemeinsam?

Wittgenstein stellt diese Frage in seinen Philosophischen Untersuchungen:

„Gibt es überall eine Konkurrenz der Spielenden? ‚Denk an Patiencen‘. Gibt es Gewinner und Verlierer? ‚Wenn ein Kind einen Ball an die Wand wirft und wieder auffängt, ist dieser Zug verschwunden‘. Schau, welche Rolle Geschick oder Glück spielen…Denk nun an Reigenspiele…Was ist noch ein Spiel und was keines mehr? Kannst du eine Grenze angeben? Nein.“ (PU §66 ff)

Wittgenstein verwendet hier den Begriff des Spiels als ein Beispiel (Bei-Spiel!) für einen Begriff mit verschwommenen Rändern. Dass die Regeln für seinen Gebrauch nicht vollständig abgegrenzt sind, schadet nichts, solange sie ausreichen für seine Rolle im Sprachspiel. Wittgenstein führt noch andere unscharfe Worte an, etwa ‚Zahl’ oder ‚gut’ oder ‚wissen’. Doch hat er für das Wort ‚Spiel’ eine ausgeprägte Vorliebe. Vielleicht weil unter allen Tätigkeiten das Spielen die offenste ist. Jedenfalls ist Wittgensteins Frage ‚Wie ist denn der Begriff des Spiels abgeschlossen?‘ fast schon ein sophistischer Kunstgriff. Kein Wunder, dass der Begriff des Spiels sich nicht scharf umgrenzen lässt – zum Spiel selbst gehört ja ein Freiraum dazu. Man spricht auch vom Spielraum eines mechanischen Teils, von seinem Spiel, das für die Beweglichkeit nötig ist.

Spiel und Wissenschaft

Dass Wissenschaft mit Spiel zu tun hat, spiegelt sich auch darin wider, dass man immer häufiger Modelle statt Theorien untersucht. Wie Spielsachen lassen sich solche Modelle herzeigen, zerlegen, und dann oft genug wegwerfen. Modelle haben eine Art aufgehobener Wirklichkeit. Niemand würde für ein Modell den Scheiterhaufen riskieren.

Spiel und Wissenschaft haben gemeinsam, dass sie zumeist nicht auf unmittelbaren Nutzen ausgerichtet sind. Ein Spiel braucht durch nichts gerechtfertigt werden, Grundlagenforschung auch nicht. Der weltberühmte österreichische Physiker Ludwig Boltzmann schrieb: ‚Solange die Alchemisten nur den Stein der Weisen suchten (sicher ein ungemein nützliches Ziel) war all ihr Bemühen vergeblich. Erst die Beschränkung auf scheinbar weniger wichtige Fragen schuf die Chemie.‘ Dass Wissenschaft langfristig nützlich sein kann, ist ein kollateraler Effekt.

Von allen Wissenschaften ist sicher die Mathematik dem Spiel am nächsten verwandt, obwohl ihr hoher Unterhaltungswert oft übersehen wird. Die mathematischen Axiome entsprechen Spielregeln. Axiome wie Spielregeln schaffen – als Spielraum – eine eigene Welt in der Welt, Doderer würde sagen: ein Jenseits im Diesseits. Spielende Kinder können buchstäblich außer sich geraten. Weder Spielregeln noch Axiome lassen sich sinnvoll anzweifeln. Man kann sie nur akzeptieren oder nicht.

[[Besonders beliebt ist der Vergleich von Mathematik mit Schach. Nicht mit Turnierschach, sondern mit der Lösung von Schachproblemen. Kann Schwarz den Gegner in drei Zügen matt setzen, ja oder nein? Solche Aufgaben findet man in den Spielecken der Beilagen, fein abgetrennt vom redaktionellen Teil der Zeitung. Wie ja überhaupt Abgrenzung oft als Vorbedingung zum Spiel gehört: ob jetzt ein Fußballplatz, eine Bühne, ein Boxring, eine Kultstätte, ein Gerichtsort. Im Altertum wurden manchmal sogar die Schlachtfelder abgesteckt. Das Spielbrett spiegelt diese Tatsache wieder, besser gesagt: es ist ein Modell dafür. Ganz analog gelten in mathematischen Räumen eigene selbstgewählte Gesetze.]]

Das so-tun-als-ob gehört zum Handwerkszeug der Mathematiker. Besonders schön kommt das bei den indirekten Beweisen zum Ausdruck. Man tut so, als ob diese oder jene Aussage wahr wäre (etwa: es gibt eine größte Primzahl) und zieht daraus Folgerungen, die schließlich zu einem Widerspruch führen, was beweist, dass die Aussage falsch sein muss (hier: es gibt keine größte Primzahl, es muss also unendlich viele Primzahlen geben).

Neben dieser allgemeinen Verwandtschaft zwischen Mathematik und Spiel leiten sich mindestens zwei wichtige mathematische Disziplinen direkt und unmittelbar aus Spielen ab, nämlich Wahrscheinlichkeitstheorie und Spieltheorie. Die Entstehung der Ersteren wird im Folgenden behandelt, die Spieltheorie in einem weiteren Essay.

Glücksspiele als Wiege der Wahrscheinlichkeitstheorie

Abbildung 2: Achilleus und Ajax beim Würfelspiel (ca. 500 AC, Louvre. Bild: Wikipedia)

Abbildung 2: Achilleus und Ajax beim Würfelspiel (ca. 500 AC, Louvre. Bild: Wikipedia)

Die Wahrscheinlichkeitstheorie spielte bei den Griechen noch keine Rolle, aber mit dem Zufall gespielt haben sie schon!

Die Griechen sahen sich als Erfinder des Würfelspiels – wie Abbildung 2 mutmaßt, könnte es ein Zeitvertreib der Belagerer Trojas gewesen sein. (Allerdings kannten die Ägypter den Würfel schon zur Zeit der ersten Dynastie.)

Das Münzgeld dagegen kam erstmals in Griechenland auf, und man darf wohl vermuten, dass bald darauf 'Kopf oder Adler' gespielt wurde (vielmehr ‚Kopf oder Eule’).

Kartenspiele gibt es seit dem Mittelalter.

Gutenberg druckte zwar als erstes pflichtschuldigst die Bibel, aber noch im selben Jahr auch einen Satz Spielkarten. Lotterien stammen aus dem Florenz der Renaissance.

Die französische Aufklärung bescherte uns das Roulettespiel (als Erfindung eines Polizeioffiziers). Die Russen entwickelten eine eigene Variante.

Industrialisierung brachte Glückspielautomaten, usw.

Glückspiele standen an der Wiege der Wahrscheinlichkeitstheorie. Fast gleichzeitig wendeten sich Geister wie Pascal, Fermat, Huyghens und Newton ihr zu.

Eine typische Frage war folgende:

Mit zwei Würfeln lässt sich die Augensumme 9 auf zweierlei Weise erhalten, als 3+6 oder als 4+5. Ebenso kann man die Augensumme 10 auf zweierlei Weise erhalten, als 4+6 oder 5+5. Wieso kommt es dann häufiger zur Augensumme 9 als zur Augensumme 10? Wenn man mit drei Würfeln spielt, kann man die beiden Augensummen 9 und 10 auf jeweils sechs verschiedene Weisen erhalten. Aber diesmal kommt die 10 häufiger vor als die 9. Das verlangt nach Erklärung!

Inzwischen hat sich die Wahrscheinlichkeitsrechnung von den Spielsalons emanzipiert. Aber die ersten Anwendungen betrafen Versicherungen, die im Grunde ja auch Glücksspiele sind. Jährlich zahlen wir eine Prämie, unseren Einsatz: mit einer gewissen Wahrscheinlichkeit gewinnen wir eine hohe Summe, nämlich dann, wenn etwa unser Haus abbrennt. Das ist ein Glückspiel (und im Mittel verlieren wir dabei, genau so wie im Kasino): ein Glückspiel, dem freilich nichts Frivoles mehr anhaftet.

Heute ist die Wahrscheinlichkeitstheorie aus Physik, Chemie, Wirtschaft, Biologie nicht wegzudenken. Mit dem Zufall zu rechnen haben wir spielerisch gelernt.

Wahrscheinlichkeitstheorie und Risikobereitschaft

Es herrschen große individuelle Unterschiede in unserer 'Risikobereitschaft'. Es gibt Spielernaturen und geborene Pessimisten. Man kann das durch Experimente mit Lotterien testen.

Beispiel 1: Typischerweise wird die Versuchsperson gefragt, welche der folgenden Alternativen sie bevorzugt: A: 3000 Euro mit Sicherheit B: Teilnahme an einer Lotterie, bei der man mit 80 Prozent Wahrscheinlichkeit (W) 4000 Euro erhält und mit 20 Prozent W. nichts.

Obwohl also der Erwartungswert der Lotterie B 3200 Euro ist, bevorzugen 82 Prozent der Befragten A. Sie sind risiko-scheu. Das ist ihr gutes Recht.

Interessanterweise sieht die Sache bei der nächsten Lotterie ganz anders aus.

Beispiel 2: Man wähle zwischen: A: 3000 Euro mit 25 Prozent W. (und 0 mit 75 Prozent W.) B: 4000 Euro mit 20 Prozent (und 0 mit 80 Prozent).

Hier wählen 70 Prozent die zweite Alternative. Warum sollten sie nicht? Nun, das Bemerkenswerte ist, dass der zweite Test dieselben Alternativen bietet wie der erste, außer dass die Wahrscheinlichkeiten auf ein Viertel gestutzt sind.

Anders ausgedrückt, die zweite Frage können wir so sehen: zuerst wird eine Münze zweimal geworfen, und nur wenn sie beide Male Kopf liefert (was mit einer Wahrscheinlichkeit von ein Viertel geschieht), wird die erste Frage gestellt. Wenn die Spieler nach dem zweifachen Münzwurf entscheiden, entscheiden viele anders, als vorher. Und das ist rational schwer zu begründen.

Derlei Experimente sind von Allais in den Fünfzigerjahren, später von Kahnemann, Twersky etc durchgeführt worden (das lieferte einige Wirtschafts-Nobelpreise).

Beispiel 3: Hier noch ein Beispiel, der sogenannte Stanford-Quiz. Nehmen wir an, dass die Wahrscheinlichkeit, zuckerkrank zu sein, 1:1000 beträgt. Stellen wir uns einen Test vor, der die Krankheit untrüglich erkennt, wenn sie vorliegt, aber mit einer Wahrscheinlichkeit von 5 Prozent auch bei einem Gesunden ein 'positives' Resultat liefert. Wenn dieser Test bei Ihnen die Diagnose 'zuckerkrank' liefert, ist also nicht sicher, dass sie wirklich daran erkrankt sind. Wie groß ist die Wahrscheinlichkeit? Die meisten Schätzungen liegen völlig falsch. Die Wahrscheinlichkeit ist kleiner als zwei Prozent. (Denn bei tausend Leuten liefert der Test 50 falsche 'positive' Ergebnisse, und nur ein richtiges).

Ein anderes Paradox stammt vom Psychologen Ellsberg. Wenn der Spieler die Häufigkeit der roten und schwarzen Kugeln in einer Urne nicht kennt, so wird er mit gleicher Bereitschaft auf rot oder schwarz setzen.

Wenn er andrerseits weiß, dass die Urne gleich viele rote wie schwarze Kugel enthält, so wird er wiederum keine Farbe bevorzugen.

Wenn er aber, bevor er auf eine Farbe setzt, zwischen den beiden Urnen wählen kann, so hat er meist eine deutliche Vorliebe für die Urne mit dem bekannten Inhalt. Die Wahrscheinlichkeitsrechnung kann das nicht erklären - schließlich beträgt die Gewinnwahrscheinlichkeit in beiden Fällen 50 Prozent. Dieses psychologische Paradox wirft ein bezeichnendes Licht auf unser Verhältnis zu Ungewissheit und Risiko.

Ich brauche nicht zu erwähnen, dass auch die Neurowissenschaftler davon fasziniert sind, und untersuchen, was in unseren Hirnen passiert, wenn wir Risiken eingehen.

Spieltheorie, eine Theorie der Interessenskonflikte – wird, wie oben angekündigt, in einem nachfolgenden Essay behandelt.

Anmerkungen der Redaktion

Dieser Text entstand auf der Basis eines Referats mit dem Titel „Homo ludens: Offenheit, Wahrscheinlichkeit, Festlegung“, das am 27. September in der Österreichischen Akademie der Wissenschaften gehalten wurde.

Glossar:

Ergodentheorie: ist ein Begriff innerhalb des mathematischen Teilgebiets der Stochastik, entstanden aus dem Bemühen, Methoden und Folgerungen der statistischen Mechanik mathematisch korrekt zu formulieren und beweisen. Die Statistik eines Prozesses wird von einer Musterfunktion beschrieben

Stochastik: Wissenschaft, die sich mit zufallsabhängigen Phänomenen beschäftigt.

Links:

Karl Sigmund im Science-Blog: Die Evolution der Kooperation

PDF-Download: Evolutionäre Spieltheorie.

Von Gesellschaftsspielen zum Spielen mit Gesellschaften.

Ludwig Wittgenstein: Philosophische Untersuchungen

Wie erfolgt eine Optimierung im Fall mehrerer Kriterien? Pareto-Effizienz und schnelle Heuristik

Wie erfolgt eine Optimierung im Fall mehrerer Kriterien? Pareto-Effizienz und schnelle HeuristikDo, 08.11.2012- 00:00 — Peter Schuster

Eine gleichzeitige Optimierung mehrerer Kriterien ist komplex und führt zu einer Vielzahl an nicht-vergleichbaren Ergebnissen. Entscheidungen hinsichtlich dieser Ergebnisse müssen dann an Hand weiterer Kriterien getroffen werden. Allerdings sind rigorose Formalismen zur Optimierung im praktischen Leben häufig nutzlos, wenn Entscheidungen rasch und daher mit begrenzter Rationalität zu treffen sind.

Jeder, der einmal in der Oberstufe eines Gymnasiums gesessen ist, hat gelernt, wie man das Maximum oder Minimum einer mathematischen Funktion bestimmt. Wie man optimiert, erscheint einem großen Teil unserer Bevölkerung – Wissenschafter miteingeschlossen – daher ein recht einfaches Unterfangen zu sein.

Wer sich mit dem Problem der Optimierung aber näher befaßt, findet sehr schnell heraus, daß die im Lehrbuch aufgezeigte Lösung nur sehr wenig mit der realen Welt zu tun hat, in welcher ja gleichzeitig Optimierungen hinsichtlich mehrerer Parameter erforderlich sind. Mit eben mit diesem Problem beschäftigt sich ein kürzlich von einer Projektgruppe der Berlin-Brandenburgischen Akademie der Wissenschaften veröffentlichter Band [1]: „Wie erfolgt eine Optimierung im Fall mehrerer Kriterien, mehrerer Ziele und wie können wir derartige Situationen erfolgreich bewältigen?

Optimierungsprozeß unter Einbeziehung mehrerer Kriterien

Verständlicherweise führt ein Optimierungsprozeß unter Einbeziehung mehrerer Kriterien zu widersprechenden Lösungen – außer die Kriterien sind voneinander völlig unabhängig, was ja ein in der Realität höchst seltener Fall ist. Ein simples Beispiel einer derartigen Optimierung soll hier angeführt werden:

Mit einem Auto von A nach B zu fahren braucht Zeit und man benötigt Benzin. Natürlich möchte jeder so schnell wie möglich B erreichen, natürlich sollten der Benzinverbrauch und damit die Kosten minimal sein. Klar ist auch, daß jedes Auto mehr Benzin verbraucht, wenn es schneller fährt. Wir haben es hier also mit zwei Pseudo-Optima zu tun: mit der kürzesten Zeit um von A nach B zu kommen und der wirtschaftlich günstigsten Geschwindigkeit diese Strecke zurückzulegen; es muß nicht erwähnt werden, daß die beiden Optima unterschiedlich ausfallen.

Um das Beispiel Autofahren weiter zu spinnen: Jeder Autokäufer ist daran interessiert, die Produkte verschiedener Autohersteller zu vergleichen. Falls der Kunde nun alle anderen Kriterien außer Geschwindigkeit und Benzinverbrauch unberücksichtigt läßt, kann dafür ein einfaches Preis- Leistungs-Diagramm erstellt werden, das sogenannte Pareto-Effizienz aufweist; das heißt, einen Zustand angibt, in dem es nicht möglich ist, ein Kriterium zu verbessern, ohne zugleich das andere zu verschlechtern. Abbildung 1

Abbildung 1. Pareto-Set: Autofahren als Beispiel der Optimierung hinsichtlich zweier gegensätzlicher Kriteria, Geschwindigkeit und Kosten. Die inverse Geschwindindigkeit aufgetragen gegen die Fahrtkosten zeigt Pareto-effiziente Fahrzeuge (schwarze Sterne). Der rote Stern ist Pareto-ineffizient und kann hinsichtlich maximaler Geschwindigkeit und minimaler Kosten weiter optimiert werden.

Abbildung 1. Pareto-Set: Autofahren als Beispiel der Optimierung hinsichtlich zweier gegensätzlicher Kriteria, Geschwindigkeit und Kosten. Die inverse Geschwindindigkeit aufgetragen gegen die Fahrtkosten zeigt Pareto-effiziente Fahrzeuge (schwarze Sterne). Der rote Stern ist Pareto-ineffizient und kann hinsichtlich maximaler Geschwindigkeit und minimaler Kosten weiter optimiert werden.

In diesem Plot liegen die Produkte der meisten Autohersteller nahe dem Pareto-Optimum – einer hyperbelartigen Funktion, die quasi eine Grenze zwischen Möglichem und Unmöglichem darstellt. Jeder einzelne dieser Punkte resultiert aus den unterschiedlichen individuellen Preferenzen, beispielsweise wieviel Geld es dem Käufer wert ist, schneller zu fahren.

Ein Produkt in dieser Darstellung (mit rotem Stern gekennzeichnet) erscheint Pareto-ineffezient, d.h. seine Leistung in einem Kriterium kann gesteigert werden ohne das andere negativ zu beeinflussen – beispielsweise kann der Kraftstoffverbrauch gesenkt werden ohne negative Auswirkungen auf die maximale Geschwindigkeit zu haben und vice versa. Zwei Gerade, parallel zu den Achsen begrenzen die Kurve und beschreiben die beiden extremen Situationen: i) das schnellste Auto zu wählen unabhängig von seinen Kosten, ii) das wirtschaftlichste Auto unbhängig davon, wie langsam es dahinzottelt.