Do, 09.08.2018 - 10:04 — Georg Martius

Roboter als Helfer im Alltag könnten in Zukunft unser Leben besser machen. Der Weg dahin ist aber noch weit. Einerseits muss an geeigneter alltagstauglicher Hardware geforscht werden. Andererseits, und das ist das weitaus größere Problem, muss das richtige „Gehirn” entwickelt werden. Um auch nur annähernd an die menschlichen Fertigkeiten heranzureichen, muss ein Roboter Vieles selbst lernen. Georg Martius, Leiter der Forschungsgruppe Autonomes Lernen am Max-Planck-Institut für Intelligente Systeme (Tübingen) arbeitet an der Programmierung eines künstlichen Spieltriebs und den dazugehörigen Lernverfahren, so dass sich künstliche Systeme in Zukunft selbst verbessern können.*

Roboter als Helfer im Alltag könnten in Zukunft unser Leben besser machen. Sie könnten uns lästige Arbeit im Haushalt abnehmen oder sie könnten älteren und behinderten Menschen assistieren, so dass diese unabhängig leben können. Für die Menschen bliebe dann mehr Zeit für interessantere Dinge.

Der Weg dahin ist aber noch weit. Einerseits muss an geeigneter alltagstauglicher Hardware geforscht werden, denn heutige Roboter sind entweder zu schwer oder nicht stark und robust genug. Außerdem fehlt es ihnen an Sensoren für die Wahrnehmung der Umgebung und von sich selbst. Andererseits, und das ist das weitaus größere Problem, muss das richtige „Gehirn” entwickelt werden. Ein bestimmtes Verhalten vorzuprogrammieren ist jedoch nur bedingt erfolgversprechend, weil man zur Entwicklungszeit schon alle Eventualitäten vorhersehen müsste. Wenn wir an echte Alltagssituationen denken, dann wird schnell klar, dass es dazu aber viel zu viele Ungewissheiten gibt und dass darüber hinaus ständig neue, unvorhersehbare Situationen auftreten können.

Der Mensch hingegen hat nur ganz wenig „vorprogrammiertes” Verhalten und lernt stattdessen kontinuierlich: Bereits als Fötus knüpft er erste Zusammenhänge zwischen Muskelaktionen und sensorischen Signalen; als Baby erlernt er erste koordinierte Bewegungen, und während des gesamten Entwicklungsprozesses baut er ein Verständnis von der Welt auf und verfeinert dieses immer mehr. Uns scheint die Interaktion mit der Welt überhaupt keine Mühe zu kosten, das Einschenken einer Tasse Kaffee oder das Laufen durch den Wald funktionieren scheinbar wie von selbst. Das war aber nicht von Anfang an so, diese Fähigkeiten hat jeder von uns erlernt.

Um auch nur annähernd an die menschlichen Fertigkeiten heranzureichen, muss ein Roboter Vieles selbst lernen. Aber wie geht das? Kinder sind da ein ideales Vorbild: Sie entdecken die Welt spielerisch. Kinder versuchen, grob gesagt, immer das eigene Verständnis der Welt zu verbessern und führen kleine Experimente durch. Jeder kennt die Situation, wenn ein Kleinkind untersucht, was passiert, wenn es die Tasse vom Tisch schiebt.

Bei den Eltern unbeliebt – aber notwendig, um zu verstehen, dass Dinge herunterfallen, wenn man sie nicht festhält. Die Forscher der Arbeitsgruppe Autonomes Lernen am Max-Planck-Institut für Intelligente Systeme (Tübingen) arbeiten am künstlichen Spieltrieb und den dazugehörigen Lernverfahren, so dass sich künstliche Systeme in Zukunft selbst verbessern können.

Zielfreies Verhalten

Um den Spieltrieb zu verstehen, muss man sich erst einmal davon lösen, dass der Roboter bestimmte vorgegebene Aufgaben erledigen soll. Aber wie kann man dem Roboter einen Spieltrieb einprogrammieren? Das geht jedenfalls nicht durch vorgefertigte Muster oder Abläufe. Es geht vielmehr ganz allgemein über Konzepte wie beispielsweise jenes des Informationsgewinns. Mit Methoden der Informationstheorie, ursprünglich entwickelt um Informationsübertragung bei der Telekommunikation zu beschreiben und zu optimieren, lässt sich der Informationsgewinn mathematisch beschreiben und berechnen.

Eine Möglichkeit besteht darin, dass der Roboter anstrebt sich so zu verhalten, dass die beobachteten Sensorwerte viel Information beinhalten, um künftige Sensorwerte vorherzusagen. Das schließt unter anderem aus, dass er gar nichts tut, denn dann beinhalten die Sensorwerte nur eine insgesamt minimale Informationsmenge. Auch darf er nicht chaotisch herumzappeln, denn dann kann er nicht gut vorhersagen, was passieren wird.

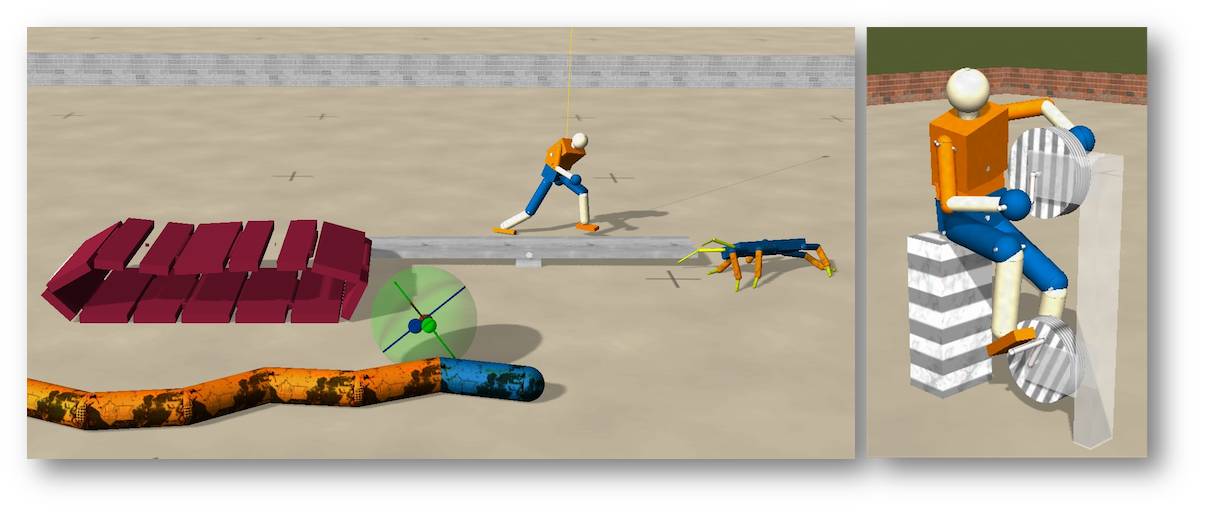

Den Forschern am MPI für Intelligente Systeme ist es gelungen, aus diesem allgemeinen Prinzip eine Lernregel abzuleiten [1]. Diese erlaubt den Robotern, verschiedene Verhaltensmuster eigenständig zu probieren. Die Steuerung übernimmt ein kleines künstliches Neuronales Netz. Die Verbindungsstärke zwischen den künstlichen Neuronen wird aufgrund der Lernregel ständig geändert, ähnlich wie im menschlichen Gehirn. Was passiert, hängt entscheidend vom Aufbau des Roboters und dessen Interaktion mit der Umwelt ab. Um sich nicht ständig mit kaputten Robotern herumschlagen zu müssen, wird viel mit physikalisch realistischen Simulationen gearbeitet jedoch auch an echten Systemen getestet. Abbildung 1.

Abbildung 1. Alle simulierten Roboter haben das gleiche Gehirn und starten ohne Vorwissen. Sie versuchen spielerisch, ihren Körper und die Interaktion mit der Umwelt zu entdecken. © Georg Martius Um diese oder andere selbstlernende Systeme besser charakterisieren zu können, bedarf es neuer Methoden in der Auswertung durch Informations- und Komplexitätsmaße [3].

Der Natur nachempfunden

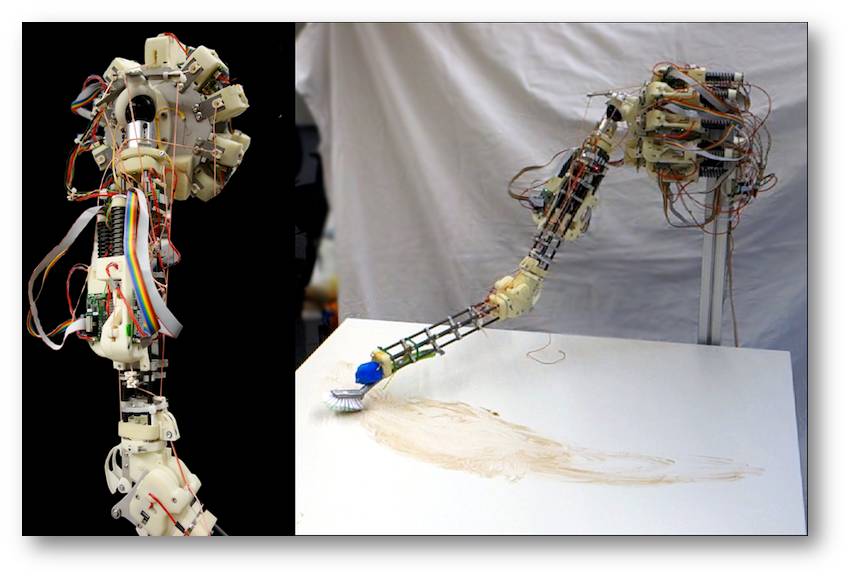

Die Forscher haben die oben erwähnte Lernregel weiter verbessert und dahin entwickelt, dass sie im Prinzip auch durch natürliche Neuronen umgesetzt werden könnte [3]. Mit dem neuen “Robotergehirn” gelingt es, noch klareres Verhalten von selbst zu erlernen. Zum Beispiel lernt ein simulierter Humanoider Roboter in wenigen Minuten zu kriechen oder an einem Fitnesstrainer Räder zu drehen (s. Abbildung 1). Die meisten Roboter haben starre Glieder und Getriebe in den Gelenken - hochpräzise und sehr robust. Diese sind gut für den industriellen Einsatz aber auch schwer und starr. Im Umfeld von Menschen sind weichere Roboter, die insbesondere nachgeben wenn man sie wegdrückt, deutlich weniger gefährlich. In Anlehnung an die menschliche Anatomie wurden vor kurzem Roboter mit Sehnen und künstlichen Muskeln konstruiert. Allerdings gestaltet sich deren Ansteuerung sehr schwierig und das Lernen wird noch essentieller. Die Verfahren der Forschungsgruppe kommen auch mit solchen Systemen klar und erzeugen viele verschiedene und potentiell nützliche Verhaltensmuster, wie zum Beispiel das eigenständige Schütteln einer Flasche oder das Abschrubben eines Tisches. Abbildung 2. [4].

Abbildung 2. Ein sehnengetriebener Roboterarm. Links sieht man gut das Kugelgelenk in der Schulter und die Seile als Sehnen. Rechts schrubbt der Roboter den Tisch. © Georg Martius

Ausblick

Die Roboter sollen zum einen lernen, irgendwelche Bewegungen auszuführen, zum anderen, gewünschtes Verhalten zu zeigen und darüber hinaus ein gewisses Verständnis von der Welt und ihren Fähigkeiten zu erlangen. Um dies zu erreichen, arbeiten die Forscher an Verstärkungslernen, dem Erlernen von Repräsentationen und internen Modellen, die es den Robotern erlauben genaue Vorhersagen zu machen. Um nicht nur zufällig zusammen auftretende Ereignisse zu verknüpfen, sondern die tatsächlichen Zusammenhänge aufzudecken, benötigt es neue Lernverfahren. Ein kleiner Baustein ist den Forschern schon gelungen, nämlich das automatische Herausfinden der tatsächlich zugrunde liegenden Gleichungen aus Beobachtungen [5]. Damit lassen sich Vorhersagen in unbekannten Situationen treffen.

Bis jetzt sind die selbstlernenden Roboter noch im “Babystadium”, aber sie lernen schon zu kriechen und einfache Dinge zu tun. Das langfristige Forschungsziel ist, dass sie eines Tages zu zuverlässigen Helfern in allen möglichen Situationen “heranwachsen” werden.

Literatur

1. Martius G.; Der R.; Ay N. Information driven self-organization of complex robotic behaviors. PLoS ONE, 8, e63400 (2013)

2. Martius G.; Olbrich E. Quantifying emergent behavior of autonomous robots. Entropy 17, 7266 (2015)

3. Der R.; Martius G.Novel plasticity rule can explain the development of sensorimotor intelligence. Proceedings of the National Academy of Sciences, 112, E6224-E6232 (2015)

4. Der R.; Martius G. Self-organized behavior generation for musculoskeletal robots. Frontiers in Neurorobotics, 11 (2017) 5. Martius G.; Lampert C. H. Extrapolation and learning equations. arXiv preprint https://arxiv.org/abs/1610.02995, 2016.

* Der Artikel ist unter dem gleichnamigen Titel: "Roboter mit eigenem Tatendrang" " (https://www.mpg.de/11868495/mpi-mf_jb_2018?c=1342916) im Jahrbuch 2018 der Max-Planck-Gesellschaft erschienen. Der Artikel wurde mit freundlicher Zustimmung desAutors und der MPG-Pressestelle dem ScienceBlog zur Verfügung gestellt. Der Artikel erscheint ungekürzt.

Weiterführende Links

Max-Planck-Institut für Intelligente Systeme homepage: http://www.is.mpg.de/

Research Network for Self-Organization of Robot Behavior http://robot.informatik.uni-leipzig.de/

The playful machine. http://playfulmachines.com.

Ralf Der & Georg Martius (2011): The playful machine. Theoretical Foundation and Practical Realization of Self-Organizing Robots (for personal use; Springer Verl. ) http://playfulmachines.com./the-playful-machine.pdf

Georg Martius (2013): Playful Machines - self-learning robots. Video 3:15 min. https://bit.ly/2McYvi5

Georg Martius (2015): Playful Machines Playful Machines - Robots learn coordinated behavior from scratch. Video 3:23 min. https://bit.ly/2MrZjMZ.

Georg Martius (2017): Playful Machines - Elastic tendon driven arm explores itself and its environment. Video 4:11 min. https://bit.ly/2OXAQAW

Google Accelerated Science. https://ai.google/research/teams/applied-science/gas/

Jürgen Schmidhuber: Vortrag „Künstliche Intelligenz wird alles ändern“ 2016, Video 49:17 min. https://www.youtube.com/watch?v=rafhHIQgd2A

Artikel im ScienceBlog

Ilse Kryspin-Exner, 31.01.2013: Assistive Technologien als Unterstützung von Aktivem Altern.

Francis S. Collins, 26.04.2018: Deep Learning: Wie man Computern beibringt, das Unsichtbare in lebenden Zellen zu "sehen".

- Printer-friendly version

- Log in to post comments