Roboter lernen die Welt entdecken

Roboter lernen die Welt entdeckenSa, 02.12.2023 — Roland Wengenmayr

Roboter können den Menschen heute bereits bei manchen alltäglichen Aufgaben unterstützen. Doch unbekannte Umgebungen oder auch kleine Abweichungen in den Aufgaben, auf die sie trainiert sind, überfordern sie. Damit sie rascher lernen, sich auf Neues einzustellen, entwickeln die Forschungsgruppen von Michael Mühlebach und Jörg Stückler am Max-Planck-Institut für Intelligente Systeme in Tübingen neue Trainingsmethoden für die Maschinen. Ihre Roboter müssen sich dabei auch im Pingpong oder Bodyflying bewähren.*

|

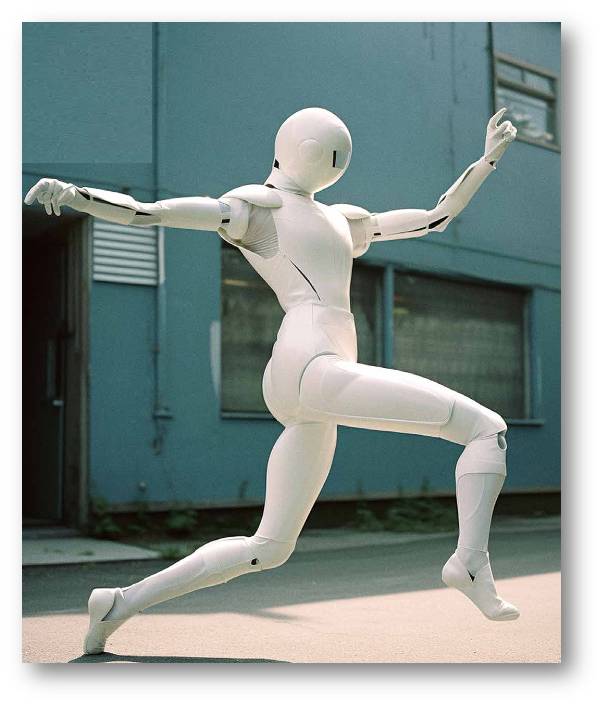

Anspruch und nicht Wirklichkeit: Bis Roboter so geschmeidig wie Menschen tanzen und dabei auch Bewegungen improvisieren können wie auf diesem mit KI erstellten Foto, wird es noch eine Weile dauern. Ihnen eine Art Körpergefühl zu vermitteln, ist ein Schritt in diese Richtung |

Intelligent handelnde Roboter waren schon ein Technikmythos, ehe es Maschinen gab, die diese Bezeichnung auch nur annähernd verdienten. Doch was können Roboter heute wirklich? Wie weit sind sie noch von Science-Fiction-Ikonen wie dem amüsant menschelnden C-3PO aus Star Wars entfernt? Bei der Suche auf Youtube landet man schnell bei einem Video der US-amerikanischen Roboterfirma Boston Dynamics. Darin verblüfft der humanoide Roboter Atlas mit Saltos, er rennt und hüpft mit einem Zwillingsbruder über einen anspruchsvollen Trainingsparcours oder unterstützt einen Menschen auf einem Baugerüst (Links zu Videos im Anhang; Anm. Redn.). Doch so beeindruckend leichtfüßig und fast unheimlich menschenähnlich sich diese Roboter auch bewegen können: Sie tun dies in einer vertrauten Umgebung, auf die sie trainiert worden sind. Wozu Atlas und Konsorten tatsächlich fähig wären, wenn sie sich in einem für sie komplett neuen Umfeld orientieren und selbstständig handeln müssten, das erfährt man nicht – Firmengeheimnis.

Joachim Hertzberg, wissenschaftlicher Direktor am Deutschen Forschungszentrum für Künstliche Intelligenz und Professor an der Universität Osnabrück, ist beeindruckt von der komplexen Bewegungsfähigkeit der Roboter von Boston Dynamics. Doch er wendet auch gleich ein: Würde man einem heutigen Roboter den Befehl geben, in einer ihm unbekannten Umgebung einen Auftrag selbstständig und planvoll auszuführen, und sei es nur, einen Kaffee zu holen, sähe das Resultat deutlich weniger spektakulär aus. „Das Gebiet heißt zwar künstliche Intelligenz, aber es kommt auf Intelligenz an, die wir selber für völlig unintelligent halten“, sagt Hertzberg, „also die Fähigkeit, sich in einer Umgebung vernünftig zurechtzufinden, Aufgaben zum ersten Mal zu machen, ohne sie zuvor geübt zu haben, situations- und zielangemessen zu handeln.“

Flexible Algorithmen

Einen Schritt hin zu Robotern, die auch in unbekannten Umgebungen und bei neuen Aufgaben die Orientierung behalten, machen Maschinen, die permanent lernen – und das möglichst schnell. An solchen Systemen arbeiten zwei Teams am Max-Planck-Institut für Intelligente Systeme in Tübingen. Anders als Unternehmen oder anwendungsorientierte Forschungseinrichtungen reduzieren die Forschenden die Komplexität der Aufgaben, die ihre Maschinen bewältigen müssen, um diesen zunächst elementare Aspekte der Orientierung beizubringen. Michael Mühlebachs Gruppe beschäftigt sich mit der Frage, wie Roboter durch Vorwissen über ihre eigenen physikalischen Eigenschaften, vermenschlicht ausgedrückt, eine Art Körpergefühl trainieren können. Denn dieses brauchen sie, um sich in einer unbekannten Umgebung bewegen und Befehle präzise ausführen zu können. Darum geht es auch in Jörg Stücklers Gruppe, die daran arbeitet, Robotern das Sehen beizubringen. Zum Sehen gehört, dass Roboter lernen, Objekte – ruhend und bewegt – in beliebiger Umgebung zu erkennen. Das Erkennen beschränkt sich hier allerdings auf rein physikalische Eigenschaften der Objekte, etwa ihre Größe, Form und Farbe, was allein schon eine gewaltige Herausforderung ist.

Ein permanent lernender Algorithmus steckt etwa im Tischtennisroboter Pamy, dessen Hardware weitgehend die Gruppe von Dieter Büchler am Tübinger Max-Planck-Institut entwickelt hat. Auf Veränderungen im Spiel muss Pamy nämlich flexibel reagieren. Einstweilen trainiert der einarmige Roboter mit einer Ballmaschine, um die künftige Flugbahn eines Balls richtig einschätzen zu lernen. Das Experiment befindet sich in einem Labor, in das Michael Mühlebach führt. Dort empfängt uns sein Doktorand Hao Ma in einer Geräuschkulisse, als wären wir im Trainingscamp einer Luftpumpenmannschaft gelandet.

Hao Ma muss angesichts des verblüfft dreinschauenden Gasts grinsen und deutet auf einen abgesperrten Bereich. Dort vollführt ein einzelner Roboterarm – Pamy ist einarmig – auf einer Art Podest mit einem Pingpong-Schläger laut schnaufend wilde Trockenübungen ohne Ball. Abbildung. Zwei Aluminiumrohre, verbunden mit Kunststoffgelenken, bilden Ober- und Unterarm, die Hand besteht aus einem Gelenk mit festgeschraubtem Schläger. Zu den Gelenken führen Luftschläuche, die unten im Podest an eine Batterie von Pneumatikzylindern angeschlossen sind. In den transparenten Zylindern sieht man Kolben auf und ab stampfen. Sie drücken Luft in die pneumatisch angetriebenen Gelenke hinein oder saugen sie ab und bewegen so den Arm.

|

Anspruch und nicht Wirklichkeit: Bis Roboter so geschmeidig wie Menschen tanzen und dabei auch Bewegungen improvisieren können wie auf diesem mit KI erstellten Foto, wird es noch eine Weile dauern. Ihnen eine Art Körpergefühl zu vermitteln, ist ein Schritt in diese Richtung. (Foto: Wolfram Scheible für MPG. © 2023, MPG) |

Solche luftdruckbetriebenen Muskeln erlauben eine sehr leichte Bauweise ohne Elektromotoren an den Gelenken, weshalb ein Roboterarm schnelle Bewegungen ausführen kann. Diese Konstruktion hat allerdings einen Nachteil: Der Arm federt sichtlich nach. Dieses elastische Verhalten muss die Steuerung genau kennen, um einen Tischtennisball präzise retournieren zu können. Das dafür nötige Körpergefühl erlernt Pamy gerade durch das Luft-Pingpong mithilfe von Kameras, Winkel- und Drucksensoren, die seine Bewegungen live verfolgen. Bei diesem Lernprozess kommt ein zentraler Forschungsansatz von Mühlebachs Team ins Spiel. Damit die Steuerung des Arms nicht mühsam bei null beginnen muss, wenn sie dessen Eigenschaften erlernt, hat das Team Pamy bereits mit einem einfachen physikalischen Modell programmiert. Es repräsentiert den Arm mit ideal steifen Stäben und idealisierten Gelenken. „Schwierig zu beschreiben ist aber das Verhalten der ,Muskeln‘ aus den Plastikbehältern, die sich mit Luft füllen“, erklärt Mühlebach: „Dafür setze ich maschinelles Lernen ein.“ Der dafür verwendete Algorithmus nutzt Kameraaufnahmen nur noch, um das Nachfedern der pneumatischen Bewegungen zu erlernen. Das spart viel Rechenzeit. Ohne das Vorwissen durch das physikalische Modell würde Pamy sechzehn Stunden benötigen, um eine Art Körpergefühl erlernen, sagt Mühlebach. „Mit dem Modell kriegen wir das in ungefähr einer Stunde hin.“ Roboterlernen durch physikalisches Vorwissen zu beschleunigen, ist dabei eine zentrale Strategie in Mühlebachs und Stücklers Forschung. Ma führt im Labor an eine Tischtennisplatte. Dort darf nun das Vorgängermodell des Roboterarms, der noch mit Luft-Pingpong beschäftigt ist, zeigen, was es kann. Eine drehbare Ballmaschine schießt einen Tischtennisball über die Platte, der springt in Pamys Feld einmal auf, ehe die Maschine ihn sauber zurückschlägt. Sie tut dies beeindruckend zuverlässig mit jedem neuen Ball. Ma zeigt auf vier Kameras, die oben über dem Tisch befestigt sind. Sie verfolgen die Bahn der leuchtend orangefarbenen Bälle. Ein Algorithmus hat inzwischen gelernt, die künftige Flugbahn eines Balls aus der bisherigen Bahnkurve so genau vorherzusagen, dass der Roboterarm wie ein geübter menschlicher Spieler reagiert und richtig trifft.

„In einer neuen Version der Ballvorhersage haben wir auch einbezogen, wie der Ball abgeschossen wird“, sagt Jörg Stückler. Das wäre bei einem menschlichen Gegner zwar ungleich schwieriger, doch die Erfahrung mit der Ballmaschine zeigt, wie das im Prinzip gehen könnte. Pamy kann nämlich auch auf Vorwissen über die Ballmaschine zurückgreifen. Das hat Jan Achterhold, Doktorand in Jörg Stücklers Team, dem Roboter beigebracht. Das entsprechende Modell berücksichtigt sogar, dass diese Maschine dem Ball einen Spin geben kann. Dadurch wird der Ball nach dem Aufsetzen im Feld des Roboterarms seitlich abgelenkt. Darauf muss Pamy sofort reagieren, was für den Roboter eine große Herausforderung ist.

Härtetest Bodyflying

Als Modell der Ballmaschine verwendeten Achterhold und Stückler dabei ein Grey-Box-Modell. Stückler erklärt, dies sei ein Zwischending zwischen einem Blackund einem White-Box-Modell. Das Black-Box-Modell steht für Maschinenlernen ohne jegliches Vorwissen, also mühsames Ausprobieren. Ein White-Box-Modell wäre das Gegenteil: ein unveränderlich programmiertes physikalisches Modell, das nicht lernfähig ist. In einer einfachen, mechanisch idealen Welt würde das auch funktionieren, denn der Ablauf inklusive Flugbahn ließe sich exakt berechnen. Doch bei einer echten Ballmaschine treten immer Effekte auf, an denen das unflexible White-Box-Modell scheitern würde. Das Team um Achterhold setzt daher auf ein physikalisch vorgebildetes Maschinenlernen. Zu diesem Zweck entwarfen die Forschenden zunächst ein physikalisches Modell und kombinierten es mit einem ausgefeilten Lernalgorithmus, der das System befähigt, die realen Eigenschaften der Ballmaschine zu erlernen. Das Team nutzte also die Vorteile des Black- und des White-Box-Ansatzes. „Deshalb wird der Ansatz Grey Box genannt“, erklärt Stückler. Im Gespräch mit den Roboterforschern wird immer wieder deutlich, welche Herausforderungen scheinbar simple Aktionen, die wir Menschen unbewusst und selbstverständlich ausführen, für die Robotik darstellen. Dabei will Michael Mühlebach es wirklich wissen. „Ich bin fasziniert vom Bodyflying, von der Akrobatik, den Drehungen und Kunststücken“, sagt er lachend: „Und da dachte ich: Es wäre doch super, das mit Robotern zu machen!“ Beim Bodyflying, auch Indoor Skydiving genannt, schweben Menschen im starken Luftstrom eines senkrecht nach oben gerichteten Windkanals. Wie beim Fallschirmsprung müssen sie lernen, wie sie ihr Flugverhalten auf dem Luftpolster durch Veränderungen ihrer Körperhaltung und damit der Aerodynamik gezielt steuern können.

Das soll in Tübingen nun ein leichter Flugroboter, kaum größer als eine Hand, über einem Miniwindkanal erlernen. Doktorand Ghadeer Elmkaiel tüftelt in seinem Labor gerade an dem selbst entwickelten Windkanal, der mit sechs kreisförmig angeordneten Propellern einen möglichst gleichmäßigen Luftstrom erzielen soll. Über der öffnung des Windkanals befindet sich eine Haltevorrichtung für den kleinen Flieger. Beim Training löst sich der Roboter davon und versucht, ohne Verbindung zu einem Computer zu schweben. Dabei soll er nach und nach vorgegebene Flugfiguren erlernen. Noch ist es nicht so weit, aber auch hier soll das Vorwissen eines einfachen physikalischen Modells den Lernprozess des Flugroboters beschleunigen.

Was Mühlebachs Team bei dem Härtetest der Orientierungsfähigkeit von Robotern lernt, könnte auch in ganz anderen Bereichen Anwendung finden – etwa bei intelligenten Stromnetzen. Sie sollen die Stromproduktion und -verteilung möglichst gut an den jeweiligen Bedarf anpassen. Das wird beim Ausbau dezentraler Windkraftund Solaranlagen, deren Stromproduktion zudem vom Wetter abhängt, immer wichtiger und anspruchsvoller. In einem solchen Netzwerk gibt es ebenfalls Elemente, die sich gut durch physikalische Modelle beschreiben lassen, und solche, deren Verhalten nur durch Lernerfahrung vorhersagbar wird. In die erste Kategorie fallen etwa Großkraftwerke, deren Stromproduktion sich physikalisch gut modellieren lässt. Der Strommarkt und das Verhalten der Endverbraucher hingegen sind erst durch Erfahrung, zum Beispiel über Jahreszeiten, vorhersagbar. „Dort gibt es ein Riesenpotenzial für maschinelles Lernen“, sagt Mühlebach. Doch zurück zur Orientierung. Jörg Stücklers Gruppe arbeitet zum Beispiel an der Weiterentwicklung einer Technik, welche Kameradaten kombiniert mit den Daten von Beschleunigungssensoren, wie sie auch in Smartphones eingebaut sind. Die Beschleunigungssensoren geben einem Roboter sozusagen einen Gleichgewichtssinn, erklärt Stückler. Durch die Kombination mit Kameradaten soll der Roboter ein Wissen darüber entwickeln, wie sein realer Körper auf einen Befehl reagiert. Soll er zum Beispiel losfahren, braucht er ein Gefühl dafür, dass er seine Masse zunächst auf die vorgegebene Geschwindigkeit beschleunigen muss. Dieses Körpergefühl entwickelt der Roboter viel schneller, wenn er mit einem einfachen physikalischen Modell von sich programmiert wurde.

Wenn ein Roboter mit Gegenständen hantieren soll, braucht er nicht nur ein gutes Gefühl für seine eigenen Bewegungen, er braucht auch eine Vorstellung von den Objekten und ihren Eigenschaften. Dass er diese allein durch Beobachtungen erkennen kann, ist das Ziel von Doktorand Michael Strecke. Da die Kameradaten verrauscht, also unscharf sind, lässt sich aus ihnen nicht einfach die Form oder die Größe eines Objekts herauslesen. Beobachtet der Roboter allerdings, wie eine immer wieder geworfene Kugel gegen eine Wand dotzt, zurückprallt und zu Boden fällt, lernt er trotzdem etwas über die Eigenschaften der Kugel. Er begreift allmählich, wie groß die Kugel ist und dass sie daher auf eine bestimmte Weise zurückprallt. So lernt er allein durch die Anschauung einzuschätzen, wie sich ein solches Objekt voraussichtlich verhalten wird.

Grundsätzlich lässt sich also aus dem reinen Beobachten des mechanischen Kontakts eines Objekts mit einem anderen auf deren Eigenschaften schließen. Kleinkinder lernen auf diese Weise, wenn sie Gegenstände herumschmeißen und diese beobachten. Wenn Computer sehen, funktionierte diese Kontaktmethode bislang nur für steife Objekte und auch nur für solche mit sehr einfacher Geometrie. Strecke und Stückler ist es jetzt mit einer neuen Optimierungsmethode gelungen, auch das maschinelle Erlernen komplexerer Formen voranzubringen. Sie veranschaulichen dies mit einem etwas absurden Beispiel: Eine Maschine beobachtet ein Objekt, das auf ein anderes fällt, und hält es zunächst für eine Kuh. Im Laufe mehrerer Zusammenstöße der beiden Objekte verwandelt sich die Kuh in der Maschinenwahrnehmung allmählich in eine Art „Badeentenschwimmring“, der wie bei einem Wurfringspiel mit seinem Loch in der Mitte auf einen Stab fällt. Was weit hergeholt erscheint, entspricht einer Situation, in der auch Menschen sich erst einmal völlig neu orientieren müssen. Roboter stehen hier noch ganz am Anfang, sozusagen im Stadium eines Kleinkinds, für das jedes Objekt in seiner Umwelt ganz neu ist. Mit ihren neuen Trainingsmethoden wollen Jörg Stückler und Michael Mühlebach den Maschinen helfen, sich in unbekannten Situationen schneller zu orientieren. Doch der Weg bis zu einem C-3PO, der sich in einem Star-Wars-Abenteuer bei seinem Begleiter R2-D2 beschwert, dass sie schon wieder in ein Schlamassel geraten seien, dürfte noch recht weit sein.

* Der kürzlich im Forschungsmagazin 3/2023 der Max-Planck Gesellschaft unter dem Titel "Roboter entdecken die Welt" erschienene Artikel https://www.mpg.de/20899916/MPF_2023_3.pdf wird - mit Ausnahme des Titels in praktisch unveränderter Form im ScienceBlog wiedergegeben. Die MPG-Pressestelle hat freundlicherweise der Veröffentlichung von Artikeln aus dem Forschungsmagazin auf unserer Seite zugestimmt. (© 2023, Max-Planck-Gesellschaft)

Videos zu Boston Dynamics

Blue Light Technology: Boston Dynamics' Atlas Bot SHOCKS Investors (2023). Video 8:37 min. https://www.youtube.com/watch?v=QKUosKzUCf8

Boston Dynamics: Do You Love Me? (2021). Video 2:54 min. https://www.youtube.com/watch?v=fn3KWM1kuAw&t=138s

Atlas Gets a Grip | Boston Dynamics (2023). Video 1:20 min. https://www.youtube.com/watch?v=-e1_QhJ1EhQ

Ähnliche Inhalte im ScienceBlog:

Paul Rainey, 02.11.2023: Können Mensch und Künstliche Intelligenz zu einer symbiotischen Einheit werden?

Inge Schuster, 12.12.2019: Transhumanismus - der Mensch steuert selbst seine Evolution

Georg Martius, 09.08.2018: Roboter mit eigenem Tatendrang

Francis S. Collins, 26.04.2018: Deep Learning: Wie man Computern beibringt, das Unsichtbare in lebenden Zellen zu "sehen".

Ilse Kryspin-Exner, 31.01.2013: Assistive Technologien als Unterstützung von Aktivem Altern.